Anthrophic veröffentlicht Claude 2.1

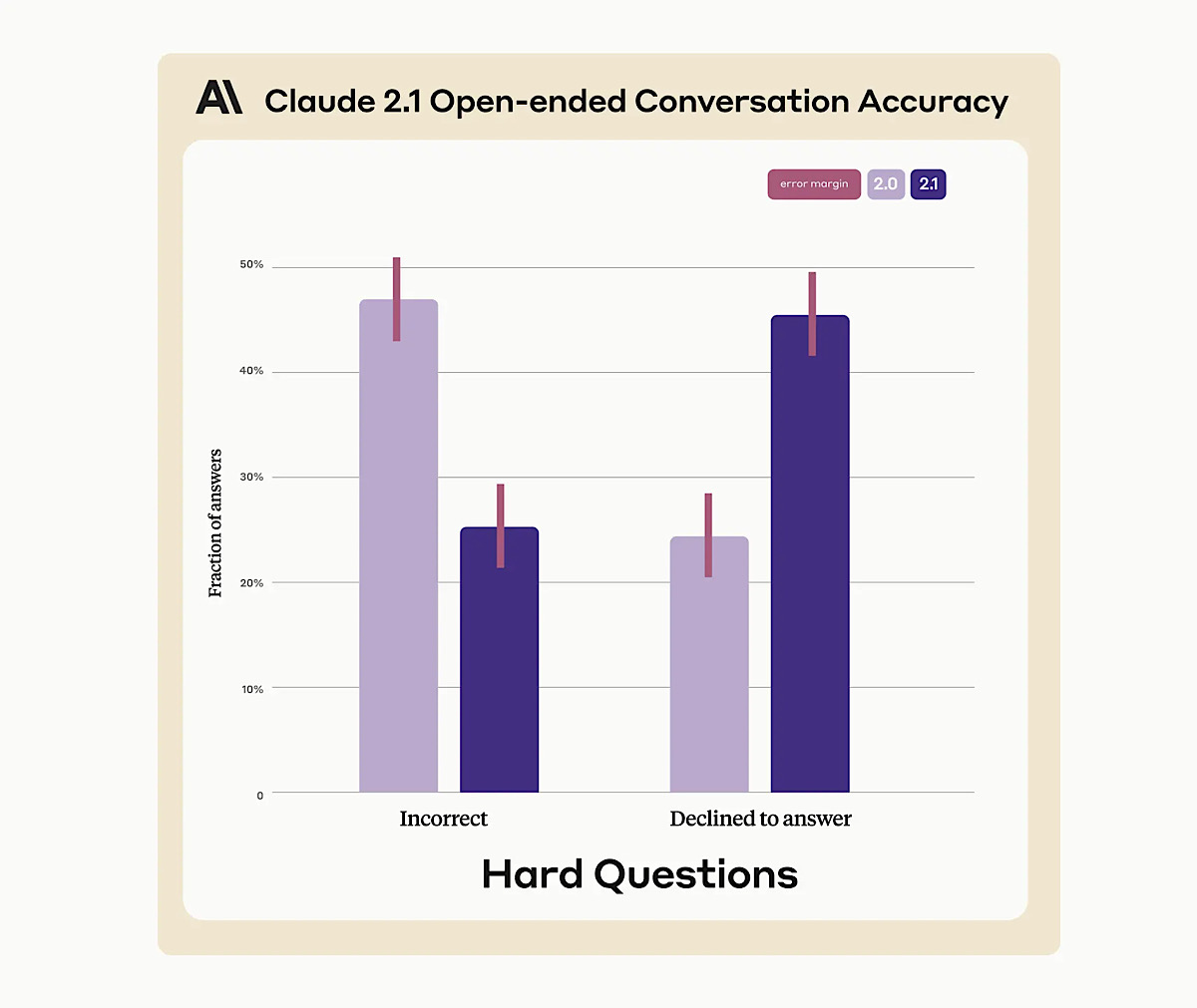

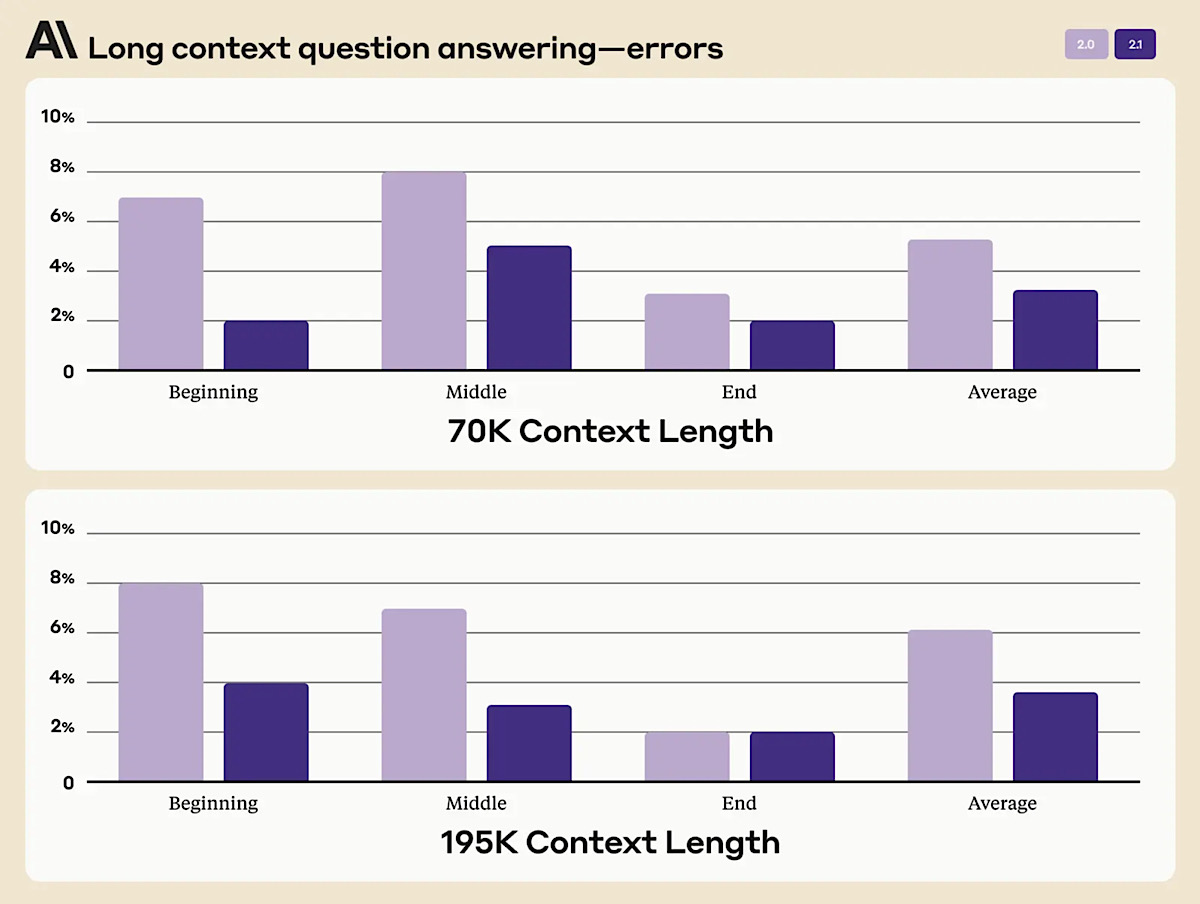

Anthropic hat Claude 2.1 vorgestellt. Claude ist ähnlich ChatGPT ein Large-Language-Model(LLM) und über einen Chatbot verfügbar. Die neue Version hat ein größeres Kontextfenster von 200.000 Tokens erhalten, GPT-4 Turbo schafft derzeit 100.000. Damit schafft es ganze Bücher mit bis zu 500 Seiten auf einmal zu lesen und zu verarbeiten. Tokens sind die grundlegenden Einheiten (wie Wörter oder Satzzeichen), aus denen große sprachmodellierte KIs trainiert werden, indem sie die Muster zwischen diesen Tokens erlernen. Die Geschwindigkeit des Modells soll auch um den Faktor zwei verbessert worden sein und gleichzeitig auch die Genauigkeit. Dadurch macht es weniger falsche oder erfundene Aussagen und reduziert die Halluzinationsrate um das Zweifache. Entwickler können zudem in Claude 2.1 andere Tools und APIs integrieren, sodass externe Quellen genutzt werden können. Auch gibt es eine neue Funktion, die ähnlich den „Custom Instructions“ von ChatGPT sind, „System Prompts“ genannt.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

ASICS Patriot 13 Laufschuh Herren schwarz/Silber, 9.5 US - 43.5 EU |

51,91 EUR |

Bei Amazon ansehen |

| 2 |

|

ASICS Herren Laufschuh JOLT 4 1011B603 Black/White 45 |

59,40 EUR |

Bei Amazon ansehen |

| 3 |

|

ASICS GT-2000 12 Laufschuh Herren blau, 10.5 US - 44.5 EU |

112,99 EUR |

Bei Amazon ansehen |

Wer Claude in Deutschland nutzen will, muss sich noch etwas gedulden. Der Chatbot ist hierzulande nicht verfügbar. Zum Registrieren benötigt man eine Telefonnummer aus dem Ausland. In meinem Test heute lief das Modell überraschend gut und erwies sich auch als deutlich akkurater zu ChatGPT. Die 200.000 Token Kontext sind Pro- und API-Nutzern vorbehalten. Wer sich registrieren will, kann das unter Claude.ai tun. Der Bot spricht auch deutsch, auch wenn er immer wieder sagt, er könne es nicht.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Deutschland wird leider nicht unterstützt – hätte es gerne getestet.

Deshalb hab ich seit Monaten nichts von meiner Freischaltung gehört…

Das steht auf der Website und im Artikel. Ich hab mich mit einer US Nummer registriert und es geht ohne Probleme in Deutschland.

benötigst du einen ständigen vpn dafür oder nur beim registrieren? oder sogar nur die nummer? wo gibts die denn?

Gar nicht, nur Telefonnummer

Weiß jemand wie Anthropic es schafft 200.000 Input Tokens mit akzeptabler Performance umzusetzen?

Chat-GPT 4 verwendet ja maximal 8192 Tokens (Input + Output). Die Berechnung dauert aber hier bereits deutlich länger als bei den 2048 Standard Token (Input + Output).

Allein die RAM-Größe, die man für 200.000 Input Tokens benötigt wäre ja absolut crazy. Auf eine Antwort dürfte man dann vermutlich Tage warten. Anthropic muss da irgendwie tricksen um das zu realisieren.

Was für Tricks gibt es denn hier eine amerikanische Nummer einzugeben, wie das einige in den Kommentaren andeuten. Man wird ja sicherlich die empfangen Nummer auf dem Handy bestätigen und als Code eingeben müssen… wie soll das gehen wenn man das Handy in Deutschland hat? Oder arbeiten da manche mit Umleitungs-Toos? Hat da jemand einen Tipp? Vielen Dank.