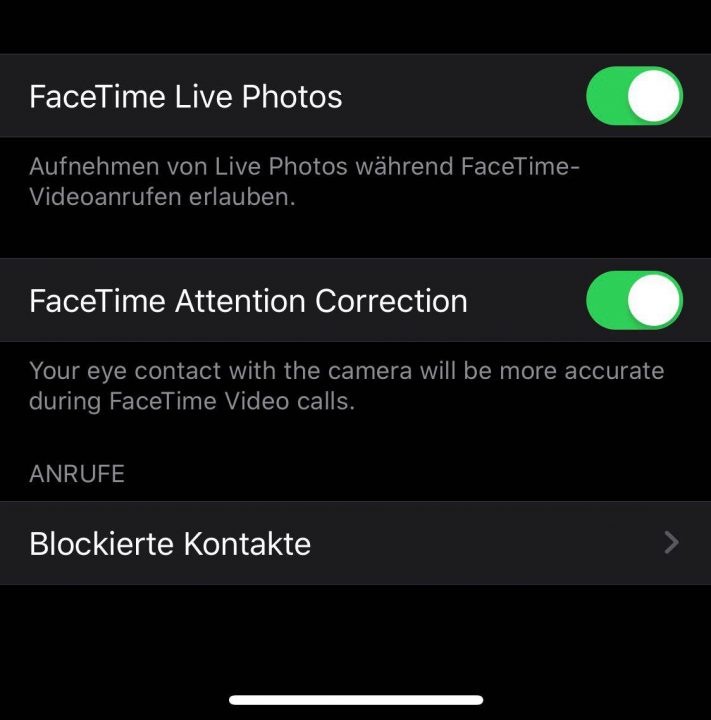

iOS 13 Funktion „FaceTime Attention Correction“: Video erklärt die neue Augenkorrektur in FaceTime

Apple hat am Dienstagabend die dritte Beta von iOS 13 veröffentlicht, die neuen Funktionen habe ich euch bereits in einem separaten Post zusammengefasst. Eines dieser Features ist eine neue Option in den FaceTime-Einstellungen, die sich „FaceTime Attention Correction“ nennt. Primär geht es bei der Funktion darum, die Augen künstlich so zu justieren, dass es aussieht, als ob ihr euer Gegenüber direkt anseht, obwohl ihr auf euren Bildschirm – also eigentlich leicht nach unten – schaut. Der Nutzen dieses Features mag sehr gering sei. Es ist jedoch so, dass sich Menschen besser angesprochen fühlen, wenn man sie ansieht. Macht den Video-Chat etwas persönlicher, ersetzt aber nie das direkte Gespräch.

Doch wie funktioniert das Ganze? iOS nutzt die Tiefendaten der True-Depth-Kamera des iPhone XS / XS Max und manipuliert die erkannten Augen, indem der Bereich leicht versetzt wird. Die Kollegen von MacRumors erklären das ziemlich gut und demonstrieren diese Verschiebung mit einem Strohhalm (2:30). Schaut doch mal rein und lasst gern eine Meinung da, was ihr von dieser Funktion haltet.

Super, dass es diese Funktion mit den aktuellen Geräten gibt. Hätte genauso gut sein können, dass sie der nächsten Generation der iPhones vorbehalten bleibt.

Deshalb hoffe ich, dass sie es auch auf die aktuellen iPad-Pro-Modelle schafft.

Meines Wissens nach ist das auch bei den neuen iPad Pros mit Face ID vorhanden.

“ iOS nutzt die Tiefendaten der True-Depth-Kamera des iPhone XS / XS Max“

XR & X bekommen das dann auch oder nicht?

Beim X bin ich mir nicht sicher, wegen der CPU.

Das Xr ist technisch Identisch mit dem XS und bekommt damit dieses Feature normalerweise auch.

Ich dachte, es sei andernorts schon mehrmals geschrieben worden, dass das XR ebenfalls damit beglückt wird; das X hingegen nicht.

Interessant, aber stark verbesserungswürdig. Sieht zwar besser als unter iOS12 aus aber, vom direkten Blick in der Kamera noch meilenweit entfernt…

… bis es hoffentlich Selfie-Kameras unter/im Glas in der Mitte des Geräts gibt.

Also für mich sieht das nicht nach „eye contact“ aus.

Um genau zu sein, nach der Beschreibung im Text bin ich vom eigentlichen Video doch recht enttäuscht – ich finde es ist kaum ein Unterschied wahrnehmbar, selbst im direkten Vergleich.