Google stellt riesigen Pool an HDR+-Fotos zur Verfügung

Google ist im Vergleich zu seinen Konkurrenten meiner Meinung nach am weitesten, wenn es um HDR+-Bildverarbeitung geht. Hinter den Bildern eines Pixel 2 und Co. steckt natürlich auch Googles Machine-Learning-Algorithmus, der aus den Fotos das Maximum herausholen soll. Um die Technologie weiter voranzutreiben, gibt Google Forschern und anderen Entwicklerteams nun die Chance, eine eigene Version von HDR+ zu entwickeln und diese mit Googles Lösung zu vergleichen.

Konkret stellt der Konzern aus Mountain View anderen Entwicklern einen riesigen Pool an Bildern zur Verfügung, der aus 3.640 sogenannten Burst Shots besteht, insgesamt 28.461 RAW-Bilder (DNG) in voller Auflösung. Die Bilder werden unter der Creative-Commons-Lizenz verteilt und können auch für kommerzielle Zwecke verwendet werden.

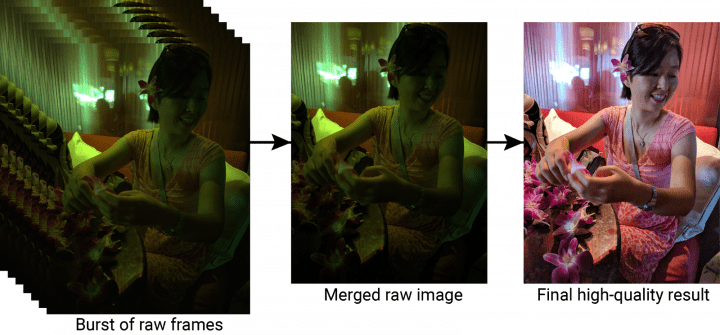

Ein HDR+-Bild ist im Endeffekt nichts anderes als eine, durch einen Algorithmus zusammengefasste, Version mehrerer Bilder, die schnell hintereinander aufgenommen wurden und unterschiedlich stark belichtet sind (Belichtungsreihe). Eben jener Algorithmus, in Googles Fall ein neuronales Netz, sorgt dafür, dass die sehr hellen und sehr dunklen Bereiche entsprechend scharf sind und viele Details zeigen. „Ausgebrannte“ Bereiche, die man beispielsweise oft im Himmel findet, sollen somit vermieden werden.

Wenn ihr Interesse an den Bildern habt, könnt ihr euch das Dataset mit eurem Google Account aus der Cloud herunterladen. Plant ein bisschen Zeit ein, denn mit insgesamt 765 GB wird der Download wohl etwas dauern.

Naja, die hellen und dunklen Bereiche müssen in jedem Bild einer Belichtungsreihe scharf sein, sonst kann der merger die unscharfen nicht verwenden. Es geht ja primär bei HDR darum den Dynamikumfang zu erhöhen.

Das Auge kann mehr „Blendenstufen“, also von ganz Dunkel zu ganz Hell erkennen und auflösen. Kameras können eben nicht so viele „Blendenstufen“ auflösen, sprich eine kleinere Dynamik im Bereich lala dunkel bis lala hell.

Dies kann man eben (für normale Kameras gesprochen) ein wenig tunen, indem man ein Bild unterbelichtet (zu kurze Auslösezeit), normal, und überbelichtet (zu lange Auslösezeit) macht. Diese drei haben dann die Chance das ich eben zb den Himmel nicht ausbrennen lassen muss (Teil des Himmels vom unterbelichteten Bild) und meine Person im Schatten unter dem Baum zu düster ist und ich dafür das überbelichtete Photo nehme.

Dabei bleiben Blendenzahl immer gleich! Weil ich sonst das Bokeh und meine Tiefenschärfe pro Bild ändere.

Im Handy natürlich eine super Sache weil es dort „unfairerweise“ unmengen an CPU Power pro Bild gibt und man einfach drauf halten kann und der Algorithmus zaubert daraus echt gute Ergebnisse.

/Dev

Ich finde HDR beim Handy eine tolle Funktion.

Die Ergebnisse von Google sehen echt beindrucked aus. Da sieht man was man mit Machine-Learning-Algorithmus erreichen kann. Ich kann mir gut vorstellen, dass in 5-10 Jahren auch unscharfe Fotos nachträglich scharf gemacht werden können. Der Algorithmus wird das schon richten.

… was Photoshop CC schon heute kann: Filter -> Sharpen -> Shake Reduction filter ;o)

Poste bitte mal einen Link zur Photoshop Camera App – finde ich gerade nicht.

Topic:

Eigentlich eine nette Sache von Google den Bilder Pool unter CC zur Verfügung zu stellen.

Wieso gibt es das Archiv nicht einfach als Google Fotos Album 😉