Synology DS1019+: Einen SSD-Cache aufbauen

Hier im Blog nutzen Caschy, Felix und ich NAS-Systeme von Synology. Ich habe auch QNAP ausprobiert, bin am Ende jedoch bei Synology hängen geblieben. Wer ein NAS zu Hause hat und oft auf dieselben Daten zugreift, hat sich sicher schon einmal gefragt, ob man die Geschwindigkeit der Ladevorgänge noch etwas optimieren könnte. Sei es der Rechner, oder ein NAS, man kann heutzutage ziemlich viel mit Hardware „erschlagen“, so auch in diesem Fall.

Üblicherweise kann man Ladevorgänge (auch Schreibvorgänge) durch sogenannte SSD-Caches optimieren. Da in NAS-Systemen fast immer sich drehende Platten verbaut sind, sind diese in der Geschwindigkeit wesentlich träger, als eine SSD. Der Vorteil der guten alten Festplatte ist jedoch die Zuverlässigkeit und Langlebigkeit – und am Ende vor allem der Preis. Synology bietet diverse Modelle an, die einen SSD-Cache unterstützen. Dieser ist quasi nichts anderes als ein wesentlich schnellerer Zwischenspeicher für Daten, die immer wieder genutzt werden.

Je nach Häufigkeit des Aufrufs und der Änderung unterscheidet ein System zwischen heißen, warmen, kalten oder archivierten (frozen) Daten. Wobei heiß und warm vorrangig im Cache gehalten werden. Möchte ein Nutzer nun auf eben jene Daten zugreifen, braucht das NAS diese nicht von der langsameren drehenden Platte lesen, sondern kann diese direkt aus dem Cache holen und dem Nutzer zur Verfügung stellen.

Bei Synology gibt es nun drei verschiedene Möglichkeiten einen solchen SSD-Cache einzubauen. Dabei könnt ihr entweder auf 2,5″-SSDs zurückgreifen, M.2-NVME-SSDs auf integrierten Steckplätzen verbauen oder ihr benötigt eine zusätzliche Karte, die M.2-SSDs fassen kann. Welche Variante ihr bei eurem NAS nutzen könnt, ist auf einer Synology-Support-Seite dokumentiert.

Ich persönlich habe eine Synology DS1019+ zu Hause, die zwei Steckplätze für M.2-SSDs beherbergt und zufälligerweise hatte ich noch eine 500 GB große Samsung EVO 970 herumliegen.

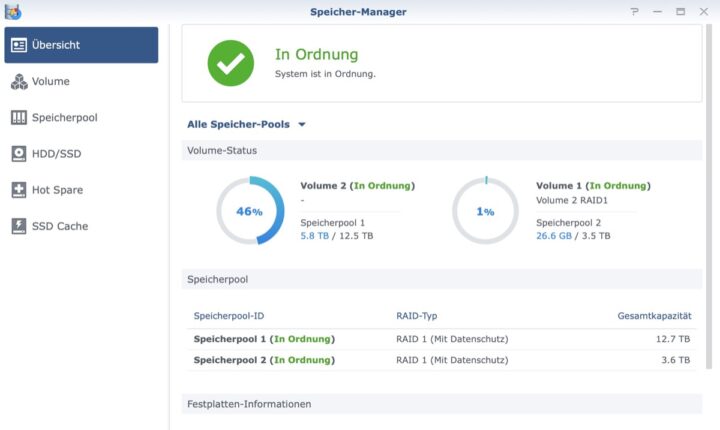

Bevor man nun einfach blind die SSD in das NAS einbaut, sollte man überprüfen, ob ein Cache überhaupt sinnvoll ist. Nicht immer ist das nämlich der Fall. Dazu findet ihr auf der Benutzeroberfläche der Synology im Speichermanager einen SSD-Cache-Ratgeber, der im SSD-Cache-Menü versteckt ist. In meiner NAS sind zwei Volumes eingerichtet, eines 12,5 TB und eines 3,5 TB groß.

Für jedes Volume könnte man einen SSD-Cache einrichten. Der Ratgeber analysiert, ob das sinnvoll ist und wie die Daten verteilt sind. Außerdem schlägt er euch auch direkt die passende Größe des Caches vor. In meinem Fall ist nur ein Cache für Volume 2 sinnvoll, der ist auch im Screenshot schon eingerichtet.

Doch bevor ihr die Tätigkeiten auf der Benutzeroberfläche erledigen könnt, müsst ihr mit den Erkenntnissen des Ratgebers die passende SSD einbauen. In meinem Fall wie gesagt keine 2,5″-SSD, sondern eine EVO 970 von Samsung. Die M.2-Slots sind bei der 1019+ am Boden verbaut worden und durch zwei Kunststoff-Deckel geschützt. Also kippt ihr das NAS, öffnet den Deckel und klickt die SSD ein. Deckel zu, NAS wieder an Ort und Stelle platzieren, fertig.

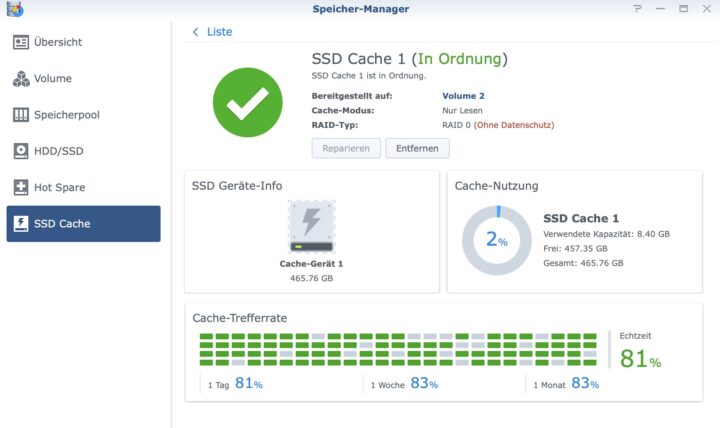

Nun könnt ihr im SSD-Cache-Menü die Einrichtung per Assistent durchklicken. Solltet ihr einen Lese-Schreib-Cache verwenden wollen, benötigt ihr zwei oder mehr SSDs. Auf einer SSD wird der Lese-Cache aufgebaut, eine zweite dient zum Wegschreiben der Daten, die dann asynchron auf die drehenden Festplatten zurückgeschrieben werden.

Ich habe nur einen Lese-Cache eingerichtet, der dann nach und nach seine Arbeit erledigen kann. Auf der Benutzeroberfläche findet ihr dann auch die Statistiken zur Trefferrate, die angibt, wie viele Requests eines Nutzers direkt aus dem Cache befriedigt werden konnten. Diese Rate liegt bei mir bei im Schnitt 83 Prozent. Da ich aktuell auch wenig mit dem NAS arbeite, ist die Cache-Nutzung auch nicht wirklich hoch.

Solltet ihr das NAS nur über WLAN ansprechen oder mit einem langsamen Ethernet arbeiten, dann wird euch der Cache nicht viel bringen. Denn wenn das NAS schnell ist, das Netzwerk aber langsam, bleibt das Netzwerk der Flaschenhals. Ein Cache kann vor allem bei der Nutzung von Virtualisierung per VM oder Docker nützlich sein, aber auch Datenbanken, die auf dem NAS laufen, profitieren davon. Solltet ihr euer NAS nur als Backup-Lösung oder Plex-Server nutzen, wird ein SSD-Cache wahrscheinlich eine „mit Kanonen auf Spatzen schießen“-Lösung sein. Solltet ihr sowieso eine SSD im Haus liegen haben, dann lohnt sich der Test sicher. Schaut aber vorher in der Kompatibilitätsliste nach, ob euer Gerät die SSD unterstützt.

Ebenfalls wichtig zu wissen: Melden die SMART-Werte der SSD, dass die errechnete „Lebensdauer“ verstrichen ist, so wird seitens Synology – zumindest im Falle des Write-Caches – der SSD-Cache auch dann deaktiviert, wenn diese faktisch noch läuft. Hängt natürlich ganz von der verwendeten SSD ab, kann aber vorkommen, dass diese schon binnen 2 Jahren nicht mehr als Cache zu gebrauchen ist. Je nach verwendeter SSD, trotz sinkender Preise, nicht unbedingt ein günstiges Unterfangen – da muss jeder den Kosten/-Nutzenvorteil für sich abwägen. Mit einer schnellen HDD ist dieser jedoch nur bei der Virtualisierung wirklich spürbar.

- Leistungsstarke SSD mit hohen Übertragungsgeschwindigkeiten für Gaming sowie 4K-Video- und...

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Ich habe das auf meiner DS1019 auch mal ausprobiert, dabei aber festgestellt, dass der Lese-Cache nach jedem Neustart neu befüllt wird. Da ich meine DS Nachts automatisch ausschalte hat das Feature leider nicht so den großen Nutzen für mich. Inzwischen habe ich per SSH ein SSD Volume aufgebaut. Das hat für mich den größeren Effekt.

Steht doch so in Post, dass der Cache nur bei bestimmten Einsatzzwecken wirklich hilft. Hast du bis zum Ende gelesen?

Randnotiz 1: Nicht nur der Betrieb von VMs, Docker, Datenbanken oder in Verbund mit iSCSI und einem VMWare ESXi profitiert vom Cache. Auch bei vielen kleinen Dateien ist der Zugriff teilweise deutlich schneller. Das kann zB auch Rollen wie den privaten Cloudspeicher Synology Drive deutlich verschnellern, wenn dieser viele Dateien indizieren muss. Auch wenn man immer auf die selben Dateien zugreift kann eine kleine SSD in einem freien Slot im Lesemodus etwas bringen. Experimentieren lohnt sich durchaus.

Randnotiz 2: In der Übersicht der SSD-Caches gibt es oben unter „Optionen“ einen Schalter. Dieser legt fest ob der Cache sequenzielle Zugriffe ignorieren soll. Standardmäßig ist dieser an um die SSDs zu schonen. Wer zB große Videodaten lesen/schreiben möchte, sollte sich nicht wundern, wenn der Cache standardmäßig übersprungen wird. Das beeinflusst leider auch die Images von der iSCSI-Rolle!

Randnottiz 3: Billige 2.5″-SSDs wie die Samsung Evo können innerhalb kürzester Zeit im Schreibcache sterben. Das liegt nicht nur an den Schreibzyklen sondern vor allem an den Temperaturen die sie dabei erreichen. (Teilweise >60°C) Also Finger weg vor billigem TLC-Speicher. M.2-SSDs haben außerdem den Vorteil, dass sie bei Synology-Geräten physisch etwas getrennt eingebaut und damit besser gekühlt werden.

Wie sollten VMs davon profitieren? Der Cache ist nur bei Transfers aktiv und sicher nicht innerhalb eines VM Images. Daher ist der Syno SSD Cache auch total Banane. Erst wenn er wie bei Unraid konfiguriert werden kann, macht er Sinn. Dort ist der SSD Cache nämlich bei jedem Share und damit auch den VMs frei zuordnungsfähig und man kann selbst entscheiden welche Shares überhaupt die SSDs (ab)nutzen dürfen. Außerdem schlafen bei Unraid die Platten, wenn nur Daten von den SSDs abgerufen werden.

Bei einem RAID halte ich den SSD Cache aber eh für total Banane, weil er quasi keine Vorteile bringt. Entweder SSD only NAS oder schnelle HDDs. Mein Synology NAS mit 6x 7200rpm Platten hat 10G komplett ausgelastet (außer schreiben, was aber am schwachen RAID Controller der Syno lag und nicht an den HDDs).

Also ich hatte damit in der Praxis eindeutig merkbare und messbare Geschwindigkeitsvorteile in verschiedenen Serverrollen. Der Cache ist direkt Teil des RAIDs und kein Transfer-Cache und auch bei Einsatz von VMs eindeutig empfehlenswert. Die besagte Option zum Ignorieren sequentieller Zugriffe sollte aber deaktiviert sein.

Man kann die Notwendigkeit eines SSD Caches simpel beantworten. Wenn man nicht weiß, ob er Performance bringt, braucht man ihn eher nicht. Wer sein NAS als Datengrab für Backups oder als Quelle für Kodi oder Plex nutzt, wird kaum davon profitieren. Die Geschwindigkeitsgewinne für VMs oder iSCSI halte ich für passabel, allerdings sind reine SSDs immer noch um ein Vielfaches schneller. Und Fliegen wird so ein NAS deswegen auch nicht, dazu sind die Prozessoren viel zu schwach.

Ich würde über einen SSD Cache dann nachdenken, wenn man umfangreiche Bilderordner sondiert oder die internen Synology Dienste ausgiebig nutzt wie Synology Drive, Cloud Station oder Moments. Dann müssen da aber schon hunderte Gigabyte an Daten liegen, so dass sich das lohnt.

Meine 918+ betreibe ich mit 2x250GB 970 EVOs und kann trotz vieler Versuche keinen wirklichen Gewinn an Geschwindigkeit feststellen. Allenfalls fühlt sich die GUI etwas flüssiger an oder Apps starten etwas flotter.

Heute würde ich keinen SSD Cache mehr einsetzen. Jetzt wo die SSDs einmal da sind, bleiben sie aber drin.

Wir setzen einen SSD-Lese- und Schreibcache auf einer DS918+ ein. Bei uns greifen verschiedene Windows-Clients auf diverse Datenbanken zu, die alle auf dem NAS liegen. Dabei werden jeweils nur sehr kleine Datenmengen übertragen, aber trotzdem hat der Cache einen massiven Geschwindigkeitsschub gebracht, da die SSD natürlich viel niedrigere Zugriffszeiten als die HDDs hat. Die Gedenksekunden haben sich seitdem merklich reduziert. Wer solche speziellen Anwendungen nicht nutzt, kann aber wohl darauf verzichten.