Samsung rechtfertigt Vorgehensweise rund um die Mond-Fotografie

Olli hatte das Thema schon aufgegriffen: Es gibt derzeit Kontroversen um die Mond-Fotografie an den Smartphones der Reihe Samsung Galaxy S23. So konnte ein User, bricht man es kurz und einfach herunter, nachweisen, dass mit ausgefuchsten Algorithmen beim Knipsen des Mondes künstlich Details hinzugerechnet werden, die über die eigentliche Kamera-Optik nicht ihren Weg ins Bild finden können. Es ist vor allem ein Software-Kniff, der hier den Unterschied macht. In einem neuen Blog-Post rechtfertigen die Südkoreaner ihre Vorgehensweise.

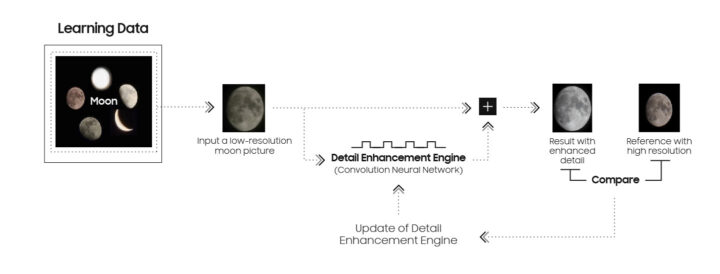

Dabei betitelt man das Ganze allerdings nicht als Schuldeingeständnis oder als Verteidigung gegen die Vorwürfe, sondern als Erklärung seiner Vorgehensweise. Samsung gibt an, dass man seit der Reihe der Galaxy S21 einen sogenannten Scene Optimizer nutze, der eben auch den Mond als Objekt auf Fotos erkenne. Mit vielen Worten gibt man dabei im Grunde zu, dass die wesentlichen Bildverbesserungen über eine KI-Engine erzielt werden. Allerdings vermeidet man es, zuzugeben, dass die Algorithmen in den Bildern abwesende Details komplett neu hinzufügen. Stattdessen spricht man ausdrücklich nur von einer Aufwertung / Erweiterung der Bilddetails.

Gleichzeitig nutze man aber sehr wohl auch die Hardware, um mehr als 10 Bilder des Mondes bei 25-fachem oder höherem Zoom anzufertigen. Über die Funktionen Super Resolution und Multi-Frame-Fotografie kombiniere man dann mehrere Aufnahmen, die anschließend über den Scene Optimiser feingeschliffen werden, wenn dieser aktiviert ist und der Mond erkannt werde. Die KI-Engine im Hintergrund sei mit etlichen Bildern des Mondes gefüttert worden, um die besten Ergebnisse zu erzielen.

Kombiniert, ermöglichen es dann Super Resolution und der Scene Optimiser die bekannten Fotos des Mondes zu erstellen. Super Resolution, Multi-Frame-Verarbeitung und KI-Technologien spielen hier also laut Samsung alle zusammen. Kritiker werden aber nun bemängeln, dass nachgewiesen werden konnte, dass die Algorithmen Details eben nicht nur „verbessern“, sondern komplett neu ins Bild einfügen. Genau diesen Punkt umschifft Samsung explizit in seiner neuen Erklärung.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

Samsung Galaxy S23 SM-S911BZKDEUB | 430,78 EUR | Bei Amazon ansehen |

| 2 |

|

Samsung Galaxy S23 AI-Android-Smartphone, 256GB, 3.900mAh Akku, Smartphone ohne Vertrag Phantom... | 479,99 EUR | Bei Amazon ansehen |

| 3 |

|

Samsung Galaxy S23 128GB Phantom Black (SIM sim + e-SIM) (Generalüberholt) | 351,53 EUR | Bei Amazon ansehen |

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Ich frage mich wozu der Aufwand? Wie viele Mond Fotos soll man denn machen? 10 Bilder maximal für 1 Motiv vom Mond reichen mir. Ich sammele doch keine Mond Fotos. Da gibt es interessantere Motive.

Na um die Kamera und damit das ganze Gerät zu bewerben:

„Das kann dein iPhone nicht, du brauchst dieses Samsung!“

Wenn es nicht aufgeflogen wäre würden auch viele Tester den tollen Zoom lobend erwähnen.

PR und Marketing. Im Smartphone-Bereich gibt es schon lange kein „next big thing“ mehr, da werden halt solche Features als Anreiz genommen um neue Modelle zu verkaufen.

Naja, wäre ja mal einen Versuch wert, mit dem S23 einen Mond Transit der ISS zu fotografieren. Was die KI dann aus dem Foto macht? https://transit-finder.com

Mrwhosetheboss hat das quasi in seinem aktuellen Video gemacht.

Der Mond wurde verbessert, das eingefügte Element wurde mit der Mondtextur versehen.

Wenn man es etwas weiter spinnt, könnte man dem Algorithmus auch beibringen, hässliche Visagen auf einem Foto durch die von Models „aufzuwerten“.

Besser nicht, sonst wird es demnächst Klagen hässlicher Menschen gegen Spiegelhersteller geben, weil sie meinen, dass der Spiegel lügt..

Es gibt keine hässlichen Menschen

Es gibt schöne Menschen und nicht schöne Menschen.

Noch nie einem hübschen Menschen hinterhergeschaut? Siehste, auch du differenzierst da sehr wohl! 🙂

Das machen die meisten Handys bereits heute! Bei Portraitmode werden in der Regel einige Filter auf das Gesicht angewendet.

Am Vorgehen Samsungs ist nichts auszusetzen. Jede AI-Verbesserung eines Bildes erzeugt am Ende Details die das Foto so eigentlich nicht hatte, das ist schon seit Jahren so. Die Möglichkeiten werden nur immer besser.

Von Betrug kann keine Rede sein, und so lange es sich auch bei Bedarf deaktivieren lässt ist auch userfreundlich.

Zudem sieht der Mond, abgesehen von der Phase, immer gleich aus. Also, why not 🙂

Genau eigentlich zeigt die Aufregung, dass die Leute moderne computerunterstützte Fotografie nicht verstehen.

Stimmt einfach nicht. Der Kamera wurde ein komplett unscharfes Bild des Mondes zum fotografieren gegeben, die hat erkannt „es ist der Mond“ und hat Details aus der Datenbank einfach „dazu gedichtet“. Das hat nichts mit der Auflösung des Sensors, der Qualität der Optik etc. zu tun, es ist schlicht und ergreifend Betrug. Oder erwartest Du, dass Dein Smartphone alte Bilder von Dir durchgeht und das aktuelle Bild neu verdichtet damit es besser aussieht? Ich wundere mich schon wie gelassen einige reagieren. Gerade Samsung ist ein Pappenheimer die schon sehr häuft mit „kreativen“ Lösungen für Benchmarks etc. aufgefallen sind. Kann natürlich sein, dass Du ein Ultra hast und bisher begeistert Freunden Deine Mond Fotos gezeigt hat (hat ein Freund von mir kürzlich auch gemacht…… ich habe ihm schon damals gesagt er solle mal das Internet abklemmen, ab das Ergebnis das Gleiche ist).

Bin auch der Meinung dass Samsung mal wieder erwischt wurde und sich irgendwie rauswinden will.

Leider hast du hier wiederum keine Ahnung. Das Abgleichen mit Daten aus anderen Quellen ist Standard bei jeder AI- Bildverbesserung. Mit deiner Begründung müsstest du bereits jedes Foto auf deinem Smartphone löschen.

Dein letzter Satz ist wiederum ein schäbiger Versuch der Unterstellung und Diskreditierung, jeder weitere Kommentar erübrigt sich hier.

Das ist kompletter Quatsch, Du behauptest „Das Abgleichen mit Daten aus anderen Quellen ist Standard bei jeder AI- Bildverbesserung.“ das stimmt bei Smartphones schlicht und ergreifend nicht. Nicht mal Samsung gibt es in seinem Statement zu (siehe letzter Absatz) das fremde Daten dazu gedichtet wurden.

Der Begriff „fremde Daten“ ist in diesem Zusammenhang nicht hilfreich. Wenn Google dein Gesicht schärft und deine Zahnreihe plötzlich nicht mehr zu deiner wirklichen Zahnreihe passt, dann hat der Algorithmus nicht einfach ein fremdes Lachen kopiert, sondern er hat das Lachen erfunden. Und zwar auf der Basis von Trainingsdaten, denn nichts anderes ist das Konzept der Zähne im Algorithmus.

„Fremde Daten“? Nein. Vermeintlich echte Bildinformationen? .. auch nein.

Dann sollen die damit auch transparent sein, und nicht dem Kunden über das Marketing vorgaukeln, dass diese Ergebnisse rein über die Optik erzielt wurden.

Nahezu jeder ist auf diese Täuschung Samsungs reingefallen, natürlich werden die dafür kritisiert.

Gut, „Mond-Gate“ geklärt. Langsam wäre mal eine Aussage zum „S23 Kamera Gate“ an der Reihe. Keine Aussagen was die nun machen wollen. Es geht nicht um Einzelfälle, es geht um viele. Selbst das Austauschhandy machte Bilder mit Unschärfen wo ein A52s und iphone8 besser sind.

Es war gleich klar, dass es nur so laufen konnte – auch weil der Mond der Erde ja immer dieselbe Seite zeigt. Leicht verdientes Geld. Samsung hat in dieser Hinsicht eine “Geschichte”.

Wer erinnert sich noch an die Stockphotos, die Samsung als Beispiele der S8-Kamera verkaufen wollte?

https://finance.yahoo.com/news/samsung-caught-using-stock-photo-225250204.html

Oder an die Story mit den Benchmarks, weil das Gerät sofort übertaktete, sobald es den Start einer Benchmark-Software registrierte und damit unnatürlich hohe Werte produzierte, die in der Praxis nicht gehalten werden konnten?

https://bgr.com/tech/geekbench-bans-galaxy-s22-for-cheating-in-benchmark-tests/

Von Apple klauen und lügen: Das sind die Kernkompetenzen der Smartphone-Abteilung.

Samsung spielt da super in die Hände, dass man immer die gleiche Seite des Mondes sieht. 😉

Das ein komplett neues Bild generiert wird zeigen die Tests. Es wurde ein Bild des Mondes runter gepixelt und vom Monitor abfotografiert. Tada komplett neues Bild.

Ich habe mit Filtern/AI Verbesserungen kein Problem. Wenn man auch darauf hingewiesen wird und es ausschaltbar ist.

Es gibt inzwischen so viele Bilder auf denen alles mögliche vermutet wird weil man die Technik nicht versteht oder noch weniger kennt.

Man kann sich halt auch über jeden Mist beschweren. Da gehen Hersteller hin und versuchen dem Endverbraucher ein schönes Bild mittels AI zu erstellen und dann ist man doch wieder unzufrieden. Wer jetzt ankommt mit „ja aber ist ja dann nicht mehr das richtige Bild!1!Elf“.. Kollege, du kannst auch in raw Bilder machen. Dann haste nur Hardware und das was du einstellst, sofern du die automatik raus machst. Dann kannste alles so machen wie du es willst und hast vollen Zugriff auf die bilddatei. Aber ey, wir verteufeln lieber Samsung, weil sie dem User es einfacher machen wollen, Anständige Bilder zu machen aber zeitgleich nutzen wir chat gpt und feiern es total ab. Kommt klar Leute, echt.

Es ist genau das gleiche, was die ganzen globalen Lügner ( Trump, Putin Orban usw.) als normal empfinden:

Es ist halt nicht die Wahrheit, aber hey, schaut mal, wie geil ich die Wahrheit neu erfinden kann.

Nix anderes wie viele digitale Aufbereitungen – nehmen wir mal dolby Athmos – es wird akustischer Raum berechnet der nicht da ist. Im Studio aufgenommen und nach dem Athmos-Mix hört man die Aufnahme wie im Wembley-Stadion oder sonst einer Location die nur virtuell simuliert wird. Klänge sind Objekte die in einem virtuellen Hörraum placiert werden. Das ist genauso real wie der Mond über Wanne-Eickel vom Samsung-Smartphone. Der eine Betrug wird gefeirt der andere verdammt. Solange es gut klingt oder gut aussieht ist den meisten leuten der „Betrug“ egal – entscheidend ist was hinten rauskommt um ein Kohl-wort zu zitieren. Schön ist was gefällt.

Sorry, ich verstehe einige Kommentatoren einfach nicht. Für die scheint es völlig normal zu sein, dass der Smartphone Hersteller die Bilder mit FREMDEN Inhalten anreichert. Als ob ich ein Bild mache mit einem Baum im Hintergrund der ein paar gelbe Blätter hat, die einfach durch Grüne ausgetauscht werden. Das das Bild an sich per Software „aufgepimpt“ wird, klar das machen alle, aber NICHT fremde Inhalte einfügen. Es wird ja auch nicht im Netz nach einem besseren Portrait der fotografierten Person gesucht und das statt des Fotos nach der ausschweifenden Party genommen.

Samsung nutzt auch keine fremden Inhalte.

Die KI hat erkannt gewisse Inhalte zuzuordnen, somit wird dann die ist Situation an das bestehende Wissen angepasst.

Ein Hersteller der wenig auf KI-Fotografie setzt ist übrigens Sony.

Ich sehe das wie Andreas, das Endergebnis zählt. Es werden ja keine fremden Bilder hergenommen, lediglich die Deteils aus bekannten Bildern, um sein eigens Foto aufzupimpen. Und mal ehrlich: es ist der Mond! Als Erscheinung ändert der sich nicht von der Erde aus gesehen, bis auf seine Phasen. Bei Bäumen oder anderen einzigartigen Objekten wäre das was anderes 😉 da sieht kein Objekt gleich aus und man muss die bisherigen Optimierungen / Filter etc. nutzen oder geht halt selber ran. Aber mal Rolle rückwärts: ist das abschaltbar? Ja? Wo ist das Problem? Alle Optimierungen abschalten und mal sehen, ob sich der Ottonormalo mit Belichtungszeit, ISO, Weißabgleich etc. wirklich herumschlagen will, oder ob es die KI dann hintenrum dann doch besser erledigt. Viel Wind um nix, mal wieder.

Es ist tatsächlich nicht abschaltbar, selbst die Apple RAW sind schon viel zu stark bearbeitet. Witzigerweise sind die mit Halide aufgenommen RAWs besser da unbearbeiteter…. aber da hört der Spaß dann langsam auf und ich nehme lieber die Systemkamera mit richtigem Sucher richtigem Objektiv mit Blende, großem Sensor, echter Lichtstärke echtem RAW und besserem Bildeindruck.

Aber selbst damit bekommst du den Mond (um beim eigentlichen Objekt des Anstoßes zu bleiben) nur mit technischen Nachhilfsmitteln wie Stacking und Photoshop bzw. dessen Alternativen hin. Aus der Hüfte heraus wird das auch mit nem ordentlichem Fotoequipment mit einem Einzelbild nix. Die Atmosphäre macht dir je nach Wetterlage einen gehörigen Strich durch die Rechnung. Je höher die Brennweite, umso schlimmer wirds.

2019: https://in.mashable.com/tech/3114/are-the-moon-shots-from-the-huawei-p30-pro-fake

Hallo Andi, schlimmer, die Huawei-Fotos sind kein Fake, sondern die bösen bösen Chinesen propfen den westlichen Ländern _Ihre_ Sichtweise des Mondes auf. So zumindest die Version der Verschwörungstheoretiker in NSA, CIA und anderen Institutionen, die chinesische Technologien als schädlich diffamieren und von unseren Märkten fernhalten wollen. Und klar: längst hat über Mondfotografien mit Hilfe von Huawei-Geräten der chinesische Geheimdienst ein genaues Bewegungsprofil des Mondes erarbeiten können ….

Beim S22 Ultra ist, trotz anders lautendem Versprechen, ein Foto mit Mond überhaupt nur möglich, wenn man andere nahe Details ins Bild bekommt, bspw. eine Baumkrone, ansonsten scheitert es immer schon am Fokus. Dann allerdings ist trotzdem nie der Mond scharf, sondern lediglich als jener erkennbar und nur tagsüber.

So wie es dämmert und natürlich nachts gibt es dann nur noch einen leuchtenden Kreis, da selbst mit maximaler Abdunkelung der Aufnahme der Mond immer zu hell erfasst wird.

Es ist kurz peinlich hier von Mondfotografie zu reden.

Das ist auch kein Drama, wie oft will man den Mond fotografieren?! Ich bin jedenfalls kein Fan.

Allgemein schwächelt Samsung immer schon und nach wie vor ab leichter Dämmerung, beim Weißabgleich so wie keine Sonne scheint oder blauer Himmel fehlt, Gesichtern und erst recht bei sich bewegenden Personen und Tieren. Allgemein ist die Technik zu lamgsam, so werden mit Zeit und Warten die Bilder fast immer besser, aber benannte Sachen nie gut.

Da muss ich leider an aktuelle Iphones verweisen, eine Freundin liegt damit immer vorn.