Nvidia stellt Blackwell-B200-GPU für KI-Anwendungen vor

Nvidia ist in dem letzten Jahr auf der KI-Welle geschwommen und hat seinen Unternehmenswert durch die Erfolge der Hardware, die zur Berechnung diverser KI-Tools benötigt wird, massiv erhöht. Mittlerweile hat man auch Amazon und Alphabet eingeholt. In der Nacht hat man jetzt den nächsten Schlag vorgestellt, die neue Blackwell-B200-GPU und den GB200-Superchip, die aktuell die leistungsfähigste Plattform für KI-Anwendungen darstellen sollen.

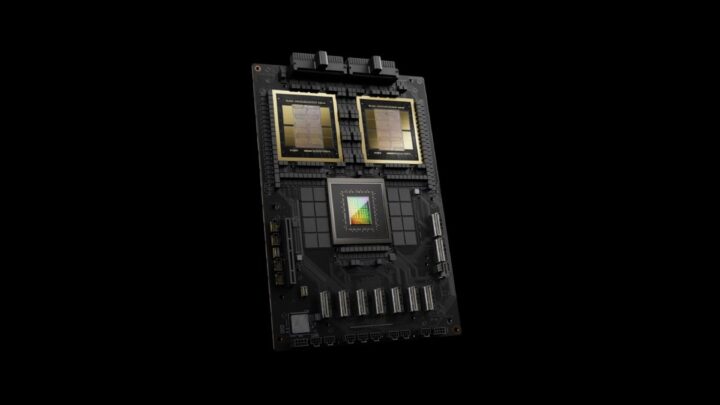

Die B200-GPU bringt 20 Petaflops an Leistung mit und besitzt 208 Milliarden Transistoren. Der GB200-Superchip kombiniert zwei dieser leistungsfähigen GPUs und kann wohl das bis zu 30-fache an Geschwindigkeit für LLM-Prozessierungen erreichen im Vergleich zur bisherigen Performance. Dazu kommt eine bessere Energieeffizienz. Nvidia spricht von einer Kostenreduktion von bis zu 25-mal im Vergleich zum H100-Chip. Zum Vergleich: Ein 1,8 Billionen Parameter großes Model zu trainieren, erforderte bisher 8.000 Hopper-GPUs und eine Leistung von 15 MW. Mit der neuen GPU sollen 2.000 Stück ausreichen bei einem Verbrauch von nur 4 MW. Nvidia geizt in der Pressemitteilung nicht mit Superlativen.

Das Unternehmen stellt große Racks zur Verfügung, die 36 oder 72 GPUs miteinander kombinieren und mit Flüssigkeit gekühlt werden. Damit lassen sich Modelle trainieren, die mehr als 10-mal so groß sind wie GPT-4. Amazon, Google, Microsoft und Oracle planen bereits, sich derartige Racks für ihre Kunden anzuschaffen. Es gibt auch große sogenannte DGX Superpods, die 288 CPUs, 576 GPUs und bis zu 240 TB an Hauptspeicher kombinieren. Da würden mich schon mal die Preise interessieren. Eben jene sind jedoch nicht bekannt.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Kleine Anmerkung zu einem sehr spannender Artikel Artikel : Ist mit MW Megawatt gemeint. Wenn es um den Verbrauch geht, wird in MWh gemessen. Im Artikel müsste dann statt MW MWh stehen. Geht es um die Leistung dann natürlich MW.

Die Zahlen beeindrucken mich immer wieder. 15MW hier, dort nur noch 4MW Strombedarf.

Gut, von der Stromvernichtung per Bitcoin & Co. reden wir erst garnicht.

Unsereins macht sich Gedanken wie man die paar tausend KW pro Jahr senken kann damit einen die Rechnung nicht auffrisst.

Es wird von der Energiewende geredet und gleichzeitig ein eigenes Kraftwerk für die KI gebraucht.

Irgendwie verrückt.

Ist ja aber nicht so als ob der weltweite Energiebedarf ansatzweise gestiegen wäre weil jetzt plötzlich KI-Modelle trainiert und ausgeführt werden würden.

Wenn jedes so ne Maschine zu Hause stehen haben würde, wäre es natürlich anders.

Sparen als Energiewende zu verkaufen ist der reinste Betrug. Es sollte darum gehen den ständig steigenden Bedarf durch möglichst kostengünstigen und wenig umweltschädlichen Strom zu decken und die Versorgungssicherheit zu garantieren. Haben uns nicht die Grünen erzählt, dass Sonne und Wind nix kosten? Und wir verfeuern stattdessen wieder mehr Kohle. Andere Länder sind da schon weiter weil sie langfristig planen. Auf 50-100 Jahre in die Zukunft, nicht nur von heute auf morgen.