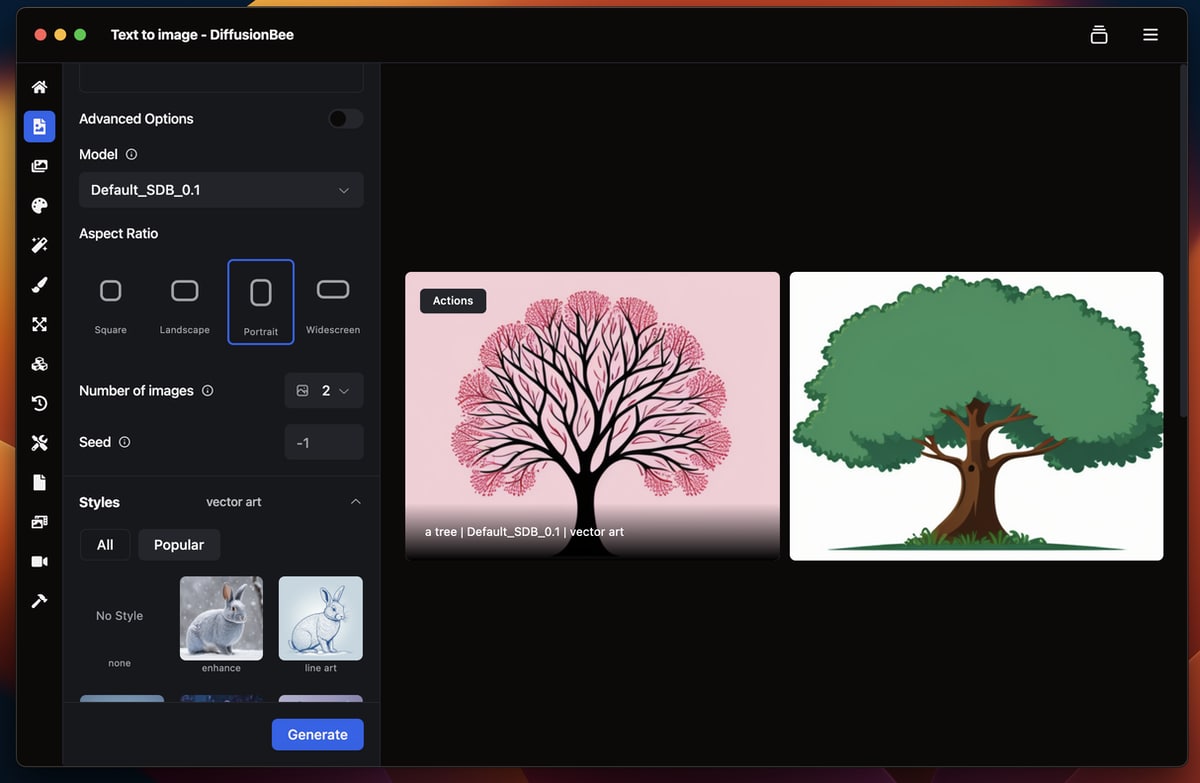

KI-Bilder erstellen: DiffusionBee 2.5 für macOS veröffentlicht

DiffusionBee ist ein Tool, das wir bereits in der Vergangenheit vorstellten und das auf der Technologie der stabilen Diffusionsmodelle basiert. Diese Modelle sind eine Form der künstlichen Intelligenz, die es ermöglicht, aus Textbeschreibungen Bilder zu generieren. Text rein, Bild raus. Nun ist die Version 2.5 veröffentlicht worden. Weiterhin ist DiffusionBee kostenfreie Open-Source-Software. Die Entwickler haben der Electron-Oberfläche einen neuen Anstrich verpasst. Ebenso sind unter der Haube Verbesserungen hinzugekommen, so gibt es LoRA-Unterstützung während der Generierung, einen Seed-Kompatibilitätsmodus und die Unterstützung für bfloat16 in LoRA. Zum Einstieg wirklich ein nettes Werkzeug, gerade, wenn man nicht auf andere (kostenpflichtige) Anbieter zurückgreifen möchte.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Da ich es auch nachschauen musste, die Erklärung von ChatGPT:

LoRA-Unterstützung während der Generierung:

LoRA steht für „Low-Rank Adaptation“. Es ist eine Technik, die in maschinellem Lernen und insbesondere bei großen Modellen wie Stable Diffusion verwendet wird, um effizientere Anpassungen vorzunehmen. Diese Unterstützung während der Generierung bedeutet wahrscheinlich, dass das Modell LoRA verwendet, um schneller und ressourcenschonender hochwertige Bilder zu erzeugen

Seed-Kompatibilitätsmodus:

Ein „Seed“ ist in der Computergrafik eine Art Startpunkt für Zufallsprozesse. Ein Seed-Kompatibilitätsmodus würde es Benutzern ermöglichen, denselben Seed zu verwenden, um konsistente oder wiederholbare Ergebnisse zu erzielen. Das ist nützlich, wenn man kleine Variationen eines Bildes erzeugen möchte, ohne das Gesamtbild stark zu verändern.

Unterstützung für bfloat16 in LoRA:

bfloat16 ist ein numerisches Format, das hauptsächlich in maschinellem Lernen für die Darstellung von Zahlen verwendet wird. Es bietet einen Kompromiss zwischen der Reichweite von Float32 und der Performance von niedrigeren Präzisionsformaten. Die Unterstützung von bfloat16 in LoRA deutet darauf hin, dass das Modell effizienter mit Ressourcen umgehen kann, was die Leistung verbessert, insbesondere auf Hardware, die dieses Format unterstützt.

Machen wir es noch erklärbärhafter:

In KI-Generationstools wie Midjourney, Dall-E oder Firefly hast du eine Version. Punkt.

In Stable Diffusion hast du eine Version und dann viele, viele unterstützende Tools.

Beispiel:

Die Grundversion des neusten freien Modells ist Stable Diffusion XL.

Gibt man dort jetzt einen Prompt ein, was für eine Grafik entstehen soll, kann die schon ganz ansehnlich sein, wird aber oft auch nur Murks.

Um da jetzt eine bestimmte Stilrichtung reinzubekommen, werden „Checkpoints“ oder „Fine tuned Models“ benutzt. Die beiden Begriffe sind identisch, kommt nur darauf an, auf welcher Seite sie benutzt.

Für einen Checkpoint hat ein Nutzer das Standardmodell Stable Diffusion XL genommen und mit einem Haufen / Tonnen weiterer Daten gefüttert, die das Ergebnis dann ganz anders aussehen lassen, als wenn ein Bild nur mit Stable Diffusion Standard generiert wurde. Beispielsweise eignen sich bestimmte Checkpoints mehr für die Generierung photorealistischer Arbeiten, andere für Landschaft und Architektur, andere für 3D Kunst oder sonstige Kunst usw.

Die nächste Ebene eines „fine tuned models“ oder „Checkpoints“ ist eine LoRa. Das ist quasi ebenfalls ein aus Bildmaterial generiertes „Minimodell“, das für einen bestimmten Zweck gebaut wurde. Nehmen wir mal an, es gibt eine LoRa „Train Realismus“, die ausschließlich auf die Darstellung realistischer Züge trainiert wurde.

Um bessere Ergebnisse zu erzielen, kann der Nutzer dann das Standardmodell Stable Diffusion XL mit einem entsprechenden Checkpoint (beispielsweise Juggernaut, der für Photorealismus bekannt ist) nehmen und zusätzlich noch die LoRa „Train Realismus“. Es gibt darunter noch weitere Hilfstools, wie Textual Inversions oder „Embedded“ (identisch mit Textual Inversions).

Da ich selbst aber mit vorherigen Versionen von Diffusion Bee nur Kokolores herausbekommen habe, hab ich das wieder deinstalliert.

Die Frage ist nicht, ob Diffusion Bee LoRas unterstützt, sondern vielmehr, ob Checkpoints unterstützt werden und welches Standard Modell von Stable Diffusion sich unter der Oberfläche verbirgt.

Mit Stable Diffusion 1.5 lassen sich ordentliche Bilder erstellen, wenn Checkpoints genutzt werden.

Version 2.5? Bin ich blind, der Download von der Seite für Apple Silicon ist Version 1.7.4. Technical Preview ist 2.2.1?

Über git gefunden https://github.com/divamgupta/diffusionbee-stable-diffusion-ui/releases

Da waren ja noch mehr updates seit der letzten Version auf der Seite. Danke. Warum die das nicht auf der Seite veröffentlichen…

ist das bequemer als „Draw Things“ im Handling?

Nachdem ich es bereits gelöscht hatte, weil die Ergebnisse so schlecht waren, habe ich nun die 2.5 ausprobiert. Die Ergebnisse sind leider total künstlich und nicht mal auf den ersten Blick glaubwürdig. Habe dann mal den gleichen Prompt bei Adobe Firefly eingegeben und sofort super Ergebnisse erhalten. Da ich mich bisher gescheut habe, Midjourney über Discord zu nutzen, habe ich nichtmal den Vergleich mit den vermutlich noch deutlich besseren Ergebnissen.

Yep, Diffusion Bee ist eine Katastrophe. Das taugt nicht mal zum Spielen, wie Cashy meint, weil man da schnell die Lust an den Ergebnissen verliert und dann vermutlich über einen Kamm mit anderen Tools schert.