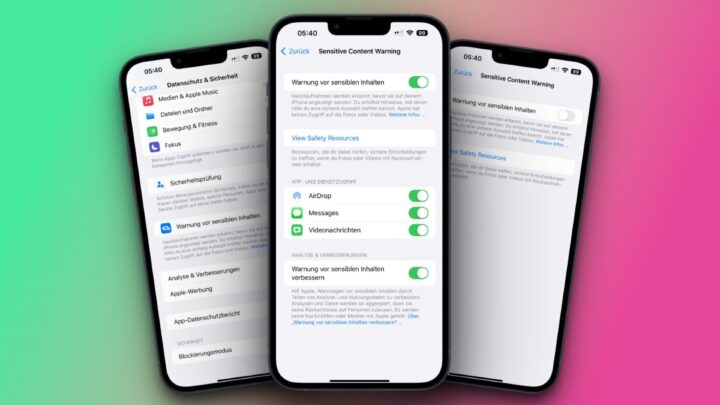

iOS 17: So aktiviert ihr die Warnung vor sensiblen Inhalten

Carsten informierte hier bereits darüber, dass iOS 17 neue Funktionen beinhaltet, um auch Erwachsene vor dem Erhalten von unerwünschten Nacktbildern zu schützen.

Um das Ganze zu aktivieren, besucht ihr die Einstellungen, springt ins Menü für „Datenschutz & Sicherheit“ und scrollte dann zum Punkt „Warnung vor sensiblen Inhalten“. Dort könnt ihr den Toggle dafür aktivieren. Tut ihr das, wird das iPhone auf eurem Gerät analysieren, welche Inhalte ihr per AirDrop, Messages oder in Videonachrichten bekommt. Erkennt man ein Nacktfoto, wird dieses mit einem Blur-Filter belegt, den man auf Wunsch entfernen und sich das Bild ansehen kann.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

@Olli, „sensitive“ würde ich eher mit „heikel“ oder „delikat“ übersetzen. Sensibel ist im deutschen Wortsinn ja eher das genaue Gegenteil :-).

Ja gut, aber es gibt ja Cremes für „sensitive Skin“, damit ist ja auch sensible und nicht delikate Haut gemeint.

Jau, aber da ein Wort viele Bedeutungen haben kann nimmt man halt die passende Übersetzung. Sensitive könnnte im passenden Kontext auch „zart“ oder „erregbar“ bedeuten, passt aber hier auch nicht.

Hi, guck mal in die Screenshots 😉

Nur weil die Übersetzer bei Apple das falsch machen, muss man das ja nicht übernehmen :-).

Wo wir gerade bei der Diskussion über Wortbedeutungen sind:

Ich finde es auch etwas unpassend zu sagen, dass man vor Nacktheit geschützt werden müsse, weil das impliziert, dass das etwas schädliches oder gefährliches wäre. 😉

Kann es im Einzelfall ja auch sein, unverlangte Dick-Pics zum Beispiel.

Der einzige Zweck dieser Anleitung war – hoffentlich -, dass man ab und zu mal kontrollieren kann, ob dieses Feature deaktiviert ist. Was ich sehen und nicht sehen möchte, und was für mich delikat ist und was nicht, entscheide ich immer noch selbst. Wer sowas einem Algorithmus überlässt, hat nun wahrlich die Kontrolle über sein Leben verloren…

Das ist dann doch etwas oberflächlich und plump. Für dich und mich mag das gelten, was du sagst, aber es gibt selbstverständlich auch traumatisierte Frauen/ Männer, die solche Trigger ganz gerne vermeiden würden.

Nunja, ehrlich gesagt… bei tatsächlich traumatisierten Personen dieses Thema einem Algorithmus zu überlassen, ist zumindest in meinem Universum ein nochmal deutlich größeres Problem als das, woran ich dachte…

Wahrscheinlichkeitsberechnende Algorithmen übernehmen doch schon jetzt viele Funktionen im Alltag, wie z. B. die Sturzerkennung der Apple Watch und die Tendenz wird in den kommenden Jahren steigen.

Diese Nacktbilderkennung ist lediglich eine optionale Unterstützung, die vermutlich von den meisten Menschen mangels Bedarf nicht aktiviert wird, aber selbst wenn sie lediglich 0,5% der Nutzer aktivieren, sind das schon eine Menge Leute.

Zur Funktion. es wird den Nutzern kein Bild kommentarlos verborgen, jedes Bild kann auf Wunsch sofort sichtbar gemacht werden und die Verarbeitung findet ausschließlich on device statt. Was ist daran in Deinem Universum ein großes Problem? Wenn die Erkennung erst mal jedes Bild mit einer Banane als sensiblen Inhalt erkennt, können wir gerne über einen unfähigen Algorithmus reden. 🙂

Apple bietet eine technische Lösung, die sich im Guten wie im Schlechten verwenden lässt. Vorher hatten Menschen die durch ungewollt zugesandte Nacktbilder belästigt wurden, keine Chance dagegen etwas zu tun, jetzt schon. Die Technik hilft ihnen, ein Stück Kontrolle über ihr Leben zurück zu bekommen.

Mich persönlich schockt ein Nacktbild auch nicht, da würden mir z.B. Bilder von toten Kindern viel mehr zusetzen. Aber das ist halt die US-amerikanisch geprägte Wahrnehmung und Kultur bei Apple, Nacktheit ist da ein stärkeres Tabu als Tod und Gewalt.