HeadGaze: Open-Source-Projekt von eBay lässt euch per Kopf-Tracking shoppen

In der heutigen Zeit freuen sich viele Menschen über neue Technik, Technologien und Software, die bisher noch nicht mögliche Dinge realisieren und so beispielsweise in Form eines ARKit oder ARCore virtuelle Inhalte in die reale Welt integrieren lassen. Doch es gibt auch immer noch genügend Menschen da draußen, denen schon damit geholfen wäre, wenn die vorhandene Technik für sie noch besser funktionieren würde.

Ein eben solches Szenario beschreibt Muratcan Cicek in einer Story auf ebayinc.com. Muratcan leidet an einer körperlichen Behinderung, die ihn derart einschränkt, dass er für viele Aufgaben des Alltags auf Hilfe angewiesen ist. In ihm wuchs der Drang, eigenständiger sein zu können als bisher. Und ein Praktikum bei eBay war für ihn dann die perfekte Gelegenheit, damit loszulegen.

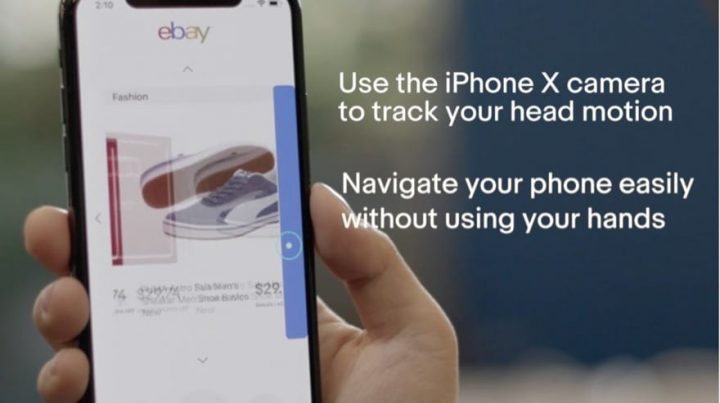

Während seines Praktikums hat Muratcan gemeinsam mit anderen an einer wiederverwendbaren Technologiebibliothek gearbeitet, die sich HeadGaze nennt und inzwischen bei GitHub für jedermann zur Verfügung steht. HeadGaze verbindet derzeit die Technologien von Apples ARKit und der Face ID-Sensorik des iPhone X, um Kopfbewegungen verfolgen zu können und das Handy so ohne Hände benutzbar zu machen.

Unser Team hat ein Modell entworfen, das einen virtuellen Stift erstellt, der der Bewegung Ihres Kopfes folgt (nach oben, unten, von Seite zu Seite), die 3D-Informationen des Kopfes aus ARKit entnimmt und 3D-Geometrie-Mapping anwendet, um die Position des „Cursors“ auf dem Bildschirm zu ermitteln. Darüber hinaus haben wir neue Widgets für die Benutzeroberfläche entwickelt und implementiert, die die „Cursor“-Interaktion erfassen und darauf reagieren. Ähnlich wie eine Maus den Cursor auf einem Desktop navigiert, können Sie mit diesem Design mit dem Kopf auf eine beliebige Stelle auf dem Bildschirm zeigen und bestimmte „Tasten“ aktivieren.

Dank modularem Code-Design soll es anderen Entwicklern besonders einfach gemacht werden, die Funktionen von HeadGaze in deren Anwendungen zu integrieren. Mit einfachen Kopfbewegungen lässt sich dann also scrollen, Aktionen beim längeren Verweilen auf einem Widget auslösen und anderweitig mit dem Bildschirminhalt interagieren. Dabei muss der Anwender nicht einmal zwingend körperlich eingeschränkt sein. Muratcan nennt weitere Beispiele, wie das Navigieren auf dem Handy beim Kochen, ohne das Display zu beschmutzen oder auch die Bedienung des Displays, wenn es eigentlich zu kalt draußen ist, um die Handschuhe auszuziehen.

Doch mit der Erkennung und Umsetzung der Kopfbewegungen soll noch nicht Schluss sein, teilt er mit. Aktuell erforsche das Team noch, wie sich Augenbewegungen mit der Hard- und Software genauso gut erkennen lassen, damit man diese kombiniert mit den Kopfbewegungen ein noch breiteres Aktionsspektrum ermöglichen.

Erinnert mich an das hier von Opera damals 😉

https://www.youtube.com/watch?v=kkNxbyp6thM

Genial! Schade, dass es sich nicht durchgesetzt hat