Google Colorize: Nachkolorierung für Fotos geht bald in die Beta

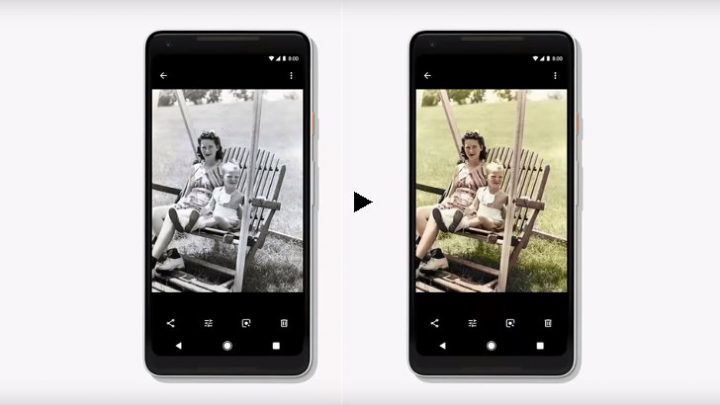

Google kündigt jedes Jahr auf der I/O neue Features an. Allerdings dauert es teilweise sehr lange, bis wir jene dann auch in der Praxis nutzen können. Ein solches Beispiel ist auch Colorize. Zur I/O 2018 von Google für Google Fotos vorgestellt, glänzt die Funktion immer noch durch Abwesenheit. Sie soll alte Schwarz-Weiß-Fotos nachkolorieren. Jetzt naht offenbar eine Beta.

So hat Google auf der I/O 2019, als genau ein volles Jahr nach der ursprünglichen Ankündigung, erklärt, dass man bereits eine Beta vorbereite, um Colorize dann mit teilnehmenden Nutzern zu optimieren. Google bewarb Colorize als eine der Anwendungsmöglichkeiten von Machine Learning durch TensorFlow.

2/ Here’s a photo of my 104yo grandmother on her wedding day, colorized with Google Photos on my phone. (You can see we have some work to do; my grandfather didn’t wear pink pants to his wedding!) pic.twitter.com/Ni8v0Bz3vg

— David Lieb (@dflieb) May 6, 2019

David Lieb, Googles Produktleiter für Fotos, hat bei Twitter erklärt, dass die Beta wohl nicht mehr so fern sei. Konkrete Zeitpläne nennt er aber auch nicht. Stattdessen hat er anhand eines Familienfotos betont, dass man noch etwas Arbeit vor sich habe, um Colorize zu optimieren. Da schätze ich, dass Google einfach etwas zu forsch nach vorne geprescht ist und mit Colorize letzten Endes eine Funktion in Aussicht stellte, die zur Ankündigung einfach noch zu weit entfernt von der Fertigstellung gewesen ist.

Dazu kommt sicherlich, dass Colorize ein wenig eine Nische bedient. Ich glaube nur relativ wenige Anwender werden sich ältere Schwarz-Weiß-Fotos auf ihr mobiles Endgerät hieven, um sie dann durch eine Nachkolorierung auch noch eines Teiles ihres Charmes zu berauben. Zumindest mir würde das eher nicht in den Sinn kommen. Findet ihr mehr Gefallen an der Funktion?

Im Einzelfall würde ich das schon mal nutzen. Viel interessanter fände ich aber die Möglichkeit, Filme nachzucolorieren. Es gibt einige gute Klassiker, die ich gerne in Farbe sehen möchte („Die Feuerzangenbowle“ mit Heinz Rühmann zum Beispiel). Bei Filmen finde ich s/w anstrengend.

Ok… Butter bei die Fische:

Wer hat auch auf das Bild geklickt und sich gewundert, dass kein Video startete?! -.-

xD

Ich überlege eher, woher die KI weiß, ob eine Hose weiß, rosa, grau oder beige ist auf einem S/W Foto…

Nicht falsch verstehen, ich finde das beeindruckend was Google da schafft. Dennoch würde es mich interessieren wie die KI arbeitet und Informationen die nicht da sind ermittelt.

Ein Aspekt ist, dass Farben nicht existieren. Es gibt nur unterschiedlich reflektierte Teile des Lichtspektrums, abhängig von der angestrahlten Oberfläche, die unser Sehsinn entsprechend interpretiert. Dementsprechend ist es auch nicht ganz korrekt wenn zB gesagt wird, dass dieses und jenes Tier keine Farben sehen könne. Dessen Hirn interpretiert die selben optischen Reize nur anders als unser Hirn, a priori gibt’s keine Farben. Und diese Information zur Oberflächenbeschaffenheit lässt sich teilweise auch aus s/w Aufnahmen extrapolieren und sozusagen nachvollziehen wie diese das Licht reflektiert hat. s/w und farbig liegen nicht soweit auseinander wie man instinktiv meinen sollte.

Das ganze wird dann damit kombiniert, dass die Systeme unzählige farbige und s/w Aufnahmen analysieren und daraus gewisse Dinge ableiten. Himmel ist blau, nicht rosa, Menschen haben hingegen selten blaue Gesichter…

beides für sich ist recht vage, legst du beide Prinzipien übereinander ist die Erkennung recht gut. Wenn es weit genug entwickelt ist.

Stark vereinfacht..

Wow, danke für die ausführliche Antwort.