Geekbench 6 für diverse Plattformen veröffentlicht

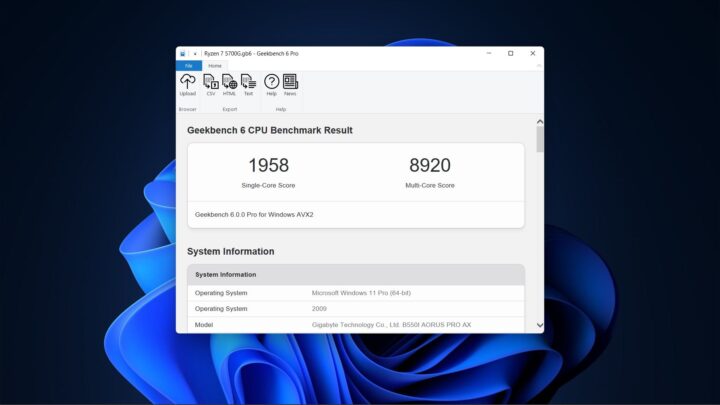

Primate Labs hat Geekbench 6 veröffentlicht. Das Benchmark-Tool steht ab sofort zum Download für die Betriebssysteme Android, iOS, Windows, macOS und Linux stramm. Den zentralen Downloadbereich findet ihr auf der Website der Entwickler hier. Ihr könnt euch aber auch bereits direkt in den entsprechenden Stores bedienen.

Es gibt Geekbench 6 einmal als kostenlose Free-Version oder auch in der Pro-Variante für 79 US-Dollar pro User. Da gibt es dann Sonderfunktionen wie die Chance, die Ergebnisse offline zu verwalten. Geekbench kann dabei die CPU- und GPU-Leistung auswerten. Laut den Entwicklern sei eine neue Version überfällig gewesen, da sich insbesondere im Bereich der Smartphones einiges getan habe.

Entsprechend hat man neue Tests integriert, die sich an der aktuellen Nutzung im Alltag orientieren und neue Workloads einbeziehen. Als Beispiele nennt Primate Labs das Verschwimmen von Hintergründen in Videotelefonaten, das automatische Entfernen unerwünschter Objekte in Fotos oder das Erkennen und Taggen von Objekten in Bildern via Machine Learning.

Man hat auch die Daten-Sets, die man als Basis nutzt, an aktuellere Maßstäbe angepasst. Das bedeutet, man legt etwa für die Bild-Tests höhere aufgelöste Fotos zugrunde oder umfangreichere Karten für die Navigations-Tests. Ebenfalls arbeitet man mit komplexeren Dokumenten für die PDF- und HTML5-Tests. Auch die Multicore-Benchmarks hat man generalüberholt. Statt einzelnen Kernen separate Tasks zuzuweisen, misst man nun, wie die Kerne sozusagen gemeinsam komplexere Aufgaben bearbeiten. Auf diese Weise kann man realistischer die Performance bewerten, da immer mehr SoCs sowohl Leistungs- als auch Effizienz-Kerne kombinieren.

Logisch, dass sich Primate Labs da direkt mit Lob durch Partner wie AMD, ARM, Qualcomm und mehr schmückt. Wenn ihr wollt, könnt ihr Geekbench 6 ja direkt mal ausprobieren und vergleichen, welche Punktzahlen das neue Benchmark-Tool eurem jeweiligen Gerät im direkten Vergleich mit Geekbench 5 zuweist.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

Apple iPhone 16e 128 GB: Entwickelt für Apple Intelligence, A18 Chip, Gigantische Batterielaufzeit,... |

579,00 EUR |

Bei Amazon ansehen |

| 2 |

|

Apple iPhone 15 (128 GB) - Schwarz |

649,00 EUR |

Bei Amazon ansehen |

| 3 |

|

Apple iPhone 15 (128 GB) - Blau |

676,90 EUR |

Bei Amazon ansehen |

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Wirklich erschreckend wie schlecht mein Intel i9 MacBook Pro 16″ (late 2019), 64GB gegenüber meinem 2021er MacBook Pro 14″ mit M1 Pro (10 (8 Leistung und 2 Effizienz cores) abschneidet …

Die ARM-Lösung trickst halt mit Hardwarebeschleunigung für z.B. Video.

Was heißt „trickst“ – ist einfach doppelt so effizient. Und wenn ich dan noch sehe, wie lange der M1 per Akku durchhält im Vergleich meiner Intel-Kiste

Wenn bei x86 die CPU ein Video kodieren muss, obwohl die GPU es könnte und bei ARM automatisch die optimierte GPU es macht, dann ist es schon eine Art tricksen.

„Tricksen“ ist hier wirklich der absolut falsche Begriff. Nur weil ein System für bestimmte Aufgaben bessere und optimierte Vorgehensweisen hat ist das kein Tricksen.

Anders sollte man in diesem Beispiel eigentlich sagen, dass der Ansatz der x86 schlicht und ergreifend ineffektiv ist.

Eben nicht, z.B. Windows 11 hat eine Video Encoding API mit GPU-Beschleunigung eingeführt, nutzt Geekbench jetzt diese Schnittstelle? Warum nutzt man bei bestimmten Systemen einen Hardware-Encoder und bei manchen einen Software-Encoder?

Ach Heiner – imn letzter Konsequenz zählt nur die Realität und nicht deine Verschwörungsvermutung. Nur dumm, dass mein Intel-Mac in der Realität nach spätestens 5,5 Stunden schlapp macht, während mein ARM Mac weitere 7 Stunden fröhlich vor sich hinwerkelt und sowohl seine Alltagsaufgaben, als auch herausforderndes einfach schneller erledigt … das ist natürlich echt miiiies von Apple, dass sie den Intel-Mac schon, in weiser Voraussicht, so ineffektiv und langsam gemacht haben …

Der Software-Encoder hat meinem Verständnis nach den Vorteil, dass er immer zur Verfügung steht, daher auch die Integration in Win11. Der Hardware Encoder setzt die notwendige Hardware voraus, ist daher nicht Systemübergreifend verfügbar.

Korrigiere mich, wenn ich falsch liege.

Ob und wie Geekbench hier arbeitet weiß ich nicht, da stellst du die Frage nicht an den Richtigen.

Wenn es in der Praxis faktisch Mehrwert bietet, dann hat das rein gar nichts mit „Tricksen“ zu tun. Man schafft mehr und bessere Resultate. Wie der Prozessor das „im Hintergrund“ macht, spielt dabei nicht wirklich eine Rolle.

Wenn ein Entwickler bei Nutzung einer vorhandenen API diese bei einen System verwendet und bei einem anderen System diese Funktion nicht nutzt, dann ist es sogar mehr als Tricksen sondern eher Manipulation!

iPhone 14 pro single c: 2524

Multi c: 6475

iPad air4: 2118 und 5243

Mbpro14 m1 8c: 2410 und 10621

Ja super, sie haben die Bewertung komplett geändert.

Jetzt hat man gar kein Gefühl mehr wie leistungsfähig eine bestimmte Hardware ist. Warum sollte z.B. Machine Learning Teil des CPU Benchmarks sein?

Wenn ich meine Geräte und deren Werte mit denen von Geekbench 5 Vergleiche, dann hat sich am Verhältnis quasi nichts geändert… was vorher 5% schneller war, ist auch jetzt 5% schneller.

Macht das ganze ziemlich sinnlos aber naja. Muss man echt nicht verstehen. Vor allem weil die Werte jetzt höher sind. Von Version 4 zu 5 war eins der Argumente für den neuen Benchmark, dass die Geräte zu schnell waren und die Werte entsprechend zu hoch ausfielen…

Dass man Machine Learning zur CPU hinzufügt ist aber wirklich irgendwie dämlich. Die NL ist ein dedizierter Teil des SoC, so wie die GPU und die wird ja auch einzeln bewertet.

Geekbench bevorzugt halt extrem integrierte Co-Prozessoren und somit ist es maximal als Systembenchmark nutzbar, wobei hier natürlich die voll integrierten Betriebssysteme profitieren. Da wird dann ein Befehl zum optimierten Co-Prozessor durchgereicht, allgemeinere Systeme müssen das alles dann auf der CPU berechnen und sehen dadurch unrealistisch schlecht aus. Dazu kommt das hier Single-Core und Single-Thread vermischt werden, welches z.B. SMT völlig ignoriert. In der Realität ist die Single-Core-Leistung von SMT-Systemen deshalb fast doppelt so schnell. Dazu hat Igor’s Lab einen interessanten Beitrag verfasst.

Was interessiert dich die SMT Performance? Sobald eine Anwendung 2 Threads nutzen kann, schaltet sich beim ARM einfach ein 2. physischer Kern dazu.

Single-Core-Leistung heißt Single-Thread-Leistung, denn nur die ist neben der kompletten Multi-Core-Leistung im Alltag relevant.

Es gibt einfach Aufgaben, die können nicht parallelisiert werden, da gibt es dann nur einen Thread. Da kannst du für x86 fähige SMT CPUs nicht einfach einen 2. Thread dazu erfinden, damit dieser ausgelastet ist.

MBA M2 8c: 2589 und 9803

Ein Benchmark kann nicht Plattformübergreifend funktionieren, dazu müsste der Code auf jeder Plattform genau gleich gut optimiert worden sein.

Es kommt deutlich mehr raus als vorher. Aber man kann weder den Verlauf einsehen noch Vergleiche machen mit anderen Geräten.

iPhone 13 Pro Max:

Single Core: 2144

Multi Core: 5265

Hatte immer die „Personal“ Version gekauft. Nun hat man in der Basisversion die Test History entfernt, sodass man nicht mehr sehen kann wie sich die verschiedenen Versionen des Betriebssysteme auf das Gerät auswirken. Alternative dazu ist nur ein kostenpflichtiges Business Abo für den ca. 8-fachen Preis (pro Jahr).

Danke für nichts…