Apple kündigt neue Schutzmaßnahmen für die Sicherheit von Kindern an

Das Unternehmen Apple hat heute eine Vorschau auf neue Kindersicherheitsfunktionen gegeben, die im Laufe des Jahres mit Software-Updates ausgespielt werden. Seitens Apple teilte man mit, dass die neuen Funktionen zunächst nur in den USA verfügbar sein werden.

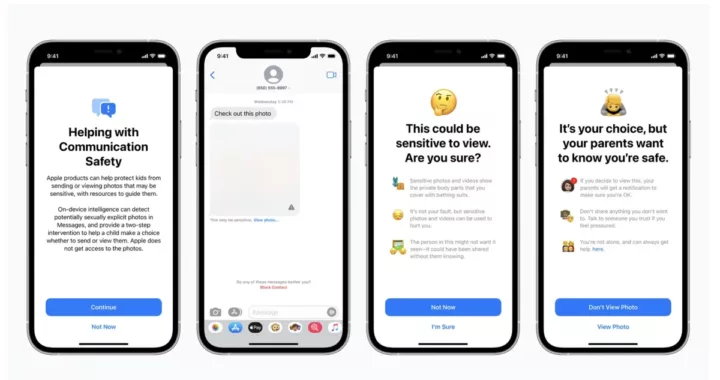

Die Nachrichten-App auf dem iPhone, iPad und Mac wird eine neue Kommunikations-Sicherheitsfunktion erhalten, die Kinder und ihre Eltern warnt, wenn sie eindeutige Fotos mit sexuellen Darstellungen erhalten oder versenden. Laut Apple werde die Nachrichten-App maschinelles Lernen auf dem Gerät verwenden, um Bildanhänge zu analysieren. Wenn ein Foto als sexuell explizit eingestuft wird, wird das Foto automatisch unscharf und das Kind wird gewarnt.

Sollte ein Kind versuchen, ein als sensibel gekennzeichnetes Foto in der Nachrichten-App anzusehen, wird es gewarnt, dass das Foto möglicherweise Nacktheit enthält und verletzend wirken kann. Je nach Alter des Kindes können die Eltern auch eine Benachrichtigung erhalten, wenn ein solches Bild ankommt oder verschickt wird. Apple versichert, dass iMessage-Konversationen mit der Ende-zu-Ende-Verschlüsselung geschützt bleiben, sodass private Kommunikation von Apple nicht gelesen werden kann.

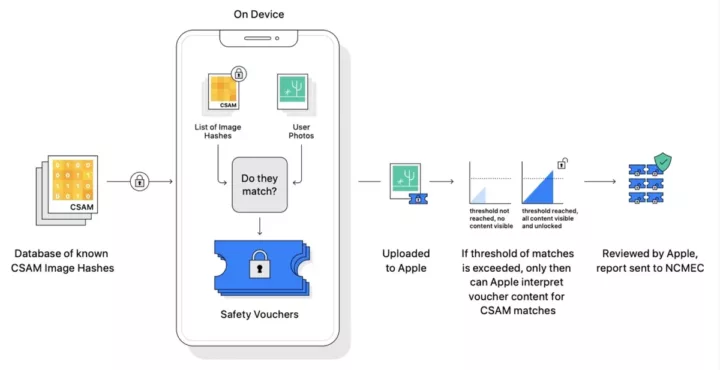

Etwas kontroverser dürfte das Scannen von Fotos nach sexuellem Kindesmissbrauch (CSAM, Child Sexual Abuse Material) diskutiert werden, wobei ähnliche Mechaniken bereits von anderen Unternehmen, wie unter anderem Google und Microsoft, eingesetzt werden.

So werden Fotos, die solche Inhalte zeigen und bekannt sind, an Hashes erkannt. Apple kann diese Fälle an das National Center for Missing and Exploited Children (NCMEC), eine gemeinnützige Organisation, die mit US-Strafverfolgungsbehörden zusammenarbeitet, melden.

Anstatt Bilder in der Cloud zu scannen, wird das System laut Apple einen Abgleich mit einer geräteinternen Datenbank bekannter CSAM-Bilder durchführen, die von der NCMEC und anderen Kinderschutzorganisationen zur Verfügung gestellt wird. Apple wird diese Datenbank in einen unlesbaren Satz von Hashes umwandeln, der sicher auf den Geräten der Nutzer gespeichert wird. Heißt: Es werden nicht eure Pool-Fotos auf Nacktheit überprüft, es wird geschaut, ob euer Foto den identischen Hash wie bekannte CSAM-Bilder hat.

Apple erklärt den ganzen Vorgang sehr genau auf dieser Seite – so bekommt das Unternehmen nichts von den privaten Fotos mit, sollte irgendwann ein gewisser Schwellenwert überschritten werden und die Bilder öffentlich geteilt sein, kann eine kryptografische Technologie Apple erlauben, Logs auszuwerten, die mit den Bildern verknüpft sind. Apple überprüfe dann manuell jeden Bericht, um zu bestätigen, dass eine Übereinstimmung vorliegt, deaktiviert das Konto des Nutzers und sendet einen Bericht an NCMEC.

Wenn ein Nutzer der Meinung ist, dass sein Konto fälschlicherweise gesperrt wurde, kann er Einspruch einlegen, damit sein Konto wieder aktiviert wird. Die Wahrscheinlichkeit, dass ein bestimmtes Konto fälschlicherweise gekennzeichnet wird, soll weniger als eins zu einer Billion pro Jahr betragen.

Laut Apple biete die eingesetzte Technologie Vorteile für den Datenschutz, da Apple nur dann von den Fotos der Nutzer erfahre, wenn diese eine Sammlung bekannter CSAM-Inhalte in ihrem iCloud-Fotokonto haben. Selbst in diesen Fällen erfährt Apple nur von Bildern, die mit bekannten CSAM übereinstimmen.

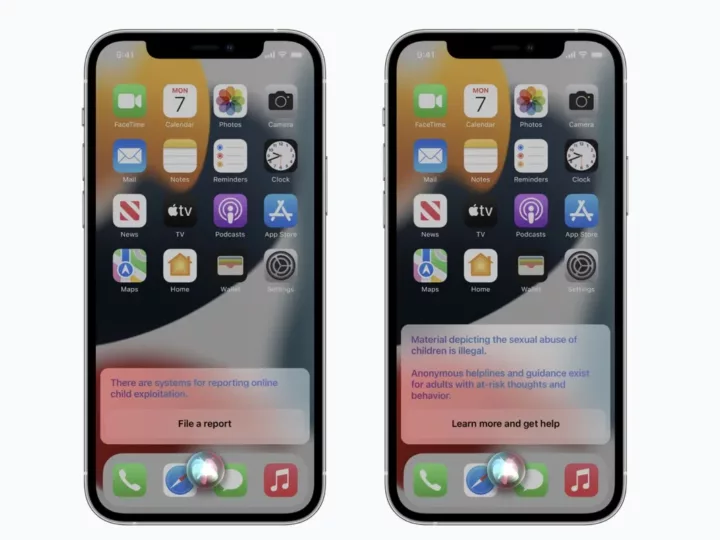

Apple erweiterte außerdem die Hilfestellungen in Siri und der Suche um zusätzliche Ressourcen, die Kindern und Eltern helfen sollen, online sicher zu bleiben und Hilfe in unsicheren Situationen zu erhalten. So werden Nutzer, die Siri fragen, wie sie CSAM oder die Ausbeutung von Kindern melden können, auf Ressourcen verwiesen, wo und wie sie eine Meldung machen können.

Siri und die Suchfunktion werden ebenfalls aktualisiert, um einzugreifen, wenn Nutzer Suchanfragen zum Thema CSAM stellen. Diese Eingriffe erklären den Nutzern, dass das Interesse an diesem Thema schädlich und problematisch ist, und stellen Ressourcen von Partnern zur Verfügung, um Hilfe bei diesem Problem zu erhalten.

Diese Aktualisierungen für Siri und die Suche werden im Laufe dieses Jahres mit einem Update für iOS 15, iPadOS 15, watchOS 8 und macOS Monterey veröffentlicht. Wie erwähnt: Ausschließlich in den USA.

In den nachstehenden Dokumenten finden Interessierte weitere Informationen zu diesen Funktionen, darunter technische Zusammenfassungen, Beweise und unabhängige Bewertungen des CSAM-Erkennungssystems durch Experten für Kryptografie und maschinelles Lernen:

- Expanded Protections for Children — Technology Summary (PDF)

- CSAM Detection — Technical Summary (PDF)

- Apple PSI System — Security Protocol and Analysis (PDF)

- Technical Assessment of CSAM Detection — Benny Pinkas (PDF)

- Technical Assessment of CSAM Detection — David Forsyth (PDF)

- Technical Assessment of CSAM Detection — Mihir Bellare (PDF)

- Alternative Security Proof of Apple PSI System — Mihir Bellare (PDF)

Wenn es denn keine Schwachstellen im System gibt und es genauso funktioniert,wie Apple es sagt,dann finde ich das prinzipiell sehr gut.

Es gibt kein System ohne Schwachstellen.

Aber es gibt einen Unterschied zwischen einem „ordentlichen Design“ bei dem Schwachstellen nur sehr begrenzten Schaden anrichten können, und „schlechtem Design“ bei dem die Sicherheit/Daten immer nur so lange „sicher“ sind bis zum nächsten leak.

Und dem muss man dann noch den Nutzen gegenüberstellen: ich hab auch was dagegen wenn Leute sich an meine Kinder ran-wanzen.

Also die Idee Bilder lokal auf dem Gerät mit vorher definierten hashes zu vergleichen, klingt gut. Ob das in der Praxis funktioniert (ist es möglich überhaupt hashes zu einem ausreichenden Teil der existierenden Bilder zu sammeln? wie leicht können Kriminelle durch minimales ändern der Bilder sich dem entziehen, wie oft/wie viele Updates benötigt das,…) wird sich zeigen. Einen Versuch ist es wert.

Hintertüren, wie die die Apple hier implementieren will, sind per Definition immer schlechtes Design. Die Idee, Bilder lokal auf dem Gerät mit irgendwelchen Hashes abzugleichen alleine ist saudämlich, mal ganz davon abgesehen, dass es dann auch eine weitere Schnittstelle geben wird, um die Ergebnisse an Apple und/oder weitere zu übermitteln.

Hier geht es nicht darum, dass sich jemand an deine Kinder „ran-wanzt“, das kann kein iPhone verhindern. Das ist genau die Art von Gehirnwäsche, die damals bei Zensursula schon versucht wurde. Hier wird der Schutz von Kindern vorgeschoben, um Überwachungsmaßnahmen zu etablieren.

Nein, das ist keinen Versuch wert. Das muss mit aller Macht verhindert werden. Alleine dass Apple es versucht zeigt, was für eine verkommene Firma das inzwischen geworden ist.

Hier öffnet Apple die Büchse der Pandora ganz weit.

Die Technologie lässt sich ebenso dazu einsetzen, Nutzer aufzuspüren die bspw. sogenannte „Blasphemie“, Oppositionskennzeichen oder Nachrichten die vertuscht werden sollen, haben.

Wenn diese Technologie erstmal ausgerollt ist, wird Apple sich sehr schwertun, den Forderungen von gewissen Staaten nach dem Ableich mit „erweiterten“ Hashlisten zu widerstehen.

Und wie verhalten sich Microsoft und Google?

geht genauso wenig, wenn sich Unternehmen anmassen das Gesetz selber in die Hand zu nehmen wie ehrenhaft das auch immer ist, dafür haben wir hier zu mindestens eine Judikative die sowas mit Begründung anordnen kann.

OK, der Kommentar las sich nämlich so, als würde das hier etwas völlig Neues sein.

Ist doch auch was neues, dass offline bilder auf dem internen Speicher gescannt werden, oder? Bei Microsoft und Google wird bisher doch nur öffentlich zugängliches aus dem cloud Speicher gescannt, soweit ich das in Erinnerung habe.

Neu ist das dass ganze schon auf den Geräten der Nutzer stattfindet! Das ist ein gewaltiger Unterschied besonders in Ländern bei denen die Regierungen nicht so vertrauensvoll sind. Sobald diese Technologie implementiert ist wird doch niemand ernsthaft in Zweifel ziehen das Gesetze erlassen werden diese Datenbank mit ganz anderen Informationen als kipo zu füllen und auszuwerten.

Edit. Ich beziehe mich hier auf Länder wie China, Russland etc.

MS und Google tun dies nur Online, nicht lokal. Was Apple hier tut, ist eigentlich ziemlich übel.

Absolut etwas neues. Es ist der erste Schritt zur permanenten Überwachung.

Jeder ist dafür schwere Straftaten zu verhindern, auch gewisse Kompromisse sind ok, die Polizei muss arbeiten können. Aber das ist gleichzusetzen mit einer Überwachungskamera in deinem Zuhause, das ist ein neues Level was Apple da ankündigt und absolut nicht akzeptabel!

Es hat sich immer gezeigt das totale Kontrolle nur zum Verlust der Freiheit führt und auch schwere Straftaten nie komplett verhindern kann. Und wenn wir eines gelernt haben in den letzten Jahren, dann wird immer noch einer drauf gesetzt. Als nächstes meldet Verwertungsgesellschaften Interesse an deine lokalen Inhalte zu durchsuchen.

Und was ist mit false-positives, die wird es immer geben? Es führt zu einer tendenziellen permanenten Verdächtigung von jedem Menschen.

Eine große Gefahr ist auch, dass es sehr schnell missbraucht werden kann, von totalitären Strukturen, aber auch durch andere Kriminelle. Ich spiele dir per Hack illegale Daten auf dein Gerät und du landest vor Gericht. Gerade durch Pegasus weiß man das das alles geht.

Microsoft und Google scannen aber nur in deren Cloud, wie es auch Apple ebenfalls macht.

https://www.heise.de/mac-and-i/meldung/Apple-scannt-iCloud-Fotos-auf-Kindesmissbrauch-4631129.html

Apple scannt nun darüber hinaus im eigenen Messenger, was Microsoft und Google eben nicht machen. Das ist nun völlig, wovor z.B. Snowden zurecht auch warnt.

„NSA-Whistleblower Edward Snowden kommentierte Apples neues Feature auf Twitter mit den Worten, der Konzern wolle „das iPhone so modifizieren, dass es ständig auf Bannware scannt“.

https://twitter.com/Snowden/status/1423387232963022848

MS und Google durchsuchen nicht den lokalen Gerätespeicher – ein riesiger Unterschied.

Woher weißt Du das? Die Software ist geschlossen, was die so auf dem Telefon treibt oder nicht treibt kann man nur erahnen.

Dann glaubst du aber auch Apple hoffentlich nichts. Also einfach gar nichts von ihrem Marketing-Geschwafel.

Natürlich nicht. Keine Silbe.

Gegenfrage: Was ist Whataboutism?

Wenn man Kinder hat dann ist iMessage der letzte Messenger den diese nutzen wollen da kaum welche aus dem Freundeskreis ein iPhone besitzen. Die Entwicklung ist also für die Tonne.

Apple entwickelt aber nicht für dich oder Deutschland.

In z.B. den USA ist Apple und damit iMessage deutlich weiter verbreitet als hier.

Das Problem daran ist das „client-side scanning“ und die offensichtlich dafür eingebaute Schnittstelle zum Reporting, die damit auf Betriebssystemebene weltweit auf allen Geräten eingeführt wird. Es soll (im ersten Schritt) wohl nur iCloud Photos betreffen und auch nur in den USA, aber dennoch werden ohne Verdacht erst einmal alle privaten Daten von Nutzern gescannt. Selbst die derer, die explizit den iCloud opt-out genutzt haben.

Einmal umgesetzt, gibt es wie bei allen Überwachungs…oh, ich meine natürlich…“Sicherheits“mechanismen selten ein Zurück.

Insgesamt ist man mit dem Schaffen dieser Schnittstellen nur einen Steinwurf von der kompletten Überwachung seiner persönlichen Daten entfernt. Was bringt einem Ende-zu-Ende Verschlüsselung in Apps, Cloudspeichern etc., wenn das Scannen auf dem Gerät und auf Betriebssystemebene stattfindet und man nicht kontrollieren kann, was wohin geschickt wird.

Man denke auch daran wie diese geschaffenen Schnittstellen in suppressiven Systemen (z.B. China) mit ausreichendem Druck der Regierungen auf Apple für andere Zwecke genutzt werden können.

Bei dem was uns in 10 oder 20 Jahren blühen kann ist Orwell’s 1984 eine Utopie und keine Dystopie.

Die iCloud wird schon sehr lange gescannt. Jetzt geht es darum, die Geräte in Echtzeit zu überwachen, ohne dass die Inhalte das Gerät verlassen.

Und das geht nicht nur um Fotos, technisch kann man auch alle Gespräche automatisch auf verbotene Wörter scannen und dann Meldung machen. Und so weiter.

Vielleicht schafft sich die Techbranche damit gerade selber ab. Bisher waren die Leute recht freigiebig, was persönliche Daten angeht, weil sie zumindest das Gefühl hatten, die Kontrolle zu behalten.

Mittlerweile ist die Technik aber soweit, dass alles in Echtzeit überwacht wird, selbst wenn man es nicht teilen will.

Ich glaube das macht psychologisch einen Unterschied. Möglicherweise werden sich die Verbraucher dahingehend wehren, dass sie zwar Streaming und Shopping nutzen, ihr Handy aber nicht länger zur Kommunikation nutzen werden.

Könnte wieder zur Fragmentierung führen. Briefe wieder per Post, Fotos mit der Einzelkamera, Telefonate nur unpersönliches (wie in der DDR) und wichtiges nur direkt, statt Kartenapp die Faltkarte und statt Musikapp wieder CD und Radio.

Da dürften amerikanische und europäische Vorstellungen aufeinander prallen.

Ich unterstelle Apple hehre Ziele, aber Medienkompetenz lässt sich nicht technisch realisieren.

Generell lehne ich es ab, dass Staten, Provider, oder gar Hersteller zensieren.

Staaten

Das Thema ist hoch sensibel, aber sorry eine automatisierte Massen Durchsuchung ohne richterliche Anordnung geht überhaupt nicht, das ist über die Ziellinie und verpasst mir Würgereize, Was wird dann z.B. die KP China von Apple bezüglich Volksfeindlichen Gedankengut verlangen ?

Schade das sich nicht erstmal dem ‚Flicken‘ der bestehenden Probleme angenommen wird.

Bedeutet das BildschirmZeit Freigaben und Begrenzung schon nicht funktioniert wie angekündigt und wirklich jedes Kind binnen kurzer Zeit raus hat wie es z.B. ohne Begrenzung YouTube schauen kann auf dem Gerät obwohl das explizit eingeschränkt ist …

Ja und? Ich als Kind hatte auch schnell raus wie ich mehr Fernsehzeit ergattern konnte als mir von Familienseite zugestanden wurde. Der Schulfreund durfte ja besucht werden … oder Oma … oder ich ging spazieren und ins nächste Fernsehgeschäft und glotzte auf die ausgestellten Geräte . Lesen konnte ich auch was ich wollte , nicht immer aktuell aber „Wochenend“ oder „St. Pauli-Nachrichten“ mit sehr freizügigen Fotos lagen offen im Hof , säuberlich vorsortiert von lieben Nachbarn. Daß Kinder Grenzen austesten und überschreiten ist kindgerechtes Verhalten. Ich glaube nicht daß ich durch die bilder einiger barbusiger Damen in „Wochenend“ oder den SPN“ an Leib und Seele Schaden genommen habe. Erziehung ist _Handarbeit_: eltern die sich live kümmern , mit Kindern reden , beschäftigen und ihnen keinen Schlüssel umhängen und sagen „mach mal alleine bis Papi und Mami von der Arbeit nach hause kommen“ Bei mir war jemand da wenn ich nach hause kam. Auch zum „Überwachen“, aber auch zum Reden und Kuscheln . Das wurde weder netflix noch Apple noch einem Algorithmus überlassen . Manchmal wäre „back to the 50s und 60s “ gar nicht so schlecht. Aber überlassen wir Google, Apple & Co. die Erziehung und Fürsorge für unsere Kinder , die haben mathematische Modelle die können das …

DANKE!

Meine Tochter ist 11, wir reden über alles, und ich habe ihr ein Google-Konto eingerichtet, laut dem sie angeblich 21 ist, damit sie nicht in irgendwelche YouTube-Panikaktionen reinrennt. Läuft super.

Ganz besonders möchte ich mich der Aussage anschliessen, dass Kinder nicht explodieren, wenn sie mal irgendwo Brust oder Penis sehen. Da kommt dann immer nur dieser Erwachsene-sind-bescheuert-Blick, und das war’s.

Wir gehen viel Wandern. Wenn meine Tochter fragt, warum in der Heide auf fast jedem Parkplatz ein Wohnmobil mit roten Lichtern steht, mit einer halbnackten Frau auf dem Fahrersitz, dann kriegt sie das ordentlich erklärt, fertig. Dann kommt wieder dieser Blick. Und dann Themenwechsel.

Macht euch mal locker.

Was mir trotz Lesens diverser Artikel zu diesem Thema heute früh immer noch nicht klar beantwortet wurde. Werden jetzt „nur“ Fotos gescannt, welche ich in die iCloud hochlade, oder bereits schon quasi nach Aufnahme direkt lokal auf dem iPhone?

Letzteres wäre richtig, richtig…richtig übel!

Da es sich bei iOS um proprietäre Software handelt, wirst du die Frage wohl nie beantwortet bekommen. Nutze freie Software, dann kannst du es prüfen.

Was für ein unsinniger Kommentar: Die Antwort steht wort-wörtlich im Artikel:

Es geht ganz explizit um das vergleichen von Bildern mit Hashes AUF DEM ENDGERÄT.

So wie Apple auch die meisten anderen Sicherheitsfunktionen Ihrer Geräte (bzw deren Prinzipien) offen gelegt hat, so ist auch dieses hier klar beschrieben

Das ist doch genau der Punkt. Das behauptet Apple. Prüfen kannst du es nicht.

Erzählen können die uns viel wegen ClosedSource. Der _behauptete_ Prozess ist:

– Apple bekommt eine Liste von Hashes von irgend so einem Laden

– Die Hashes werden auf deinen Rechner aufgespielt

– Das OS sucht auf deinem Gerät nach Dateien mit diesem Hash.

– Wenn ein Hash passt, wird die Datei an Apple hochgeladen und geprüft.

Das heisst für mich:

– Meine frustrierte Exfreundin mailt mir über einen Freemailer so ein Bild: PENG.

– Jemand bei dieser Kinderschutzorganisation bewertet nach US-Moral nackte Kinder am Strand als verboten: PENG.

– „Jemand“, der keine Behörde ist, und den kein Richter kontrolliert, durchsucht meinen Rechner ohne Anfangsverdacht. PENG.

– Apple schafft eine generische Schnittstelle zu meinem Dateisystem, deren stillschweigende Nutzung Behörden erzwingen können. PENG

Peng. Einfach nur: Peng. Von vorn bis hinten irreparabel: Peng.

Mich nervt ja, das bei jedem Thema von Corona bis Migration immer gleich einer „Diktatur“ schreit, aber hier kann ich wirklich nichts anderes sagen, als dass das rechtsstaatlich komplett unhaltbar ist. Das ist im Prinzip STASI, nur mit der Erweiterung, dass das spitzeln auch noch in die Privatwirtschaft outgesourced wurde, weil die das besser kann.

Wenn es wirklich um Kinder ginge, dann haltet den unübersehbaren Klimawandel auf. Der killt Kinder.

> Meine frustrierte Exfreundin mailt mir über einen Freemailer so ein Bild: PENG.

Leider nein. Wie kommt man als intelligenter Mensch auf die Idee, dass sowas bei der Entwicklung nicht bedacht wurde? Behauptung: niemand hier hat einen einzigen Satz in den im Artikel verlinkten Papers gelesen.

Die Thresholds der Übereinstimmung der Hashes sind so hoch, dass das System erst aktiv wird, wenn systematisch Kinderpornografie auf dem Gerät ist. Wenn also sehr viele Bilder mit denen in der CSAM-Datenbank übereinstimmen. Das sind Fotos von echten Opfern sexueller Gewalt, und nicht willkürlich nach US-Prüderie ein paar spielende Kinder am Strand.

Außerdem verwechselt das jeder mit dem Erkennen von Inhalten in Fotos, die ein/e Minderjährige/r per iMessage verschicken will. Sowas geschieht eh schon. Such mal in der Foto-Mediathek nach Wolken, Bergen, Personen(Gesichtern), etc. Diese Information gehen nicht an Apple sondern bleiben auf dem Gerät. Aber wenn jetzt per ML auch nach nackter Haut gescannt wird, die ein/e Minderjährige/r per iMessage verschicken will, und das System eventuell vorher einen Hinweis gibt, dann ist das schlimm.

Hinter dem letzten Satz sollte eigentlich ein ? stehen

> Wenn es wirklich um Kinder ginge, dann haltet den unübersehbaren

> Klimawandel auf. Der killt Kinder.

Genau das. Apple könnte mal damit anfangen und nicht jedes Jahr neue Modelle auf den Markt werfen. Oder die Geräte reparierbarer (Akku tauschen!) machen. Oder nicht aktiv gegen das Recht auf Reparatur kämpfen.

Apple geht es nicht um die Kinder, oder ihre Nutzer. Denen geht es ausschließlich darum, dass möglichst viele Menschen ihre Produkte kaufen.

Letzteres. Leider.

Apple rühmte sich stets mit dem Schutz der Privatsphäre und betonte, dass jegliches Scannen (Gesichts- , Objekt- und ab iOS 15 auch Texterkennung) und Analysieren von Metadaten (Zeit, Ort etc.) nur auf dem Gerät und nicht in der Cloud wie bei Google Fotos erfolge. Hier werden die Schnittstellen so erweitert, dass eben jene Scans auch an Apple oder die Behörden automatisiert Report erstatten, so denn ein Kriterium erfüllt ist. Durch close-source und mangels opt-out lässt sich auch nicht sagen wofür die Scans verwendet werden. Ob es nur bei Fotos bleibt kann dir auch niemand garantieren.

Digitale Privatsphäre muss explizites Grundrecht werden. Global.

Edward Snowden hat eine sehr klare Meinung dazu:

https://twitter.com/Snowden

Er vermutet eine Öffnung, um den Wünschen aller Regierungen zukünftig besser entsprechen zu können.

Keine Frage. Die beste Abwehr von neugierigen Blicken ist immer die Unmöglichkeit, überhaupt auf die Daten zugreifen zu können. Solche Mechanismen haben IMMER Begehrlichkeiten geweckt. Einfach weil es geht.

Mich würde interessieren, was zukünftig mit meinen mit dem iPhone geknipsten Urlaubsbildern passiert, auf denen natürlich auch meine Kinder drauf sind…wenn diese z.B. noch sehr klein als Nackedei mal durch die Gegend flitzen oder in Badesachen am Strand rumtollen und man da mal ein Bild fürs Fotoalbum oder die Großeltern macht? Jeder von uns durfte solche Bilder haben und demzufolge davon betroffen sein. Irgendwo sollte doch ein Grenze gezogen werden, ist die geplante Funktion doch ein massiver unerlaubter Eingriff in unsere Privatsphäre, der uns alle unter Generalverdacht stellt. Oder hab ich da irgendwas falsch verstanden?

Ich erinnere mich an Fälle aus den USA, bei denen Großeltern wegen Kinderpornografie angeklagt wurden, nachdem sie in den 1990ern ihre Fotoabzüge von Bildern ihrer Enkel beim Fotoservice großer Supermarktketten abgeholt haben.

Es wird ja nur auf bekannte Kinderpornographiebilder gescannt. Auf iOS wird also eine Liste mit Hashes solcher „bestätigten“ Inhalte geladen.

Solang Du Eure Familienbilder nicht auf Facebook veröffentlicht hast und vermutlich schon entsprechende rechtliche Problem hattest, würde ich davon ausgehen, dass die Hashes der Familienbilder nicht in irgendeiner Kinderpornographie-Datenbank sind. 😉

> Es wird ja nur auf bekannte Kinderpornographiebilder gescannt.

Ja, bestimmt. So, wie staatliche Zugriffe auf das DNS nur wegen Kinderpornos sind. Und die Entschlüsselung von Messengern nur wegen Terrorismus. Und die Verwendung der Bilder von Mautkameras, da würde der Staat ja NIE, also, NIE würde der Staat…

10 Jahre später: Wir haben den Falschparker erwischt.

Das System, das Apple, Google und MS bisher in der Cloud nutzen, setzt auf Hashes bekannter Bilder. Das System von Apple will auch modifizierte Bilder erkennen, die neu komprimiert wurden, in der Auflösung verändert usw. Sie nennen das immer noch irgendwas mit Hash, aber es ist was schwammigeres mit zwangsweise höherer Fehlerqoute – da soll dann die manuelle Kontrolle greifen.

Damit ist JEDES Bild, das du machst ein Kandidat als verdächtig geflaggt zu werden und anschließend von einem Apple-Subunternehmer-Lohnsklaven begutachtet zu werden. Ob da ein Kind drauf ist oder deine Frau, interessiert das iPhone nicht, höchsten den, der das Bild präsentiert bekommt. Aber der ist zum Glück vertrauenswürdig, verdient 2$/Stunde und wohnt in einer Wellblechhütte auf den Philipinen.

Ich glaube dann war es das wohl mit E2E Encryption im iMessage.

Wieso?

Ließ nochmal.

Weil Apple Inhalte, die per iMessage übermittelt wurden, gegen Hashes prüfen kann. Damit ist es keine E2E Verschlüsselung mehr, Apple muss mitlesen können, um die Inhalte zu prüfen. Da kann Apple noch so oft versichern, dass alles gut ist, aber da lügen sie halt einfach mal wieder. Wie so oft, wenn es um das Thema Datenschutz geht.

Lies nochmal nochmal.

Ich habe es gelesen und verstanden, im Gegensatz zu dir. Nimm die rosarote Apple-Fanboy-Brille ab und lies dann folgenden Artikel der EFF:

https://www.eff.org/deeplinks/2021/08/apples-plan-think-different-about-encryption-opens-backdoor-your-private-life

Ich glaube du verstehst nicht was E2E Verschlüsselung ist. Selbstverständlich ist sie intakt. E2E bedeutet, Absender verschlüsselt, Empfänger entschlüsselt, Nachricht kann auf dem Transportweg nicht abgefangen bzw. gelesen werden. Aber der Empfänger (+ alle Prozesse, die auf dem Empfängergerät laufen) können die Nachricht lesen. Da der Prozess lokal läuft, kann er die Nachrichten scannen, theoretisch von jedem Messenger, auch trotz E2E. So funktioniert auch z.B. ein Staatstrojaner. Lokal installiert sehen die problemlos alles.

Eine E2E Verschlüsselung, der man nicht trauen kann, ist keine E2E Verschlüsselung.

Wie war das doch gleich?

„What happens on your iPhone, stays on your iPhone.“

Quelle: https://www.iphoneincanada.ca/news/apple-las-vegas-iphone/

Dass ich nicht lache! Das iPhone ist und war nie sicherer als andere Telefone, auch wenn die PR Abteilung von Apple uns das gerne erzählt.

Wer wirklich Wert auf ein sicheres und brauchbares Smartphone legt nutzt ein Pixel mit GrapheneOS oder CalyxOS, aber sicher kein iPhone.

Ist okay Oliver. Du maßt dir an sowas beurteilen zu können, wenn du nicht mal die News richtig verstehst? Hut ab!

Das Gegenteil ist der Fall. Diese News ist eins der Dinge, wovor Datenschützer wie ich immer gewarnt haben. Seit Jahren. Und diese News gibt uns mal wieder Recht.

Würdet „Ihr Datenschützer“ mal Lösungen unterbreiten und nicht immer nur als „Verhinderer“ auftreten, würde man beim lesen dieses Titels auch keine schlechte Laune euch ggü. bekommen.

Das ist ganz einfach: Jede Erzeugung solcher Bilder findet im echten Leben statt. Jeder Server steht in einer Firma. Jeder geknüpfte Kontakt gilt einem echten Menschen.

Uns wird seit Jahren was erzählt von „rechtsfreien“ und „virtuellen“ Räumen. Das ist Blödsinn. Die bestehenden Gesetze reichen vollkommen aus, die Befugnisse werden ja nicht mal ansatzweise ausgenutzt.

Und das ist der eigentliche Skandal:

Alles, was an umfangreicher „digitaler“ Kriminalität in den letzten Jahren stattgefunden hat, war den zuständigen Behörden bestens bekannt: Das Jugendamt wusste von Mißbrauchsverdacht, Polizei und Dienste hatten Terrorverdächtige bereits in den Listen.

Und nichts ist passiert!

Und jetzt kommt diese Horde von sesselfurzenden, unterbeschäftigten, komplizierten Faxversendern und Excel98-verwendenden Behörden, die bereits jetzt vollkommen überfordert sind mit ihnen vorliegenden Anzeigen und Verdachtsfällen und wollen NOCH MEHR DATEN. Wofür? Damit der Aktenberg im Keller größer wird?

Hier ist die Lösung:

Geht den vielen Verdachtsfällen nach, die Nachbarn, Lehrer und sonstwer längst aufzeigen. Besorgt euch Genehmigungen von Richtern. Wenn die Gerichte nicht schnell genug sind – zieht Richter von Knallerbsenstrauch-Fällen ab, damit sie sich mit KiPo beschäftigen. Besucht die Leute, im echten Leben, in echten Familien, seht nach dem Rechten.

Deutschland ist völlig dicht mit dem Phänomen,das bestehende Regeln von den Behörden einfach niemals überprüft werden – von Tierschutz über Kinderschutz bis zu Abgaswerten und Whistleblowing. Ich zahle Steuern! Macht euren Job! Dann braucht auch keiner am Internet rumzufingern, der selber in der Behörde nichtmal welches hat.

/rant

Das ist nicht die Aufgabe von „uns Datenschützern“. Unsere Aufgabe ist zu erklären, wie man es richtig macht. Für die korrekte Umsetzung sind Firmen wie Apple zuständig.

Dass Cloud-Anbieter den Content auf ihren Server überwachen, ist mir egal. Ich würde sogar sagen, es ist nachvollziehbar, da sie sich sonst unter Umständen zu Komplizen machen, wenn illegaler Content über ihr System geteilt bzw. verbreitet wird. Wer seine privaten Daten dort hochlädt, sollte sich bewusst sein, dass er sie damit in fremde Hände legt.

Was Apple hier vor hat, steht aber auf einem völlig anderen Blatt. Meine privaten Daten auf meinem privaten Gerät zu scannen, egal aus welchen vielleicht nachvollziehbaren Gründen, ist für mich ein absolutes No-Go. Man wird von Apple unter Generalverdacht gestellt und noch dazu passiert das Ganze völlig intransparent.

Für mich wird Apple dadurch vom Datenschutz-Vorbild zur absoluten Katastrophe und mich wird auch keiner vom Gegenteil überzeugen. Ich bin vor einigen Jahren aus Datenschutzgründen von Android auf iPhone/iPad umgestiegen und war bisher der Meinung, eine gute Entscheidung getroffen zu haben. Sollte Apple sein Vorhaben in die Tat umsetzen, wäre diese Entscheidung hinfällig. Nicht, dass ich Google mehr vertraue, aber Android ist wenigsten offen genug, dass man als „Techie“ tief ins System eindringen und es den eigenen Anforderungen entsprechend abändern kann.

Für mich war es dann auch mit Smartphones. Ich werde dann nir noch mein FireTV für Streaming nutzen, dass Ipad nur noch für Shopping und unvermeidliche Emails mit Behörden etc.

Aber ein Smartphone für komplette Bewegungsprofile und mit persönlichen Daten, die pausenlos in Echtzeit gescannt werden, werde ich nicht mehr haben. Die Technik funktioniert ja für die kompletten Inhalte auf dem Telefon, es gibt keinen Grund anzunehmen, dass man bei Bildern aufhören wird.

Dann wird es eben ein einfaches Nokia ohne Internet, für Telefonie und SMS.

Fotos mache ich mit einer Kamera, Gespräche und Memos mit dem Diktiergerät.

Lenkt dann auch alles viel weniger vom wesentlichen ab.

Apple ist nicht länger vertrauenswürdig. Die anderen werden folgen, wenn Apple begonnen hat. War ne schöne Zeit, aber mittlerweile ist das Internet zur Gefahr geworden.

Es muss kein Feature-Phone sein. Ein Pixel mit CalyxOS oder GrapheneOS ist absolut vertrauenswürdig, und man kann damit fast alles machen, das man auch mit einem 08/15 Android oder iOS Gerät machen kann.

Den Berichten anderer Seiten zu Folge, wird ein neues „Hash“-System genutzt, das auch veränderte Bilder erkennen soll. Also nicht wundern, wenn der Schnappschuss deiner Freundin im Netz auftaucht – der war dann einem bekannten KiPo-Bild zu ähnlich und der Lohnsklave der den Treffer manuell kontrolliert hat, fand deine Freundin auch sexy.

„Etwas kontroverser“?

Die schwächsten Mitglieder unserer Gesellschaft werden als Argument für eine totale Überwachung vorgeschoben. Nutzerdaten werden ohne Verdacht und richterliche Anordnung gezielt durchsucht um die eigenen Kunden vor Gericht zu bringen. Bei wem sollen sich die Kunden den beschweren? Aufmerksamer Beobachter kennen das Muster „Denk doch einer an die Kinder“, dann ist es organisierte Kriminalität, dann Kriminalität, dann Drogen und politische anders denkende. Wir reden hier von Apple, dem Konzern der in der arabischen Welt die Smartphones ohne Facetime ausliefert – damit keine verschlüsselten Gespräche geführt werden können – auf verlangen der Regierungen.

Darauf hinzuweisen, dass das ja nur Hashwerte sind oder doch ein Abgleich auf Veränderungen führt zu nichts. Das ist Dammbruch und die Implementierung ein technisches Detail.

Das ist beängstigend!

Nach fast 30 Jahren Windows habe ich gestern meinen ersten Apple Labtop bestellt weil mich der M1 und die Akkuleistung überzeugen.

Danke für die Veröffentlichung dieser Apple Horror Pläne.

Das ist krank, egal was da geschützt werden soll.

Ich glaube grundsätzlich keinen Beschwichtigungen „das alles gut ist“, die Erfahrung zeigt daß es immer Wege gibt. Jede Backdoor wird missbraucht. Immer! Pegasus lässt Grüßen. Meine Privatsphäre ist mir sehr wichtig.

Apple labtop erst mal wieder abbestellt.

Beängstigend das alles.

Das beobachte ich lieber noch einige Zeit.

Habe für MacOS (Intel) ein bisschen entwickelt. Erst alles gut, fast wie ein UNIX. Portierung innerhalb von Minuten. Wenn es an das Release geht (Permissions, Application Bundle…) und man nicht exakt alles von Apple nutzt wie erwünscht ist man in der Hölle. Dokumentation fehlt oder unstrukturiert, Vorgänge sind irgendwo im Internet als Erfahrungsberichte notiert und meistens „Ja. Also. In XCode würde man da klicken“.

Windows ist technisch eher hässlich. Teilweise sind selbst Funktionen zur Formattierung des Datums verbuggt, weil sie immer verbuggt waren und bleiben müssen. Aber so drakonisch und unumgänglich wie Apple ist Windows nicht. Wenn es läuft, versuchen sie tatsächlich nicht Dir das Leben zu versauen – weil sie von deiner Arbeit leben.

Apple so: 30% Gebühr entrichtet?

Unter Linux hat man mal mit uneinsichtigen Programmiereren zu tun. Gerade gute Absichten, sind nicht die immer die besten Absichten. Aber mit Erfahrung und Dokumentation klappt es mit Mensch und Technik. Da fixt sogar jemand einen alten Fehler oder bitte um Entschuldigung. Mache ja selbst genug Fehler – jeden Tag.

Jo, nutze stattdessen die Clouds von Microsoft oder Google, wo schon seit 10 Jahren nach Kinderpornos gescannt wird.