Google: LaMDA-Sprachmodell soll natürliche Konversationen mit künstlichen Intelligenzen ermöglichen

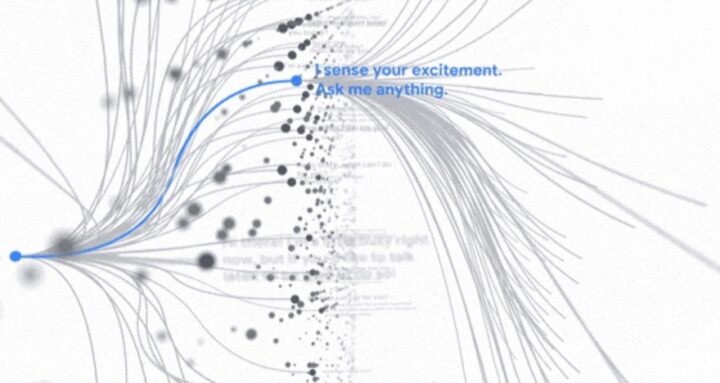

Für Freunde von Konversationen mit digitalen Assistenten hatte Google bei seinem Live-Event auch noch etwas Neues im Ärmel: LaMDA. LaMDA („Language Model for Dialogue Applications“ (Sprachmodell für Dialoganwendungen) berücksichtigt bei einer Kommunikation nicht einfach nur, was vom Anwender gesprochen wird, sondern soll das Gespräch auf eine natürliche Art und Weise fortführen, ohne dabei zu hölzern mit Antworten und Fakten um sich zu werfen, wie es aktuell unter anderem der Google Assistant leider oft tut.

Google erklärt es bildlich damit, wie eine Diskussion über eine Fernsehsendung schnell dazu führen kann, dass man sich über das Land unterhält, in dem die Show spielt und über das Essen, das dort regional bekannt ist. LaMDA soll in der Lage sein, solch komplexe Unterhaltungen zu verfolgen und vor allem entsprechend zu reagieren. Zwar stecke das alles noch in den Kinderschuhen, doch Google arbeite im Hintergrund schon fleißig mit den Algorithmen.

LaMDA wurde hierzu im Gegensatz zu vielen anderen Sprachmodellen direkt auf Dialoge trainiert, so Google:

Während des Trainings lernte es mehrere Nuancen kennen, die eine offene Konversation von anderen Formen der Sprache unterscheiden. Eine dieser Nuancen ist die Empfindsamkeit. Im Grunde genommen: Macht die Antwort in einem bestimmten Gesprächskontext Sinn? Wenn zum Beispiel jemand sagt:

„Ich habe gerade angefangen, Gitarrenunterricht zu nehmen.“

Könnte derjenige eine Antwort erwarten wie:

„Wie aufregend! Meine Mutter hat eine alte Martin, auf der sie so gerne spielt.“

LaMDA soll während seiner Nutzung nach und nach lernen, noch sensibler und spezifischer auf gesprochene Inhalte zu reagieren. Aktuell arbeite Google unter anderem auch daran, dass das Sprachmodell nicht für Hassrede und dergleichen missbraucht werden kann. Da erinnere ich mal nur an Microsofts Tay, bei der das Ganze ja aus dem Ruder lief.

Wir sind mit den Problemen, die mit maschinellen Lernmodellen verbunden sind, wie z. B. unfairen Verzerrungen, bestens vertraut, da wir diese Technologien seit vielen Jahren erforschen und entwickeln.

Ich finde es beeindruckend, das Machine Learning inzwischen so weit ist, dass die Antworten über den Gesprächsverlauf hinweg kontextbezogen erfolgen können.

Sicher wieder ein Reizthema für Aluhut-Träger, aber aus technologischer Sicht wirklich beeindruckend.