„Grand Theft Auto V“: Intel zeigt fotorealistische Grafik dank Machine Learning

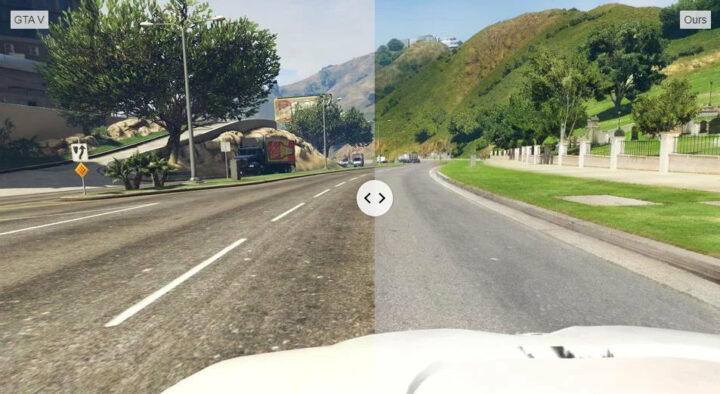

„Grand Theft Auto V“ ist eines meiner absoluten Lieblingsspiele, nervt mich aber fast mittlerweile, da nun auch noch für die dritte Konsolengeneration eine Portierung folgt. Da wäre mir ein neues Spiel mittlerweile dann doch lieber. Allerdings zeigt Intel nun, was man aus dem alten Spiel so alles machen kann. Mit der Unterstützung von Machine Learning haben Wissenschaftler des Unternehmens „GTA V“ eine teilweise fotorealistische Optik verpasst.

Die Vorgehensweise ist sehr spannend: Die Forscher der Intel Labs analysieren das Spiel und seine Grafik nahezu in Echtzeit. Dabei werden die dargestellten Objekte automatisch mit einer Datenbank verglichen und durch neue Assets ersetzt. Wobei man „in Echtzeit“ hier noch mit etwas Vorsicht genießen muss, denn Intel spricht grob von einer Geschwindigkeit, die Interaktionen ermögliche.

Sieht im Video jedenfalls schon recht cool aus. Laut Intel seien die Ersatz-Assets so gepolt, dass sie zu den Originalen passen und stabil im Bild verbleiben können. Während des Spielens ist es dann möglich immer weitere Assets nachzuladen. Falls ihr euch da noch etwas einlesen wollt: Hier hat Intel das entsprechende Paper veröffentlicht. Da gibt es dann auch einen Haufen Vergleichsbilder, den ihr euch zu Gemüte führen könnt.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

![Grand Theft Auto V - [Playstation 5]](https://m.media-amazon.com/images/I/51S1BPgfMoL._SL160_.jpg)

|

Grand Theft Auto V - [Playstation 5] | 14,99 EUR | Bei Amazon ansehen |

| 2 |

![Grand Theft Auto V Premium Edition - [PlayStation 4]](https://m.media-amazon.com/images/I/51VVEVDBwCL._SL160_.jpg)

|

Grand Theft Auto V Premium Edition - [PlayStation 4] | 16,99 EUR | Bei Amazon ansehen |

| 3 |

![Grand Theft Auto V - Standard Edition [PlayStation 4]](https://m.media-amazon.com/images/I/61VqZ8JLvVL._SL160_.jpg)

|

Grand Theft Auto V - Standard Edition [PlayStation 4] | 7,92 EUR | Bei Amazon ansehen |

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Auf jeden Fall sehr interessant. Kann mir gut vorstellen, dass Nvidia so etwas in Zukunft in DLSS integrieren könnte.

Allerdings darf man nicht vergessen, dass es nur ein Filter ist. Korrekte Lichtberechnung, Spiegelungen, etc. sind nach wie vor nur mit Ray-Tracing möglich.

Lustig, im Video ab 0:35 ist bei der Übersicht zum „Cityscapes Dataset“ oben links ein Bild von Bayreuth zu sehen. Wäre spannend zu wissen wann und zu welchem Zweck die Datenbank ursprünglich angelegt wurde. Scheint auf jeden Fall älter zu sein, denn „Joeys“, wie in dem Bild in der Übersicht unten links zu sehen, firmiert schon seit etlichen Jahren unter „Dominos“ in Deutschland. 🙂

Alle 4 Bilder sind aus BT. 🙂

Zumindest 3 erkenne ich auch wieder. Habe selber mal 5 Jahre in BT gewohnt. Geile Zeit damals…

Wird im Video erklärt, gerne aber noch einmal die Details:

Cityscapes Dataset (https://www.cityscapes-dataset.com) ist ein deutsches Projekt, unterstützt von Daimler, dem Max Planck Institut für Informatik und der TU Darmstadt.

Es wurde für verschiedene Projekte Bildmaterial aus Deutschland verwendet (siehe auch https://www.cityscapes-dataset.com/wordpress/wp-content/uploads/2018/05/cityscapesCities-768×998.jpg). Vielleicht war es nicht so clever, die ganze Zeit den Mercedes-Stern im Bild zu haben – aber da hat sich wohl Daimler als Projektsponsor mit verewigt.

@Andre: das Projekt ist technisch ziemlich deep und könnte – für interessierte Leser dieses Blog – durchaus auch einen wissenswerten Ausflug in die Tiefen der Informatik bedeuten.

Unnötig komplex irgendwie dargestellt

Als Konsolero würde ich mich ja auch erstmal mit 60fps und Bildqualität wie beim PC zufrieden geben

Das verstehe ich leider auch nicht. Als die PS4 Pro damals kam und 60fps unterstützte, habe ich mich richtig gefreut. Stabile 60fps und auch noch eine schönes Bild… Und das ganze von der Couch aus mit einem schönen großen TV. Perfekter Gaming Abend.

Dann wurde die PS5 angekündigt und für mich stellte sich die Frage gar nicht, ob unter 60fps was kommen wird. Für mich war 60fps und 4k/2k Standard. Keinen Gedanken an was anderes verschwendet.

Dann aber die Enttäuschung, das sehr viele Spiele mit 30fps laufen. Wir reden von der Next-Gen. Ja ich weiß, das man die Konsolen nicht mit einem aktuellen PC vergleichen kann, aber dennoch soll die Konsole ja auch wie die Vorgänger ein paar Jahre aktuell sein.

Ja, es gibt bei vielen Spielen die Möglichkeit, das ganze auf den Performance Modus zu stellen. Aber einige Spiele wie zb Watch Dogs Legion, hat diese Möglichkeit (dank kommenden 4.5 Patch dann doch endlich) leider nicht.

Und wenn man einmal 60fps oder mehr gewohnt ist, sind 30fps nicht mehr schön und macht keinen Spaß damit zu spielen.

Also ich liebe fotorealistischen Look, aber braucht man dafür Intel und eine KI? Theoretisch ändert die doch in „Echtzeit“ nur das, was auch mit Texturen und Lightning gehen würde. Ist also eher eine Stilfrage der Entwickler, die ja meistens bewusst auf Fototexturen etc. verzichten, um eben gerade nicht „wie echt“ auszusehen, sondern einen stimmigen Stil zu erschaffen.

Also geht auf jeden Fall auch so, ich hatte mir mal vor 2 Jahren das Asset aus dem Video unten für Unity3D gekauft (Ging mir in erster Linie um’s Lernen was er wie eingestellt hat und um die Parmeter für ein anderes Projekt zu übernehmen). Lief zwar nur mit 1-2 Frames pro Sekunde auf meinem iMac, war aber SEHR beeindruckend:

https://www.youtube.com/watch?v=H5QN_kgMnzc

Link zum Store:

https://assetstore.unity.com/packages/3d/environments/urban/archvizpro-interior-vol-6-120489

Wobei das schon zu gut aussah und dadurch fast wieder unecht. Richig Fotorelistisch passt meiner Meinung auch gar nicht zu GTA.

Das ist halt alles „pre-baked“ Lighting. Da hat man natürlich ganz andere Möglichkeiten. GTA5 dagegen hat dynamisches Licht und man könnte auf diese Weise keinen realistischen Look erzeugen.

Durch die im Video dargestellte Methode wird der Look des Spiels auf unsere Seegewohnheiten per Machine-Learning gemapped. Ähnlich wie man bei Deep-Fakes Gesichter auf Körper mapped.

Also, dass was die hier machen, schaffst du halt darum nicht so leicht, weil selbst mit Fotogrammmetrie echt aussehende Bäume zu erzeugen echt schwierig ist und realistische Lichtstimmungen ohne vollständiges raytracing auch eher Glückssache sind, weil klassische Rendertechniken gerade bei licht eben merklich schummeln, darum kann, eine gute Grundlage klassisch zu erzeugen und dann den Rest per filter hin faken durchaus bedeutend einfacher sein.

Ob dass jetzt ein Weg ist, den wir wirklich in Spielen sehen werden, ist noch mal eine ganz andere Frage

nur schade das das Video in 720p ist :-/

Vielleicht hab ich kein Auge dafür (und Ahnung von der Technik erst recht nicht), aber das Bildmaterial sieht jetzt nicht soo beeindruckend aus, wie man erst denken würde.

???

Wenn das erste Mal umgeschaltet wird, dachte ich kurz es sei ein echtes Video.

Das sieht schon verdammt beeindruckend aus.

Als ich im „drüberfliegen“ die Bilder von der Webseite, dachte ich „hä, was soll das denn sein“.

Ich für meinen Teil, musste umdenken. Man ist leider von Fotorealistischer Grafik (zb YouTube usw) etwas anderes gewohnt. Bsp: viel Licht, Bunt, Regen, da eine Spiegelung, dort eine Lichtquelle, usw)

Hier geht es aber darum, das es so nah der Realität wie möglich aussieht. Und wie Franz schon sagt, als das ganze im Video geswitched wurde, dachte ich auch, das ich ein echtes Dashcam Video gucke.

Gefällt mir, die Idee dahinter.