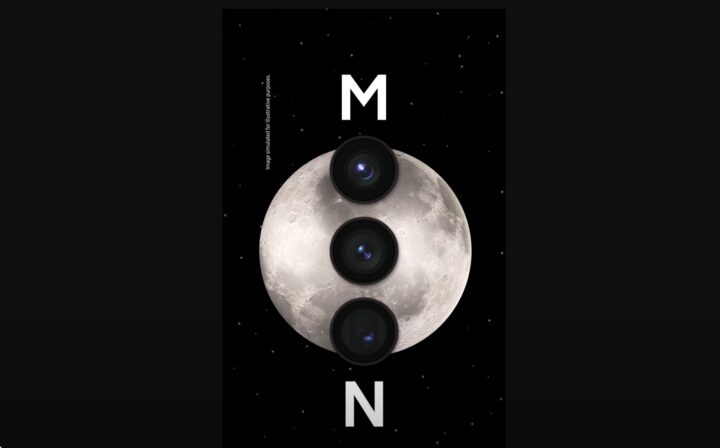

Samsung Galaxy S23: Samsung hilft bei Mond-Fotos mit KI nach

Samsung hat die seinen Flaggschiffen verbauten Kameras über die Jahre immer mehr verbessert und kann zweifelsohne mit einer ausgezeichneten Qualität glänzen. Mit dem neuem neuen Galaxy S23 wirbt man explizit damit, dass durch den Space Zoom detailgetreue Fotos des Mondes möglich sind. Das stimmt prinzipiell, doch bei der Umsetzung des Ganzen hilft Samsung anscheinend etwas nach.

Ein Nutzer auf Reddit hat ein Experiment durchgeführt, um nachzustellen, wie Samsung diese Fotos ermöglicht. Konkret hat er ein Foto des Mondes heruntergeladen, es auf 170 x 170 Pixel verkleinert und dann einen Gaussian Blur darübergelegt und wieder ein 4x Upscaling durchgeführt. Kurzum: In diesem Foto sind de facto keine Details mehr vorhanden.

Danach hat er eben jenes Foto im Vollbild geöffnet, alle Lichter im Raum ausgeschaltet und den künstlich erzeugten, detailarmen Mond mit seinem Samsung-Smartphone fotografiert. Das Ergebnis sieht so aus:

Im Video sieht man bereits deutlich, dass das unscharfe Foto während der Verarbeitung mit deutlichen Details angereichert wird. Vor allem im Vergleich von Quelle und Ergebnis wird klar, dass Samsung hier offensichtlich bei der Nachverarbeitung des Bildes nachhilft. Vermutlich hat man ein KI-Modell so trainiert, dass das Smartphone in der Lage ist, aufgrund der dunklen und hellen Bereiche im Foto Krater zu erahnen und dann dort entsprechend schärfere Texturen zu platzieren.

Auf Camcyclopedia erklärt Samsung, wie genau dieser Prozess funktioniert und was zwischen Input und Output im Processing durchgeführt wird. Wer sich genauer dafür interessiert, kann dort mal vorbeischauen. Das Beispiel zeigt erneut, dass computergestützte Fotografie viel aus Szenen herausholen kann, aber auch Dinge einbaut, die gewissermaßen nicht da sind.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Und bei Apple wäre es nun das Moongate 😉

Quatsch, es funktioniert ja genau SO wie Samsung es selber beschreibt, nur weil es keiner liest ist es doch nicht falsch.

Das stimmt so nicht ganz. Die Werbung suggeriert, dass der tatsächliche Mond abgebildet wird, was defacto nicht stimmt, es handelt sich um künstliche Bildinhalte. Damit handelt es sich m.M. aber schon um Täuschung. Ich halte das für keinen „Gate“ o.ä., aber es ist natürlich peinlich. Viel schlimmer war aber die GOS Geschichte von Samsung, die ganz klare Täuschung war.

Vielleicht sollten wir auch aufhören uns 1500€ Telefone schön reden. Egal wie viel man zahlt, ein Smartphone wird kein Teleskop werden und ein Teleskop kein Smartphone. Das die Kamera mehr Details rausholen kann als ein 900€ Pixel 7 pro könnte ja schon reichen, aber dass sie dafür einen krassen shutterlag mitbringt….naja. mich überzeugen ultra phones (auch max pro) nicht wirklich, aber sie scheinen für viele das Nonplusultra zu sein und was sich verkauft wird gebaut.

Sehe ich aber eindeutig anders. Wenn ich heute eine gerade so erkennbare Alienkapsel vor dem Mond fotografiere, sehe ich sie trotz irgendwelcher Nachbesserungen oder Verschärfungen des Fotos mit den üblichen Filtern.

Samsungs Unsinn hier weiß nen Sch** von dieser Kapsel und wird mir einfach ein Bild vom Mond zeigen, wie es erlernt wurde.

Natürlich Quatsch-Beispiel, aber es ist einfach keine Abbildung des IST-Zustandes und hat mit einem klassischen Foto, also einer Momentaufnahme absolut gar nichts zu tun. Es ist einfach nur ein generiertes Bild, so wie es sein könnte – dafür braucht man keinen 100x Zoom, die KI könnte auch mit einem 3x Zoom das Bild liefern, wenn die Flecken in etwa erkennbar sind.

Solche Fantasieabbildungen setzt Samsung genauso auch bei sehen “Fitness-Features” der Watch ein, allem voran beim Schlaf. Kannst die ganze Nacht wachliegen, du kriegst jedes Mal ein ungefähres Bild eines normalen Schlafes geliefert, wie er in etwa sein könnte.

nur das das Rennen nicht der Fall ist. die Objekte vor dem Mond bleiben erhalten.

Technisch interessant.

Aber für mich stellt sich die Frage, ist das dann überhaupt noch ein Foto, das wirklich ich gemacht habe oder ist einfach nur ein von der KI erstelltes Bild?

Es ist genauso ein Foto wie alle Fotos wo Filter drauf angewendet werden…

Nehmen wir das künstliche Nachschärfen von verwackelten Bildern beim Pixel, da wird auch durch KI ermittelt wie bestimmte Regionen wohl hätten aussehen müssen und werden so hin gerendert… ob das Original genauso aussah, weiß kein Mensch.

Oder die Nachtsichten… auch da wird aus mehreren Fotos durch KI ein neues generiert, was dann hoffentlich der Realität entspricht… oder auch nicht ganz.. je nach KI.

Da sehe ich durchaus noch einen großen Unterschied: eine KI auf den Mond zu trainieren ist sehr simpel, da man diesem System einfach nur ausreichend unterschiedliche Fotos vom Mond anfüttern muss um ihm „beizubringen“ den Mond in unterschiedlichsten Situationen zu erkennen (also z.B. selbst wenn er extrem unscharf ist). Anschließend werden wohl kaum die (nicht vorhandenen) Details mittels intelligenter Algorithmen herausgearbeitet/verbessert sondern wohl eher aus einer eigenen Datenbank ein entsprechend passendes Bild bzw. Bildteile an die passende(n) Stelle(n) über das eigentliche Bild gelegt bzw eben damit ersetzt.

Ist eigentlicht so ziemlich dasselbe wie man es bereits von Huawei kennt. Nur vielleicht noch mit etwas mehr Chichi drumrum. Es klingt halt geiler wenn man sagt „wir verbessern dein Bild mit KI“ anstatt „wir erkennen, wenn du den Mond fotografierst und klatschen dann einfach ein (detailreicheres) Bild aus unserer Datenbank drüber, was ja keinem auffällt, da der Mond ja immer gleich aussieht (da wir ja immer dieselbe Seite sehen), und passen da vielleicht noch ein wenig die Farbtemperatur & Co an…“

Also nein, es ist weder ein selbst erstelltes Bild (also zumindest nicht der Mond, an der Stelle ist de facto von der eigentlichen Kameraaufnahme nichts mehr vorhanden) aber auch nicht ein „von der KI erzeugtes Bild“, da einfach nur bereits vorhandene Mondbilder/Teile oder Details davon hergenommen und darüber gelegt werden.

Ein Filter im klassischen Sinne bedient sich dagegen wirklich nur der eigentlichen Aufnahme und schärft dort z.B. Kanten nach oder zeichnet Hautfalten weich. Ist immernoch eine Veränderung, aber nur auf Basis von Informationen, die im Bild enthalten waren.

Hat Huawei nicht schon vor Jahren genau das gemacht, nämlich das Mond-Foto ausgetauscht?

Kommt mit auch sehr bekannt vor

Ein Freund von mir hat mir vor ein paar Wochen ein Mond Bild eines Samsungs geschickt und war stolz wie Bolle. Ich habe ihm geraten mal das Internet abzuklemmen um zu sehen ob da nicht einfach Daten aus dem Internet reingemischt werden…… Da lag ich wohl nicht soooo daneben.

Apple verlinkt zukünftig die Google Bildersuche wenn man den Mond fotografiert? Wäre ehrlicher.

Überspitzt (?) gesagt:

Samsung hat Fotos vom Mond mit hoher Auflösung im S23 gespeichert. Sind die selbst fotografierten Bilder vom Mond nicht so toll, ersetzt Samsung das selbst fotografierte Bild teilweise oder ganz mit dem Bild aus der Retorte.

Hier wurde anscheinend nicht verstanden was Aufbereitung mit KI bedeutet. Natürlich „erstellt“ KI Inhalte, nämlich so wie sie es gelernt hat, aber sie tauscht jetzt nicht einfach das Bild gegen ein anderes aus.

Genauso wie z.B. ChatGPT aus wenigen Informationen aus einem Befehl einen ganzen Aufsatz schreibt, oder der Magic-Eraser beim löschen von Stör-Objeketen die überdeckten Bildbereich wieder auffüllt, so weiß das KI-Modell vom Mond, wie die Lage vom Mond ist aufgrund der wenigen Bildinformationen und ergänzt sie um ihr bekanntes Wissen. Da wird aber nicht ein Bild drauf geklatscht sondern per KI hochgerechnet.

Bestes Vergleichsbeispiel sind die vor Jahren mal public gewesenen „Hochrechen-KIs“ die aus 150×150 Pixel-Bilder echte scharfe Fotos gemacht haben. Die waren natürlich auch generiert, ergänzt und erstellt… ob das Original so aussah weiß kein Mensch.

Und genauso hat es Samsung ja auch immer beschrieben, nichts verheimlicht oder so.. nur lesen tut es keiner.

Hier mal ein gutes Beispiel was Samsung macht, nur halt mit dem Mond statt einem Portrait:

https://itwelt.at/news/ki-macht-pixelige-fotos-zu-scharfen-gesichtern/

Na ja, hochgerechnet, ist in diesem Fall aber falsch. Denn der Thread bei Reddit zeigt ja, dass Informationen ergänzt werden, die im Originalbild eben nicht vorhanden sind. Letzten Endes kann man eben nun diskutieren, ob man das in Ordnung oder irreführend findet, wie die Funktion beworben wird, das finde ich durchaus legitim.

siehe mein Link… hochgerechnet/von KI erzeugt… finde den richtigen Begriff… es ist aber eben nicht, was hier unterstellt wird, das einfach austauschen von Bildern oder Bildbereichen… damit würde man es sich zu einfach machen.

Da gebe ich dir schon recht, nur hochrechnen wäre eben doch etwas anderes, hochwertiges Upscaling ist ja hier nicht der Schlüssel, sondern es werden viel mehr völlig neue Details mithilfe einer Datenbank ergänzt, aus der eben der Algorithmus schöpft. Man kann sich schon drüber streiten, ob das jetzt noch viel mit Fotografie zu tun hat, denn die eigentliche Optik ist da schon wieder wurscht.

und wo ist die news? das machen alle schon seit jahren, bei jedem einzelnen foto…

Gerade bei Astro-/Mondfotos. Da sind scharfe Bilder per se gar nicht einfach so möglich ohne Nachbearbeitung. Stichwort Luftunruhe, atmosphärische Dispersion etc. da sind leichte Unschärfen IMMER dabei, die dann eben rausgefiltert werden müssen. Ob das nun per KI oder normal per Stacking funktioniert ist erstmal egal.

Ähem, mal das letzte Bild oben angesehen? Ein völlig unscharfes Bild aufgenommen und ein scharfes Resultat bekommen? Kleiner Hinweis, beim Mond ist das wirklich einfach, da gibt es 1000ende wirklich scharfer Bilder aus dem Internet, da wird das Unscharfe einfach ersetzt und die tollen Sensoren und Optiken gelobt….. Finde den Fehler. Ist ja nicht das erste Mal, das sich Samsung so entblödet.

Ähem, die tollen scharfen Bilder im Internet sind aber auch genauso entstanden. Wenn man z.Bsp. Planeten fotografiert, bekommt man i.d.R. aus dem Kasten nichts anders als dieses unscharfe Gebilde wie oben abgebildet. Ebenso bei Detailaufnahmen von Teilen des Mondes mit entsprechender Optik. Software machts dann möglich. Da werden aber keine vorhandenen Bilder als Referenz genommen, sondern nur die besten im Stack aufsummiert und nachgeschärft. Man macht dann aber Videos mit hoher FPS-Zahl, die später wieder in Einzelframes zerlegt werden, keine schnöden Einzelbilder. Durch KI ersetzte Bilder halte ich aber auch für seltsam, da es eben nicht der Momentaufnahme entspricht was man selber geknipst hat.

Hast Du jemals durch ein echtes Teleskop zum Beispiel den Mond angesehen? Habe hier noch ein altes 20cm Dobson stehen. Wenn ich den Mond mir dadurch ansehe, ist der alles, aber nicht unscharf, der ist schon fast surreal scharf. Auch das Auges des Jupiter oder die Saturnringe (incl. Teilung) alles möglich mit einem < 1000€ damals Teleskop.

Nicht nur einmal und auch nicht nur durch 8″ 😉 Du verwechselst visuelle Wahrnehmung und fotografische Aufnahme des Objektes. Visuell ist das natürlich recht scharf, reicht ja schon ein schönes Fernglas, aber mit einer Kamera sowas auch festzuhalten ist alles andere als trivial und ohne anschließende Nachbearbeitung kaum in guter Qualität möglich aus genannten Gründen.

Samsung müsste eigentlich damit werben, sehr gute KI generierte Bilder erzeugen zu können.

Klar hatten Bilder noch nie den Anspruch die Wirklichkeit 1:1 abzubilden, aber hier wird einfach mega geschummelt. Irgendwie langweilig…

Manche hier haben wohl die Weisheit mit dem Löffel gegessen. Und geil wie sie ihren Standpunkt vehement verteidigen, dabei nicht wissen dass sie total Unrecht haben.

Für euch mal Fakten:

Ja man kann den Mond von der Erde aus SCHARF fotografieren. Da ist nicht grundsätzlich eine Unruhe oder Dispersion vorhanden. Am richtigen Ort, mit richtigem Equipment (auch ohne Internet, Software und KI) sind scharfe Fotos vom Mond möglich.

Ja, Samsung spricht nicht erst seit der neuesten Generation von KI-optimierten Fotos, das tun die schon länger. Somit ist es schwierig Betrug zu beweisen.

Ich persönlich fühle mich als Endanwender trotzdem getäuscht, da ich, gerade bei den immer teurer werdenden Smartphones davon ausgehe, dass die verbauten Kameras auch tatsächlich mehr können als noch vor 2 Jahren.

Mir scheint es aber eher so zu sein, dass man zwar Jahr für Jahr 300€ mehr für das Topmodell bezahlen muss, jedoch nur die Software (KI) besser wurde. Mein Vertrauen in Samsung ist jedenfalls nicht besser geworden.

„…Da sind scharfe Bilder per se gar nicht einfach so möglich ohne Nachbearbeitung. Stichwort Luftunruhe, atmosphärische Dispersion etc.“ Da steht NICHT, dass es grundsätzlich nicht geht. Da spielen aber eine Menge Faktoren rein, die man an nur wenigen Tagen im Jahr an bestimmten Stellen vorfindet. Hast ja teilweise schon angedeutet. Nix für aus der Hüfte mal eben den Mond knipsen, nur für die Fakten der angeblich selbst gelöffelten Weisheit 😉

Was die Hardware durch physikalischen Grenzen nicht kann macht halt die Software.

DLSS macht im Prinzip das gleiche:

„DLSS 3.0 nutzt eine niedrigere Auflösung für die Echtzeitberechnung und setzt zusätzlich eine Künstliche Intelligenz ein, die daraus berechnet, wie das Bild in einer höheren Auflösung aussehen müsste.“

Ich weiß nicht, ob alle hier Beitragenden schon Mondfotos mit dem S23 Ultra gemacht haben. Also: das Handy an ein Stativ geklemmt, dann den Mond erst mal überhaupt in den Sucher bekommen. Dann stellt das Gerät scharf. Alles da, wie beim Spiegelteleskop: Der Mond wandert mit schneller Geschwindigkeit nach rechts aus dem Bild, bei tiefstehendem Mond viele Turbulenzen direkt erkennbar. Dann berührungsloser Auslöser und man hat ein Bild. Nach 20 Auflösungen hat man beim Vergleichen immer mal andere Bilder dabei, halt wegen der Turbulenzen und des Autofokus, der an seine Grenzen kommt. Der Gedanke, dass Samsung aus den Tiefen einer App irgendwelche Mondfotos rauskramt, um sie dem User als selbstgeschossenes Bild vorzugaukeln, ist schon verwegen und passt in die „Sowieso-alles-gefaked-Mentalität“ in der letzten Zeit. Dass man hier KI-mäßig viel machen kann, ist schon klar, besonders beim Mond, von dem man ja immer nur eine Seite sieht, aber nie 100% gleich. Also das Original muss sich die KI schon vornehmen und dann sind wir wieder bei der normalen Bildbearbeitung.