Pixel 3: Google erklärt, warum die aktuelle Kamera noch bessere Porträtfotos als die des Vorgängers macht

Worauf es vielen Käufern eines Smartphones heutzutage ankommt ist, dass das neue Gerät eine möglichst gute bis sehr gute Kamera vorzuweisen hat, damit auch die Fotos der kommenden Jahre vorzeigbar bleiben. Um diesen Wunsch wissen die Gerätehersteller natürlich genau und wenn man eine Kamera aktueller Geräte immer mal wieder hervorheben darf, dann ist es die von Googles Pixel 2 und nun vom Pixel 3.

Genau wie bei allen anderen Smartphones, kommen auch die Pixel-Geräte von Google nicht mehr ohne einen Porträtmodus aus. Und gerade hier können sich die genannten Modelle auch teils sehr stark von der Konkurrenz abheben, denn sie verfügen lediglich über einen einzelnen Sensor und nicht wie bei den anderen Geräten über mindestens zwei oder mehr Linsen. Und dennoch schaffen es die Google-Phones immer wieder grandiose Porträtaufnahmen zu knipsen, das Pixel 3 toppt seinen Vorgänger sogar noch in einigen Aspekten.

Doch woran liegt es, dass das aktuelle Flaggschiff der Marke nun noch eine ganze Schippe drauflegen konnte und einige beim Pixel 2 auftretende Schönheitsfehler so gut wie vollständig ausmerzen kann? Genau das erklärt uns Google nun in einem sehr umfangreichen und vor allem sehr technischen Beitrag, den ihr euch bei Interesse aber unbedingt mal in Gänze geben solltet.

So sei es beim Pixel 2 noch so gewesen, dass in der Software des Geräts vor allem ein Stereo-Algorithmus dafür sorgt, dass die einzelnen PDAF-Pixel des Kamerasensors in den Aufnahmen miteinander verglichen werden und durch das Erkennen einer Parallaxenverschiebung die Berechnung der eigentlichen Tiefeninformationen eines einzelnen Pixels erfolgt. Klingt hart theoretisch und genauso kompliziert ist es dann am Ende auch, was darin resultiert, dass das Pixel 2 beim Erstellen einer Porträtaufnahme hin und wieder Bildfehler produziert.

Das Pixel 3 nutzt daher nun das Maschinelle Lernen für seine Berechnungen und kann, wie in der obigen Animation zu erkennen, damit allerlei Fehler ausbügeln. Erster Ansatzpunkt ist hierbei, dass die Parallaxe in Bildern nur eine einzelne von verschiedensten Informationen ist, die auf die Tiefeninformation hinweisen kann. So erscheinen beispielsweise Punkte, die weit von der Fokusebene entfernt sind, weniger scharf als solche, die näher sind, was einen Hinweis auf die Defokussierungstiefe gibt.

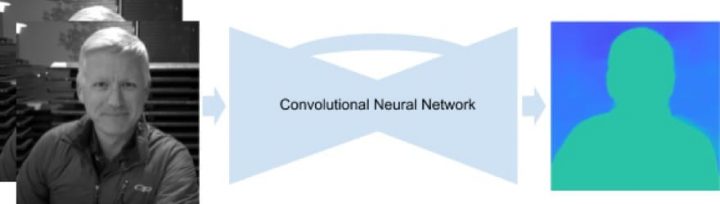

Dank maschinellem Lernen können sämtliche Hinweise miteinander kombiniert und gleichzeitig der PDAF-Parallaxen-Hinweis besser genutzt werden. Hierzu dient ein in TensorFlow geschriebenes neuronales Netzwerk, das die PDAF-Pixel als Eingabe nimmt und lernt, die Tiefe vorherzusagen.

Und da so ein neuronales Netzwerk bekanntlich auch trainiert werden muss, damit es auch wirklich immer besser werden kann, müssen eine Menge Porträtaufnahmen her, die am besten auch noch mit einem Smartphone aufgenommen wurden. Immerhin soll die Technologie ja gerade ein Smartphone dahingehend verbessern, dass dessen Aufnahmen noch besser werden.

Und was nimmt man bei Google für so etwas? Na klar, ein zusammengeschustertes Rig aus fünf einzelnen Pixel 3-Geräten, die minimal zeitversetzt voneinander auslösen und so dafür sorgen, dass ausreichend Fotos mit Tiefeninformationen und miteinander vergleichbaren Pixeln zustande kommen. Das Ende vom Lied ist eine Technologie, die dem Pixel 2 dann tatsächlich einiges voraus hat. Mal sehen, was sich Google dahingehend für die Zukunft noch so alles überlegt hat.

Also wenn ich den original Post richtig verstanden habe ist der Trick nicht das zeitlich versetzte Auslösen (das sollte so synchron wie möglich sein, die erreichen 2ms), sondern die leicht unterschiedliche Position der Linsen des 5-Pixel-Konstrukts.

Nicht zu vergessen!!! – dem Medium Fotografie immanent ist „Schaerfe und originaere Information“ eine „Softwarekamera“. die natuerlich DATEN in Pseudoinformation interpretiert bleibt fragwuerdig.

– „Nicht Software redet Hardware“.

Da wäre jetzt interessant wie viel Hardware-spezifische Lösung hier jetzt drin steckt – und ob das ganze per Software-Update auf das Pixel2 übertragen werden kann.