Ollama bringt neue Desktop-App für macOS und Windows

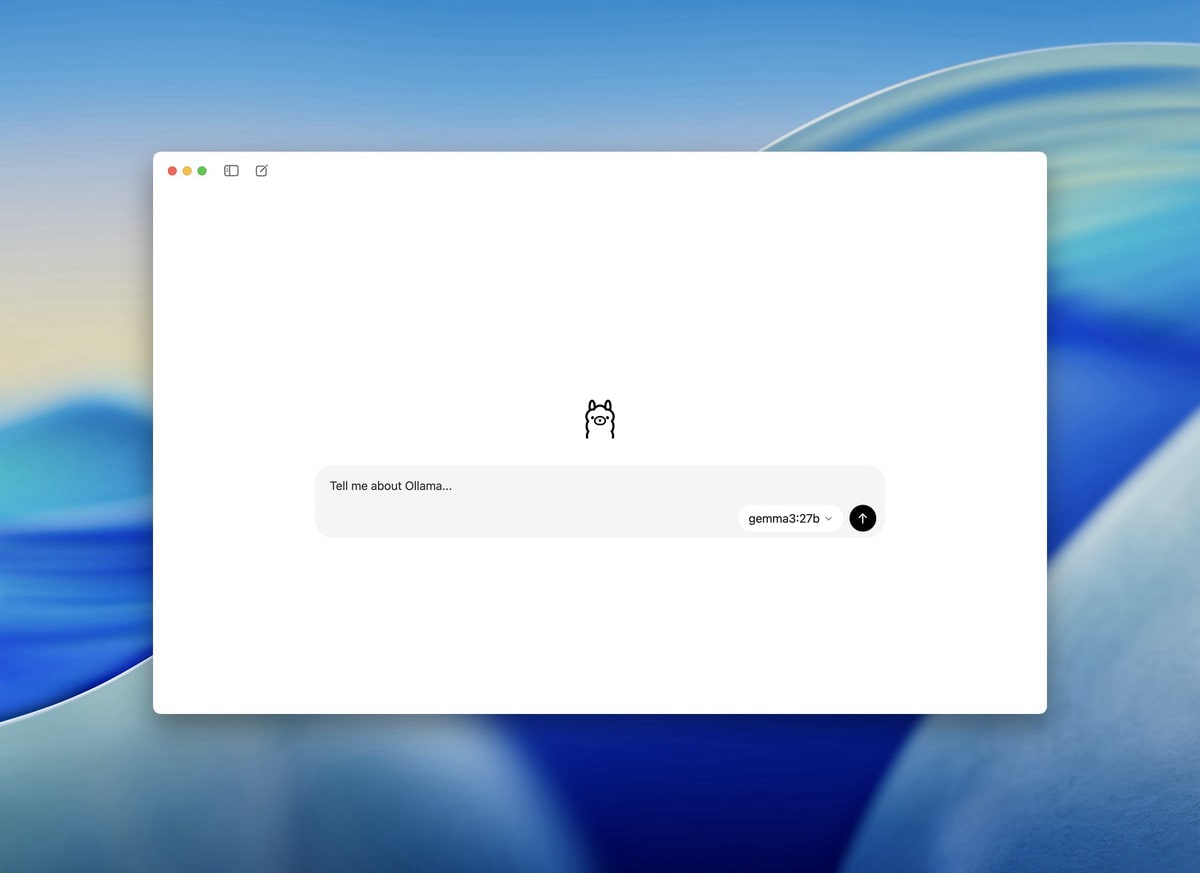

Die Entwickler von Ollama (haben wir bereits hier und hier vorgestellt) haben ihre KI-Plattform um eine neue grafische Benutzeroberfläche erweitert. Die neue Desktop-Anwendung steht ab sofort für macOS und Windows zum Download bereit und vereinfacht die Interaktion mit verschiedenen KI-Modellen. Die App ermöglicht das direkte Herunterladen und Nutzen von Sprachmodellen über eine übersichtliche Oberfläche. Nutzer können per Drag & Drop Dateien wie PDFs oder Textdokumente in die Anwendung ziehen. Die Verarbeitung erfolgt lokal auf dem eigenen Rechner.

Für umfangreiche Dokumente lässt sich die Kontextlänge in den Einstellungen anpassen. Dies erfordert allerdings mehr Arbeitsspeicher. Die neue Version unterstützt auch die Verarbeitung von Bildern mit kompatiblen Modellen wie Google DeepMinds Gemma 3. Entwickler profitieren laut der Macher von der verbesserten Code-Analyse-Funktion. Die App kann Programmierdateien einlesen und bei der Dokumentation unterstützen.

Wer auf eine grafische Oberfläche verzichten möchte, findet die CLI-Version weiterhin in den GitHub Releases. Die Desktop-Variante richtet sich vor allem an Nutzer, die einen einfachen Einstieg in die KI-gestützte Textverarbeitung suchen.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Kennt sich jemand mit den Modellen aus und kann mir eins empfehlen, das pdfs oder ebooks schluckt und von english in deutsch übersetzt?

Nimm Gemma3-27b (benötigt bei qat schon gegen 24gb VRAM). Das ist sehr gut bei Übersetzungen. Kommt halt aber auch auf deine GPU an. Ev. musst du ein kleineres Modell nehmen.

https://ollama.com/library/gemma3/tags

Ja Gemma3 würde ich auch empfehlen. Und QWEN3. Jeweils in der größten Version die deine GPU kann. Ich habe 16Gb und Gemma3 27b läuft bissel langsam aber ok und QWEN3 30b läuft flott. Für lokal sind die richtig gut!

Endlich!! Habs gerade heruntergeladen und konnte nach automatischen Download des Modells direkt den Prompt stellen. Lokales LLM für Normalos jetzt in unter einer Minute möglich. Kein einrichten, kein Terminal.

Super!!!