Ollama 0.9.5: Native macOS-App mit verbesserter Performance

Das Open-Source-Tool Ollama für die lokale Verwaltung von Large Language Models (LLM) liegt jetzt in Version 0.9.5 vor. Die Entwickler haben die Software laut eigener Aussagen grundlegend überarbeitet und bieten nun eine native macOS-Anwendung an, die sich durch schnellere Startzeiten und einen reduzierten Speicherbedarf auszeichnet. Der Umstieg von Electron auf eine native macOS-App macht sich direkt bemerkbar: Die Installationsgröße schrumpft um etwa 25 Prozent, während die Anwendung schneller startet.

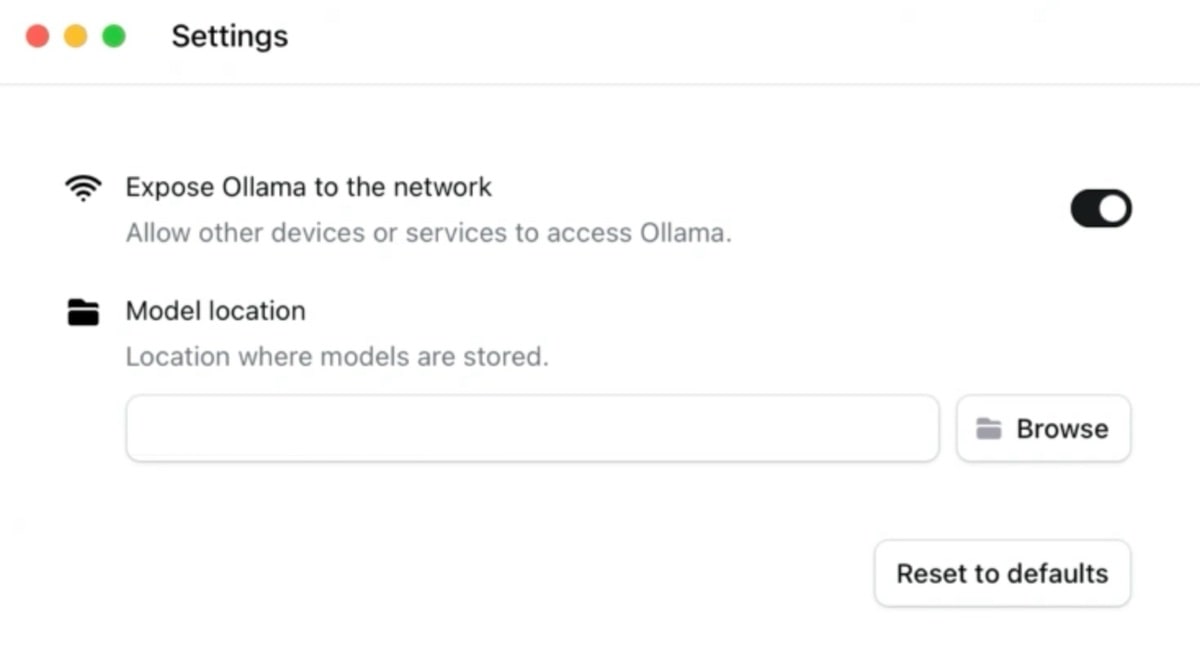

Mit Version 0.9.5 führt Ollama auch neue Funktionen ein. Über ein neues Einstellungsfenster lassen sich die verwalteten Sprachmodelle im Netzwerk freigeben. Dies ermöglicht es, ressourcenintensive LLMs auf leistungsstarken Rechnern laufen zu lassen, während andere Geräte im Netzwerk darauf zugreifen können. Die Modelle müssen auch nicht mehr im vorgegebenen Standardverzeichnis gespeichert werden, Nutzer können jetzt auch externe Speichermedien oder alternative Verzeichnisse wählen. Übrigens: Ollama gibt es auch für Windows und Linux, wir hatten hier schon einmal das Thema zum Einstieg.

- Sehen Sie, was passiert ist, BEVOR die Bewegung beginnt: Erfassen Sie bis zu 10 Sekunden, bevor eine...

- Dual-Ansicht auf einem Screen: Sehen Sie genau, was in Ihrem Zuhause passiert – mit Dual-Ansicht auf...

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Gibt es mittlerweile vernünftige LLM für dt. Sprache? Bei den me

Habe sehr gute Erfahrungen mit Gemma3 27B und QWEN3 30B gemacht. Laufen allerdings nur so gerade noch brauchbar mit 16Gb VRAM, bei noch weniger VRAM eher schlecht. Ist es zumindest mir aber wert weil die beiden echt, für lokale kleine Modelle, sehr gut sind. Gemma3 kann sogar Bilder analysieren und somit fragen zu Bildinhalten beantworten.

Eine Nutzung des KI Teils der M-Chips wäre klasse.

Gibt’s seit ca. 4 Monaten, nennt sich MLX. Die Modelle müssen dann aber statt im gguf Fomat im MLX Format herunterladen werden. Gibt’s nicht immer 1:1 und selber bauen bzw. konvertieren ist noch ein Krampf.

Und die laufen unter Ollama? Ich hatte die bei LM Studio gesehen.

Welches lokale LLM för die deutsche Sprache würdet ihr denn fürs Synology NAS empfehlen?

Kurz: Keins. Auf nem NAS macht das leider auch wenig Sinn bisher, gerade auf Deutsch.

Ohne MLX-Unterstützung bleibt Ollama wohl stets im performanten Nachteil.

Schade, das wäre viel wichtiger, als ein kleineres Wirtsprogramm oder schnelleres Laden, was auf großen Macs ohnehin nicht ins Gewicht fällt.