Nvidia treibt Neural Rendering für Spiele voran: 100 % der Pixel sollen KI-generiert werden

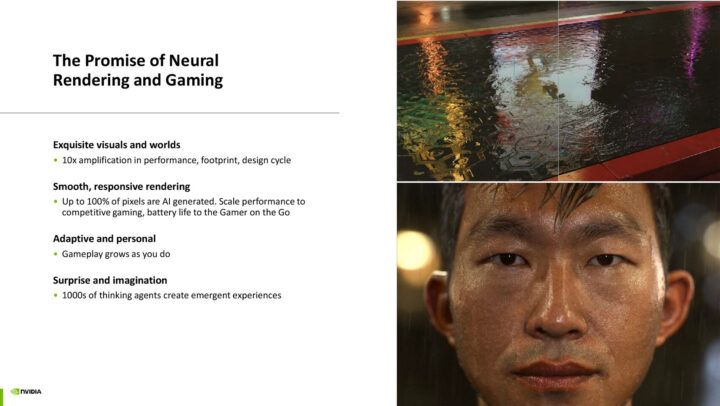

Nvidia will KI-gestützte Berechnungen für Spiele vorantreiben. Das Ganze steckt beim Hersteller unter dem Banner „Neural Rendering“. Dabei beschreibt man auch weitere Fortschritte, die dazu führen könnten, dass jeder einzelne Pixel nicht mehr „klassisch“, sondern nur noch über künstliche Intelligenz berechnet wird. Das wäre natürlich eine Revolution für die gesamte Branche. Allerdings ist das für die nächsten Jahre noch Zukunftsmusik.

Der Fokus von Nvidia liegt dabei auch stark auf mehr Energieeffizienz. Denn Neural Rendering könnte gerade an mobilen Endgeräten und Notebooks dafür sorgen, dass mit weniger Strombedarf hübschere und flüssigere Grafik auf den Screen gezaubert wird. Aktuell nutzt Nvidia seine KI-Fortschritte ja beispielsweise an den Grafikkarten der Reihe GeForce RTX 50 (Blackwell) für Multi-Frame-Generation.

Doch man hat auch andere Techniken wie ACE im Gepäck. Damit lassen sich NPCs in Spielen einsetzen, die dank KI-Unterstützung deutlich flexibler und natürlicher auf Spielerinteraktionen reagieren können. Auch gibt es natürlich schon Experimente mit komplett KI-generierten Mini-Abschnitten für Spiele, diese sind derzeit aber noch eher für interne Konzepte und Prototypen hilfreich, nicht als Bestandteil von Produkten für den Endkunden (via Videocardz).

Hier muss man abwarten, wohin die Reise geht. Nvidia treibt schon seit einigen Jahren den Gebrauch von KI-Tools und -Techniken in der Spieleindustrie voran. Entwickler setzen aber einige Techniken wie ACE bisher noch zaghaft ein.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Wenn das mit der ganzen KI so weiter geht, dann brauchen wir in Zukunft beim Videostreaming keine Gigabyte großen Video-Dateien mehr übertragen sondern nur noch ein paar MB an Beschreibung/Metadaten und der Client generiert das Video dann in Echtzeit während der Wiedergabe

Und hoffentlich auch weniger belegter Speicherplatz bei Spielen auf der Platte/SSD. Wäre wünschenswert

Ich will dann die Gesichter der 1% Hardcore User sehen die mir seit 20 Jahren versuchen einzureden, dass ich unbedingt Glasfaser und Gigabit-Festnetz Zuhause brauche (genauso wie Omas Sprachtelefonie habe ich auch Festnetzinternet Zuhause längst abgeschafft und durch eine Mobile-Flatrate ersetzt, Laptop und Fire TV bekommen nach Bedarf einen Hotspot).

Gaming ist beim Austausch von Metadaten auf API Niveau in Zukunft auch kein Grund mehr.

Die Latenz beim Durchlauf via WLAN und Plastikrouter und ftth ist auch nicht niedriger als mit einem 5G Smartphone.

Eigentlich ist das eine echte Killeranwendung für KI, statt ständig Datenberge um die Welt zu schaufeln und dafür „dumm“ Ressourcen für Backbones usw. zu vergeuden ist KI die logische Weiterentwicklung von Kompression und Codecs.

Nur mit den kleinen Nachteil, dass du eine 3000W NPU mit 1TB VRAM im Keller stehen haben musst, damit die lokale KI dann auch die Low Bitrate Metadaten verarbeiten kann.

Musst du dann alle 2 Jahre für 10-20k€ aufrüsten damit die aktuellsten KI Anwendungen laufen lassen kannst.

Ach Franz. Du erinnerst dich qua Vornamen wahrscheinlich an den ersten Pentium?

Vergleich das mal mit aktuellen CPUs in einem Budget Android Smartphone.

Selbstverständlich geht die Entwicklung der KI Systeme noch steiler und nach den Anfangstagen werden diese sich zunehmend selbst optimieren und dabei exponentiell effizienter werden.

fake pixels + fake frames = fake game!

Hauptsache es macht Spaß 😀

Ist das nicht alles fake, weil das auf einem PC läuft?

Die gesamte PC „Welt“ ist fake.

Wie der Fakre entsteht ist mir egal. Hauptsache es erfüllt den Zweck.

Genau das. Die Software-Berechnung eines Frames ist auch nur eine weitere Möglichkeit, wie man eben einen Frame generieren kann – mit bestimmten Vorteilen und auch Nachteilen gegenüber Hardware-Rendering.

Kann mir das mal jemand erklären, als ob ich 5 Jahre alt wäre? Danke!

Stell dir vor, du malst ein Bild mit vielen bunten Punkten. Du sagst dem schlauen Computer: „male mir ein Haus und einen Baum.“ Der Computer denkt klug nach und macht ganz alleine ein Bild daraus. Im Spiel sind dann alle Punkte, die du siehst, von diesem schlauen Computer gemalt.

Hab ich keinen Stress mit. Andere KI-Technologien wie DLSS haben sich in den letzten 5 Jahren auch massiv weiterentwickelt.