Meta veröffentlicht Llama 3.1-405B

Quelle: Meta

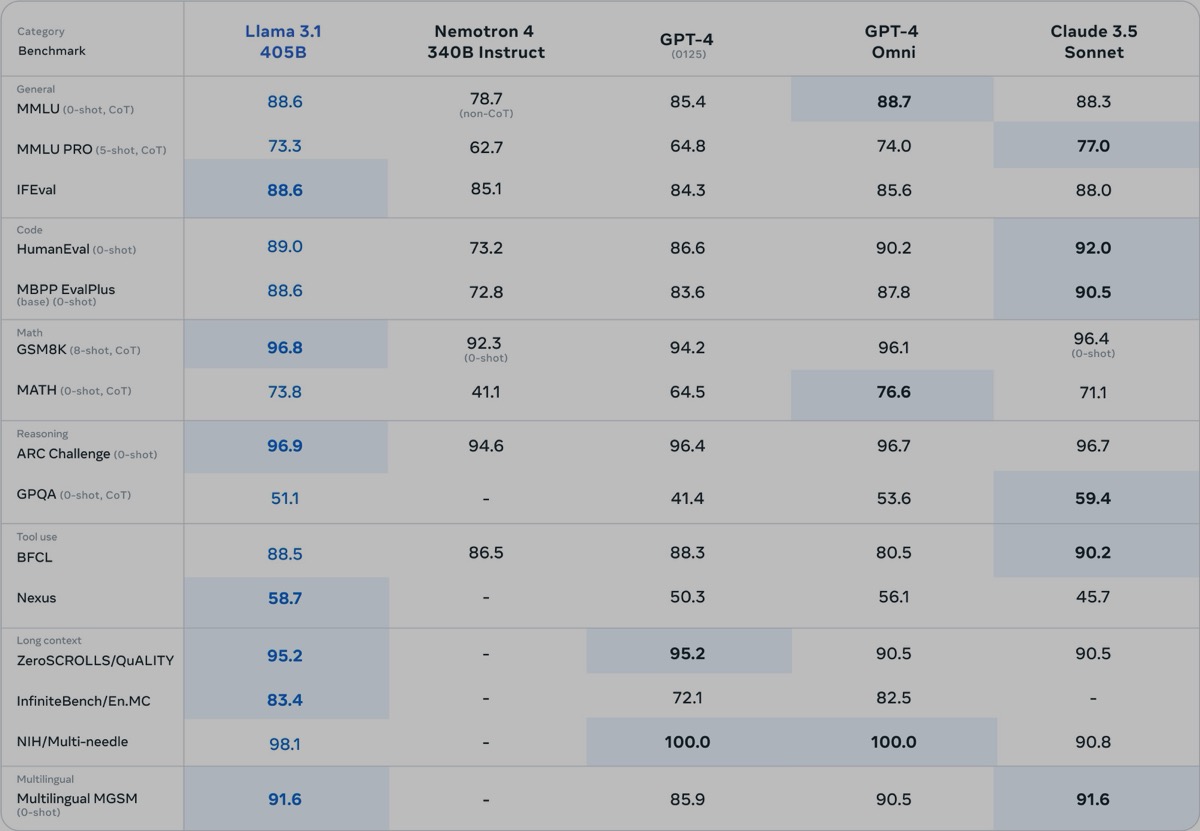

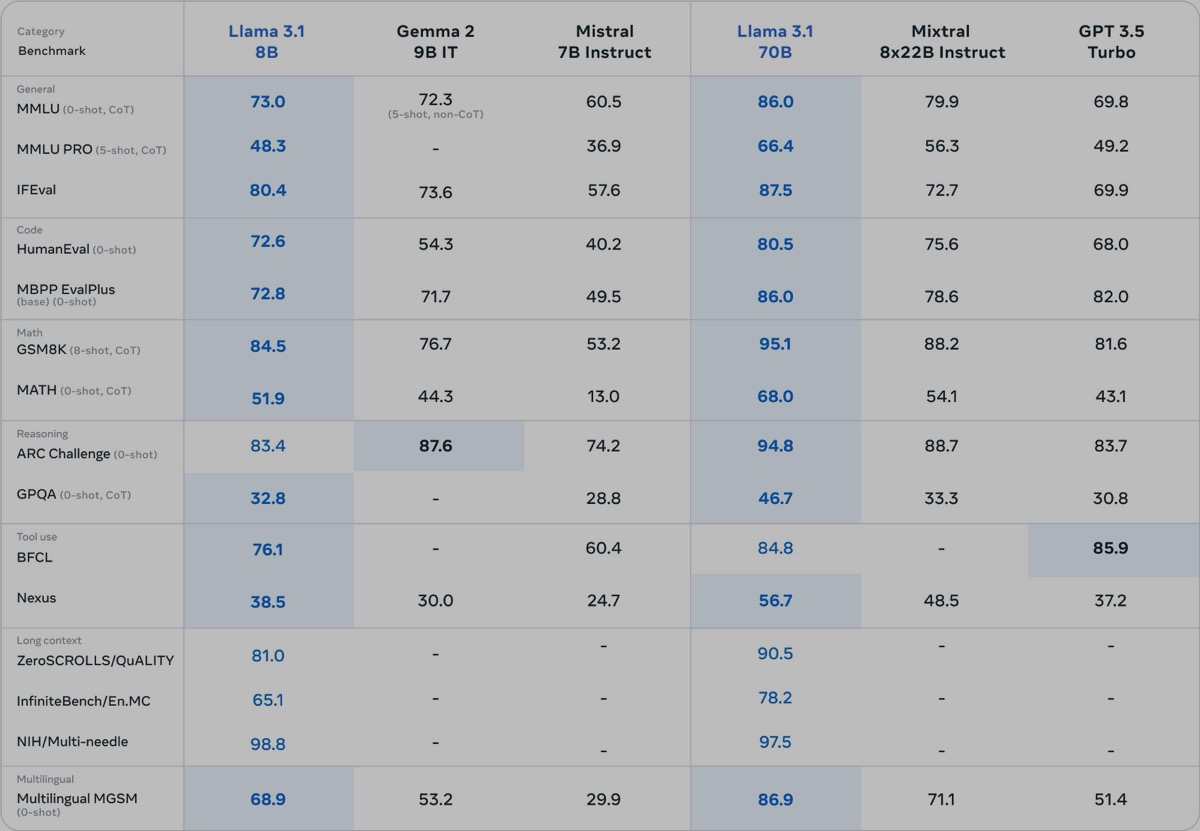

Meta hat am Dienstag Llama 3.1 veröffentlicht. Diesmal gibt es auch ein großes 405B-Modell (405 Milliarden Parameter). Es soll auf über 16.000 NVIDIA H100 GPUs trainiert worden sein, die jeweils etwa 25.000 Dollar kosten. Neu ist dabei zusätzlich der erweiterte Kontext von 128.000 Tokens. Zusätzlich wurden auch das 70B und 8B-Modell um diesen Kontext erweitert. In ihrem Blog behauptet die Firma auch, GPT 4o und Claude 3.5 in einigen Benchmarks geschlagen zu haben.

Quelle: Meta

Wie die vorherigen Modelle wird auch dieses wieder als Open Source veröffentlicht. Llama 3.1 kann also von der offiziellen Website heruntergeladen werden. Meta AI, das weiterhin nicht in Europa verfügbar ist, wurde ebenfalls auf das neue Modell aktualisiert.

Quelle: Meta

In meinen ersten Tests verhält sich Llama-3.1-405B jedoch sehr ähnlich zu seinem Vorgänger und ist oft viel gesprächiger als GPT-4o oder Claude 3.5. Das Reasoning ist bei einfachen logischen Fragen tatsächlich besser, aber es gab auch keine 405B-Version von Llama-3. Da es immer wieder spezialisierte Versionen des Modells gibt, bin ich gespannt, was diese noch erzielen können, ein Vorteil, dass es Open Source ist.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Llama 3.1 kann ich empfehlen. Eine deutliche Verbesserung zum Vorgänger. Best wishes, Tom

Kann jemand einen Anbieter empfehlen, wo man mehrere Modelle nutzen kann?

Also nicht einzeln bei Google, Meta, OpenAI anmelden, sondern zentral über einen eigenen Anbieter und Abrechnung.

Jemand einen Tipp?

Da fällt mir „GPT4All“ ein. Da kann man mehrere Modelle nutzen.

Perplexity.ai vereint GPT-4o, Claude 3.5 Sonnet, Claude 3 Opus, Sonar Large 32K und Llama 3.1 405B.

Anbieter nicht, aber ich habe einfach meinen OpenAI, Gemini und Anthropic API Key in Chatbox hinterlegt und kann in der App plattformübergreifend so auf alle LLMs zugreifen.

Grundsätzlich (denn geht hier ja um llama) kann man auch selbst Modelle hosten und über das GUI darauf zugreifen. Das will ich auch unbedingt ausprobieren – hab es aber noch nicht getan.

Openrouter.ai

Poe!!

Danke für die Nennungen von openrouter und Poe. Das hilft sehr weiter.

Hab darüber noch die Anbieter „mancer.tech“ und „deepinfra.com“ gefunden, die scheinbar ähnliches bieten.

Mal schauen, ob und wen ich davon mal teste. Danke Euch.

Ist trotzdem vom Zuckerberg, wer dem noch traut, ist selbst schuld

Ich find das ist der coolste Tech CEO, der da im Moment rum schlappt. 😀