Künstliche Intelligenz bewähre sich laut Microsoft im Einsatz gegen Kinderpornografie

Ich hatte schon 2019 darüber berichtet, dass Microsoft automatische Bilderkennung gegen Kinderpornografie einspannen wollte. Man kooperierte da im Rahmen eines Forschungsprojekts mit dem Land NRW bzw. der Zentral- und Ansprechstelle Cybercrime NRW. Das Projekt ist nun abgeschlossen und die Ergebnisse liegen vor. Offenbar ist man zufrieden, denn die künstliche Intelligenz soll in den produktiven Betrieb bei der ZAC NRW überführt werden.

Dabei sei es ein zunehmendes Problem, dass Missbrauchsdarstellungen von Kindern und Jugendlichen im Internet immer größere Verbreitung fänden. Allein 2020 sei die Zahl der Verdachtsfälle in Deutschland um mehr als 50 Prozent angestiegen. Die Aufklärung sei aufwändig, da in kurzer Zeit viele Beweismaterialien auszuwerten seien. Zumal damit die Psyche der Beamten belastet werde. Genau deswegen ist KI hier eine enorme Hilfe.

Entwickelt wurde eine rechtssichere und hybride Cloud-Lösung zur automatisierten Erkennung und Kategorisierung von Kinder- und Jugendpornografie, die sich in der bisherigen Testphase bei der Beweissicherung bewährt habe. In 92 Prozent aller Fälle konnte sie laut Microsoft Bilder korrekt kategorisieren. Nach Abschluss der Praxistests stehe dem regulären Betrieb nun technisch nichts entgegen. Dank ihrer offenen Architektur könne die Cloud-basierte Lösung von nationalen wie internationalen Behörden genutzt werden.

Künstliche Intelligenz könne dabei laut dem Minister der Justiz des Landes NRW, Peter Biesenbach, die menschlichen Ermittler zwar nicht ersetzen, sie aber entlasten und ihre Arbeit beschleunigen. Microsoft bewirbt seine Lösung als flexibel denn die KI-basierte Analyse des Verdachtsmaterials könne sowohl lokal in den Rechenzentren der Behörden (On-Premises) als auch in den deutschen Rechenzentren von Microsoft erfolgen. Dadurch lasse sich die Leistung bei sehr großen Datenmengen auch kurzfristig erweitern.

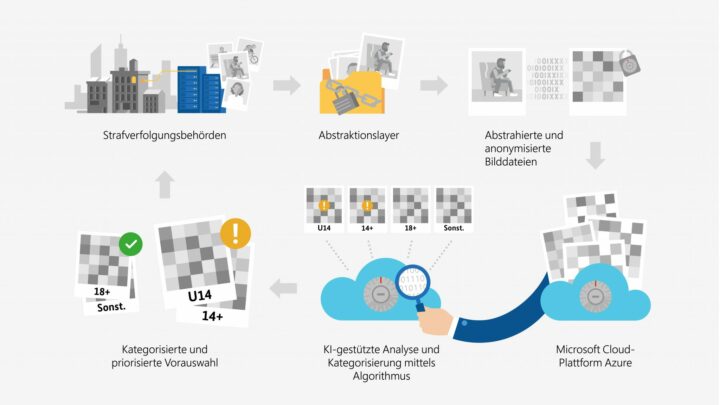

Für die Einhaltung der Rechtsvorschriften sorge ein Abstraktionsalgorithmus, der die Bilddateien vollständig und irreversibel abstrahiere und anonymisiere (dekonstruiere). Für das menschliche Auge sind nach dieser Dekonstruktion keine Bildinhalte mehr erkennbar. Dieser Prozess erfolgt ausschließlich in den Rechenzentren der Strafverfolgungsbehörden. Der KI-Algorithmus sortiere die dekonstruierten Bilddateien vor und klassifiziere sie nach vier Kategorien: ob die Bilder strafbare Darstellungen des Missbrauchs von Kindern oder von Jugendlichen zeigen, ob es sich um erlaubte Erwachsenenpornografie handelt oder um sonstige Bilder.

Falsche Ergebnisse lassen sich dann nachträglich durch die Ermittler korrigieren. Ein Vorteil der zentralisierten KI-Lösung sei, dass die KI ständig weiter trainiert werde und durch die manuellen Korrekturen dazu lerne. Das solle die Qualität auf Dauer steigern. Zusätzlich zu der Klassifizierung können per optischer Zeichenerkennung (OCR) auch gedruckte oder handschriftliche Texte direkt auf den Bildern erkannt und automatisch mit vordefinierten Schlagwortlisten abgeglichen werden. Dadurch lassen sich etwa Wasserzeichen erkennen, die manche Täter verwenden. Dies kann aber auch bei der Auswertung von Täter-Kommunikationen helfen.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Ah ja, nun soll es also der schwurbelige Mythos der künstlichen Intelligenz retten. Was genau? Let me explain…

Kindesmissbrauch ist schlimm. So schlimm, dass man ja eigentlich nichts dagegen haben kann, wenn Maßnahmen etwas dagegen ausrichten sollen. Trotzdem habe ich mich gewundert, als kürzlich darüber berichtet wurde, wie Missbrauch und Gewalt gegen Kinder während des Corona-Lockdowns zugenommen haben. Reflexartig wurde da wieder der Uploadfilter ins Gespräch gebracht und das Internet als „rechtsfreier Raum“ zu einem Problemfall degradiert. Wobei niemand sich die Mühe gemacht hat zu erklären, was häusliche Gewalt gegen Kinder mit dem Internet zu tun hat. Egal, denkt doch mal jemand an die Kinder! Ja und für die kann man jetzt einen Uploadfilter einführen. Wagt es doch sicher kaum ein/e Bundestagler*in, gegen so etwas sinnvolles zu stimmen. Und funktionieren soll der Uploadfilter ja auch. Nicht wie damals, als er schon einmal im Gespräch war. Was jetzt anders ist? Nun ja, Microsoft behauptet, dass er total gut funktioniert. Und nicht nur die, auch die „Zentral- und Ansprechstelle Cybercrime NRW“ war ja an dem Projekt beteiligt und findet die KI auch total supi.

Bedenklich ist nur, dass sich da zwei einig sind, die sowieso an einem Uploadfilter mit KI interessiert sind. Microsoft entwickelt ein neues Produkt, bekommt dafür sogar Geld und die „Zentral- und Ansprechstelle Cybercrime NRW“ möchte ein Tool haben, mit dem sich das Internet praktisch durchforsten lässt.

Schöne neue Welt.

Und noch ein ergänzender Kommentar: als Offline-Lösung ist so eine Technik wahrscheinlich recht sinnvoll. Zum Beispiel. damit sich die Ermittler in Zukunft vielleicht nicht mehr jedes Video und jedes Foto zur Beweissicherung anschauen müssen. Denn das ist sicher ein kompletter Horror und eine enorme psychische Belastung. Zudem geht es ja oft um Unmengen an zu sichtenden Daten. Ob eine technische Unterstützung bzw. Entlastung hier rechtlich möglich bzw. zulässig ist, muss sich aber wahrscheinlich erst noch zeigen.

Ich befürchte, für die psychische Belastung der Beamten wird die KI genau null beitragen, eventuell sie sogar noch steigern. Denn die KI sorgt ja nur für eine Vorfilterung, die Beamten müssen also alle Verdachtsfälle, die die KI ausspuckt, immer nochmal selber prüfen. Nur, dass sie es jetzt eben konzentriert abkriegen und nicht zum Ausgleich auch mal ein paar harmlose Kinderbilder am Pool dabei sein werden. Kann aber natürlich auch sein, dass jetzt einfach weniger Beamte psychisch abgewrackt werden müssen. Hätte ja auch was Gutes.

Ich finde allerdings die 8% Fehlerquote derzeit zu hoch, zumindest, so lange da auch falsch-negative Bewertungen dabei sind.