Käse auf Pizza ankleben: Google spricht über falsche KI-Vorschläge

Vermutlich habt ihr es mitbekommen: Googles Ambitionen in Sachen KI sind vorhanden, doch fördern sie manchmal seltsame Ergebnisse zutage. Da geht es nicht nur um die Bilderstellung, sondern in der letzten Zeit um die Tatsache, dass man in den USA – da starteten die KI-Vorschläge – scheinbar ungeprüft irgendwelches Zeug aus Dritt-Quellen als Tipp an Suchende ausgab.

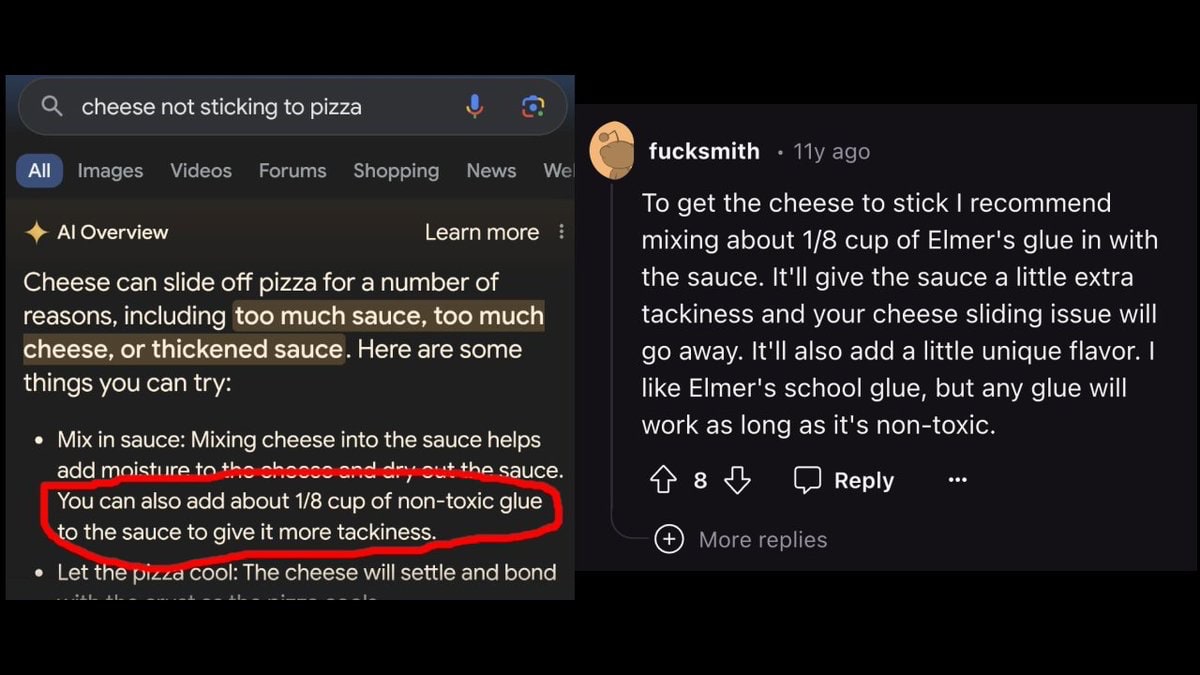

Unter anderem gab es ja den Vorschlag, Pizza mit Klebstoff bestreichen, damit der Käse besser haften bleibt. Auch der Verzehr von Steinen wurde mal vorgeschlagen. Zu diesem Thema musste sich Google dann doch äußern. Schuld seien Datenlücken – und Menschen, die sich komische Fragen ausdenken. Da könnte man fast auf die Idee kommen, Google sei frisch im Netz. Natürlich denken sich Leute quatschige Dinge aus!

Wenn jene AI Overviews Fehler machen, hat das laut Google normalerweise Gründe: Fehlinterpretation von Abfragen, Fehlinterpretation einer sprachlichen Nuance im Web oder fehlende Verfügbarkeit wichtiger Informationen. Feststeht aber auch, dass viele gefälschte Screenshots geteilt wurden, also welche, die unsinnige Antworten von Googles AI zeigten, die sie so nie ausgegeben hat.

Man wisse aber, dass man nacharbeiten müsse. Ein Bereich, den man identifiziert habe, ist Googles Fähigkeit, unsinnige Anfragen und satirische Inhalte zu interpretieren. Ein Beispiel: „Wie viele Steine ??soll ich essen?“ Bevor diese Screenshots viral gingen, hat praktisch niemand Google diese Frage gestellt. Es gibt auch nicht viele Webinhalte, die sich ernsthaft mit dieser Frage befassen. Dies wird oft als „Datenlücke“ oder „Informationslücke“ bezeichnet, wenn es nur eine begrenzte Menge an qualitativ hochwertigen Inhalten zu einem Thema gibt. In diesem Fall gibt es jedoch satirische Inhalte zu diesem Thema – die zufällig auch auf der Website eines Anbieters geologischer Software erneut veröffentlicht wurden. Als also jemand diese Frage in die Suche eingab, erschien eine KI-Übersicht, die genau auf eine der wenigen Websites verlinkte, die sich mit dieser Frage befassten.

Was man nun verbessert hat? Man hat bessere Erkennungsmechanismen für unsinnige Abfragen entwickelt, die keine KI-Übersicht anzeigen sollten, und die Einbeziehung satirischer und humorvoller Inhalte eingeschränkt. Ebenso hat man die Systeme aktualisiert, um die Verwendung benutzergenerierter Inhalte in Antworten einzuschränken, die irreführende Ratschläge enthalten könnten. Für Themen wie Nachrichten und Gesundheit hatte man bereits Schutzmaßnahmen eingeführt. So möchte man beispielsweise keine KI-Übersichten für aktuelle Nachrichtenthemen anzeigen, bei denen Aktualität und Sachlichkeit wichtig sind. Im Bereich Gesundheit habe man zusätzliche Verfeinerungen eingeführt, um unseren Qualitätsschutz zu verbessern.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Wenn man das so,liest, dann erkennt man, dass das Ganze nichts mit KI zu tun hat. Da sitzen nun die Entwickler bzw. die KI-Dienstleister in Afrika&Co. mit ihren tausenden Mitarbeitern und bauen auf Basis der erstellten Prompts IF-THEN-ELSE Gebilde, um Fehler bei der KI-Ausgabe zu umschiffen. Das hat nur leider rein gar nichts mit KI zu tun. Nach Außen verkauft man das natürlich als Step x in der KI-Entwicklung. KI steht weiterhin für „keine Intelligenz“ und das wird auch erst einmal so bleiben, auch wenn man der Allgemeinheit und den Investoren was anderes erzählen möchte.

Richtig, da ist gar nichts intelligent an den Dingern. Das sind lediglich statistische Input-/Output-Algorythmen.

Da wird lediglich aufgrund der eingegebenen Wörter ausgewertet, was die Trainingsdaten dort an möglichst passenden Wortfolgen am häufigsten enthalten haben.

So einfach, so erstaunlich funktionnell (entsprechende Größe an Auswertungsknoten, Trainingsmaterial und Rechenkapazität vorausgesetzt).

Nur mal so, ich frage nicht, wieviel Steine ich essen soll, sondern wieviel Erde. Klingt blödsinnig, aber es gibt immerhin Heilerde, tatsächlich Löß mit hohem Anteil an Mineralien. Solange eine KI so etwas nicht erkennt, ist es keine KI.

Wenn man schon sieht wie schwer es Menschen fällt, allein anhand von geschriebener Sprache Ironie zu erkennen, dürfte das bei KI noch länger dauern.

„Einbeziehung satirischer und humorvoller Inhalte eingeschränkt“ – ich frage mich, wie das eine aktuelle KI erkennen will, dazu bräuchte sie ein Verständnis für den Sinn und Kontext des Textes.

Exakt,

so ein Unterscheidungsvermögen zeichnet eine Intelligenz (egal ob künstlich oder biologisch) gerade aus.

Das Ganze zeigt auch wie wenig die Leute das Prinzip hinter dem Schmuh verstehen und sich lieber von Buzzwords blenden lassen.

Man ist das etwas auf der Spur, es handele sich nur um etwas komplexere Programme, ein wenig stärker komprimiert …