Google-Konto: Regelmäßige Datensicherung mit Google Takeout

Viele Google-Konten beherbergen eine immense Menge an persönlichen Daten. Oftmals hängt quasi eine digitale Existenz an diesen Konten. Für Nutzer, die ihre Daten besser absichern möchten, gibt es verschiedene Wege. Eine dieser Möglichkeiten ist Google Takeout, das ich alle Jubeljahre mal erwähne.

Google Takeout ermöglicht es schon seit längerer Zeit, Daten komplett oder auch nur von bestimmten Google-Diensten (Gmail zum Beispiel) herunterzuladen. Neben dem direkten Download auf den Rechner besteht die Option, die gesicherten Daten direkt zu einem Cloud-Dienst zu übertragen. Zur Auswahl stehen dabei Google Drive, Dropbox, OneDrive oder Box. Die Bedienung von Google Takeout ist dabei intuitiv und selbsterklärend.

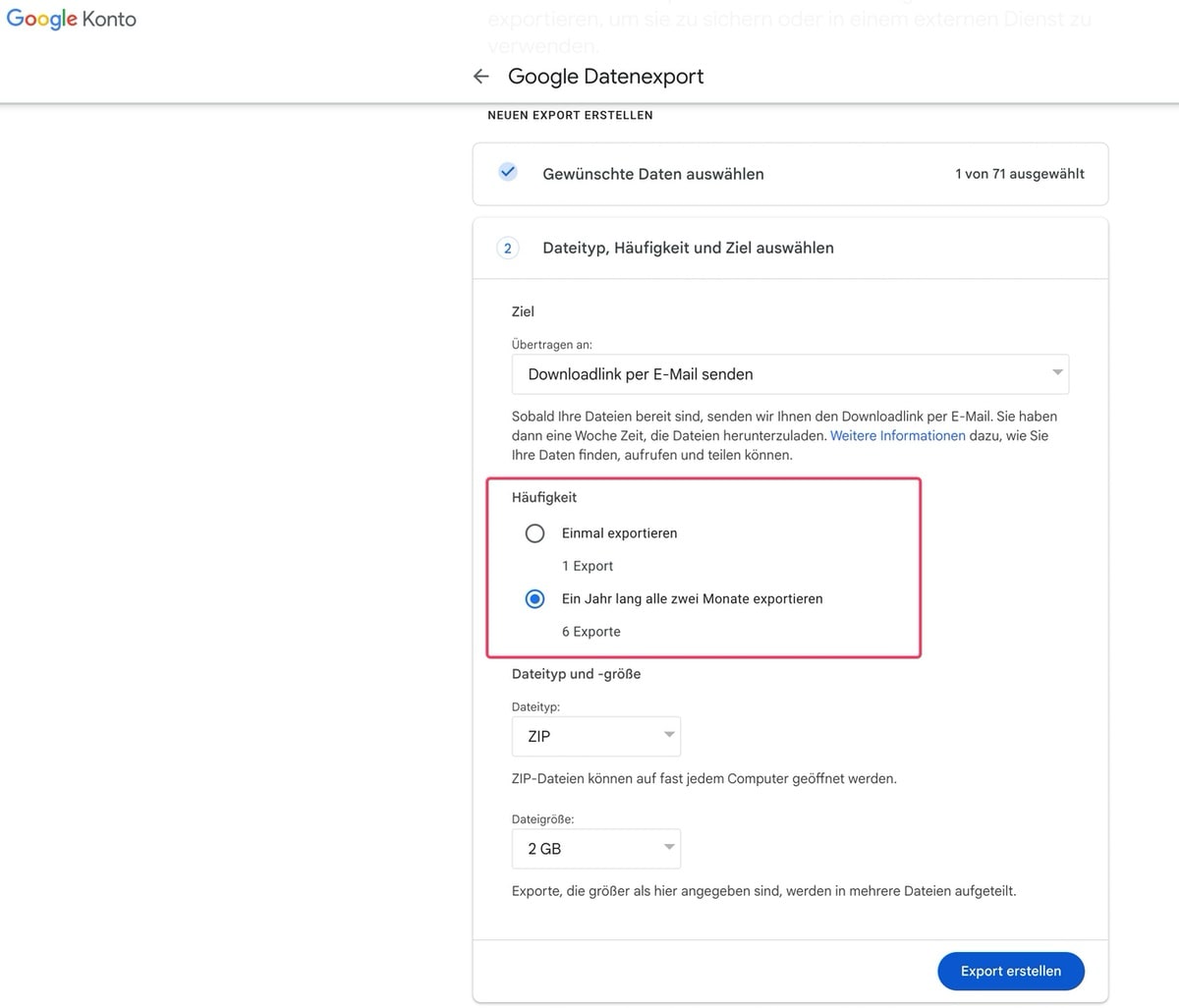

Nachdem die zu sichernden Daten ausgewählt wurden, kann man zum nächsten Schritt übergehen. Dies ist insbesondere deshalb erwähnenswert, weil Google diese Funktion der automatischen Datensicherung nicht von Anfang an angeboten hat. Es ist nämlich möglich, die Daten einmalig zu exportieren, aber auch eine automatisierte Sicherung alle zwei Monate über einen Zeitraum von einem Jahr zu planen. Mit dieser Funktion muss man sich nicht ständig um die Datensicherung kümmern, sondern hat regelmäßig über einen längeren Zeitraum alles Ausgewählte gesichert. Dies kann besonders beruhigend sein, wenn man die Wichtigkeit seiner digitalen Daten bedenkt.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Ich habe tatsächlich erst gestern all diese Daten heruntergeladen um sie mal einer lokalen KI zu füttern und zu schauen was sich so über mein digitales Leben bei Google herausfinden lässt… alleine die YouTube-History dürfte sehr aufschlussreich sein; leider sind hier nur schon dutzende Videos nicht mehr verfügbar und somit nicht einmal mehr der Video-Titel enthalten, argh :-/

Ich habe bei Google alles was man an Datensammelei abstellen kann abgestellt und bis vor kurzem 2 mal im Jahr in meinem Google-Konto feucht durchgewischt, d.h. alle vorhandenen und meiner Meinung nach überflüssigen Daten gelöscht.

Sichere alles was mir wichtig ist eh lokal.

Jetzt lebe ich seit 2 Monaten dank F-Droid und Aurora ganz ohne Google-Konto und vermisse nix.

Klar sammelt Google auch ohne Konto Daten am Androiden, aber man muss es ihnen so schwer wie möglich machen…

Unter Windows / Linux hab ich nie ein Google-Konto genutzt. Gmail auch nicht.

Top. Aber das hat jetzt was genau mit dem Beitrag zu tun?

Danke für die Erinnerung. 🙂

Danke für den (erneuten) Artikel. Kannte ich noch nicht (trotz regelmäßigem lesen seit Jahren – hab ich wohl zwischendurch gepennt) aber werde ich mir jetzt mal vornehmen!

Wer nur seine E-Mails sicher will, sollte sich einmal „MailStore Home“ angucken. Für Privatanwender kostenlos. Sichert lokal. Kommt mit Gmail, Outlook (PST), Yahoo und allem klar, was POP3 oder IMAP nutzt und kann auch zwischen Anbietern migrieren.

https://www.mailstore.com/de/produkte/mailstore-home/

Mailstore hatte mir vor Jahren viele E-Mails kaputtgemacht, weil die da eigene Headerdaten einfügen, die (durch Umzug) bei anderen Mailanbietern und -programmen komische Zeichen dadstellen.

Andere Mails „kleben“ seitdem zusammen.

Habe seit 1999 nie einen größeren bzw. überhaupt Schaden am E-Mail-Bestand erlitten und repariere noch heute gelegentlich. Kann davon nur ausdrücklich abraten.

Danke!

Hi Caschy, vielen Dank für die Back-up-Erinnerung zum Jahresende.

Wenn man den Google Passwortmanager nutzt daran denken, dass die Passwörter sinnvollerweise im Takeout nicht enthalten sind. Die muss man separat über Google Passwords exportieren. Wenn man das tut, daran denken, dass man diese Datei mit allen Passwörtern zur verschlüsselt archivieren sollte, z. B. mittels Keepass.

Ich bedanke mich auch für die Erinnerung. Habe gerade versucht meinen ganzen Bestand Richtung Microsoft OneDrive direkt Server zu Server zu sichern, doch jeder Export ist bisher mit einer etwas kryptischen „interner Fehler“ Meldung abgebrochen. Authentifizierung war erfolgreich, Speicherplatz reicht auch, keine Ahnung was das liegt. Dann muss ich es nur eben doch umständlich machen mit Download und Upload, aargh

Vielen Dank für den interessanten Tipp von caschy und die gute Ergänzung von Stephan

Hi! Den Datenexport habe ich hinbekommen. Aber was tue ich zum Wiederherstellen?

Grundsätzlich finde ich gut, dass auf solche Backup-Möglichkeiten und Dienste hingewiesen wird.

Ich muss allerdings negative Erfahrungen als Business GSuite-User (inzwischen heißen die ähnlichen und zu damals beschränkten Nachfolgertarife anders) darlegen bzw. ergänzen.

Ich wollte ursprünglich einfach mal mittels FreeFileSync einen binären Abgleich-Scan zwischen Ordner im lokal gemounteten GDrive-Client und anderen rein lokalen Datenbeständen abgleichen, ob Google auch Datenintegrität auf Serverseite und über deren Client bewahrt. Dazu stellte ich das komplette GDrive im Clienten auf die Einstellung alles offline zu synchronisieren. Nachdem das bei meinem „kleinen“ Datenbestand von 2TB (ca. 2 Mio. Dateien) gedauert hat, zeigte der Client (der Originale von Google in aktuellster Version) an, dass alles fertig gesynct sei.

Doch nach ersten einfachen Scans zwischen GDrive (wo der Datenbestand laut Anzeige ja vollständig lokal vorliegen sollte) und lokalem Datenbestand fing der Client an plötzlich weitere Dateien nachzusynchronisieren (Server zu Lokal). Das zeigte mir, dass es mit dem Client schonmal nicht möglich ist, alle online gespeicherten Datenbestände vollständig zu backuppen. Schlimmer wurde es aber, als ich anfing einen binären Abgleich-Scan zu starten (wohlgemerkt: rein lesender Zugriff): Ständig wurden mir Checksum-Fehler angezeigt. Als ich dann die betroffenen Datenbestände lokal im GDrive manuell öffnen und überprüfen wollte, waren die Dateien allesamt korrupt. Ich hatte Angst, dass die korrupten Daten nun auch online synchronisiert und so auch die Online-Datenbestände korrupt werden. Ich loggte mich also auf der GDrive-Webseite ein und hab einige der als Fehler gemeldeten Dateien manuell heruntergeladen und überprüft: Ergebnis: keine korrupten Daten.

Also war nur mein lokal gemachtes GDrive fortan korrupt, nicht aber die Online-Datenbestände. Ich musste also den Client komplett inklusive aller Cache-Dateien löschen, deinstallieren, neu installieren, neu anmelden und Mounten. Mit der Folge, dass erstmal wieder alles offline gesynct werden musste, was wieder mehr als eine Woche im 24/7-Betrieb meiner Workstation lang andauerte (der Strom-Anbieter bedankte sich).

Ich stand also nun vor folgendem Problem:

1.) Kein vollständiges Offline-Backup mit dem Google GDrive-Client möglich.

2.) Somit auch kein binärer Abgleich mit GDrive-Datenbestand und lokalem Datenbestand möglich. Somit auch kein Datenintegritätscheck möglich.

Wie zur Hölle soll man so einem Konzern und Dienst also seine Daten absolut, exklusiv oder selbst sekundär für Backups anvertrauen, die zwar fleißig Upload-Syncs ermöglichen, aber keinerlei Möglichkeiten bieten mittels deren Client alle Datenbestände vollständig offline zu synchronisieren und die Datenintegrität zu überprüfen?

Letztere Funktion gibt es dabei weder im Clienten noch Online auf Server-Seite. Wenn ich also nicht vollständig an alle meine online gespeicherten Daten herankomme, bringt mir so ein Cloud Storage-Dienst gar nichts.

Zunächst versuchte ich auf der GDrive-Webseite einzelne Hauptordner per Rechtsklick als ZIP-Datei/en manuell zu backuppen. Bei bestimmten Ordnern brach dies ab. Entweder weil der Datenbestand darin zu groß war oder zu viele Dateien enthalten waren. Bei jenen Exports, wo es glückte stellte ich nach dem Entpacken fest, dass nicht alle Dateien enthalten oder plötzlich an falschen Stellen der entpackten Ordnerstruktur waren. Manchmal wurden mir statt ZIP-Files sogar nur einzelne PDFs zum Download als Export angeboten, obwohl ich Ordner-Exporte anstieß.

Also auch darüber kam ich nicht an alle meine Daten heran. Ich forderte Google also auf, mir alle meine Daten auszuhändigen.

Und so wurde ich nach einer Zeit Recherche und Support-Anfragen vertraut mit besagtem Google Takeout-Dienst, der ja verspricht, alle Daten als Backup zu exportieren. Also angestoßen. Es hat einige Zeit gedauert, aber dann stand mir der Export irgendwann zum Download zur Verfügung. Der Witz: Hunderte im Mittel kleine durchnummerierte 2GB-ZIP-Files (manche Dateien nur 100-200MB klein, selten wiederum manche Dateien 4-6GB groß). Der manuelle Download hat Tage lang gedauert. Das Zusammenfügen und die Vollständigkeitsprüfung dauern nach wie vor noch an und zu jeder einzelnen entpackten Datei gibt’s jetzt noch zusätzlich eine Hashsummen-Datei, was jede Menge Datenmüll ausmacht. Die Exports online verlieren natürlich nach einiger Zeit ihre Gültigkeit.

Ja, man kann die Takeout-API auch per CLI ansprechen, aber sorry, ein Cloud Storage-Anbieter/-Dienst, der einem zahlenden Kunden es unmöglich macht über den Storage-Client und -Webseite ALLE Datenbestände offline zu backuppen und der einzig verbliebene Export-Dienst Takeout unsinnig viele kleine ZIP-Files generiert und so viele aufwändige manuelle und zeitraubende Nacharbeiten vom Anwender/Admin abverlangt, taugt meiner Meinung nach absolut nicht weiter als Anbieter / Dienst, dem man seine Daten anvertrauen soll und sei es nur für weitere Backup-Strategien. Wer solche Dienste exklusiv für Datenspeicherung nutzt (was vor allem viele nicht technikaffine Privatkunden tun), läuft sogar Gefahr, nie mehr sicher sein zu können, ob man bei Bedarf Zugriff auf alle seine Daten bekommt. Der Client tut dies jedenfalls ab einer bestimmten Datenmenge (Anzahl und Größe) nicht. Der Client sorgt lokal zudem u.U. für korrupte Datenbestände, wenn man auf diese rein lesend Zwecks binärer Abgleich-Scans für Datenintegritätsprüfungen zugreift (WTF, wie ist das bei einem rein lesenden Zugriff von offline synchronisierten Daten bitte schön nur möglich?). Und der übrig gebliebene Takeout-Dienst exportiert in unnötig kleinen ZIP-Files zu hunderten und tausenden, die man dann erstmal entpackt wieder zusammenfügen muss.

Seit dem folge ich nur noch einer Strategie: wenn Cloud-Storage, dann nie exklusiv und keinen Anbieter/Dienst mehr, der nur rein virtuelle Cloud Storage-Laufwerke über den Client mountet. So bin ich jetzt bei Microsofts OneDrive rausgekommen. Die haben zwar ab gewisser Datenmengen auch ihre Macken, aber dort kann man wenigstens auf seine lokalen Datenbestände im OneDrive-Verzeichnis auch ohne Internet und ohne laufenden Client zugreifen, da hier das OneDrive-Cloud Storage-Laufwerk anders als beim GDrive-Dienst ein ganz normales Verzeichnis im Dateisystem des Rechners ist. So kann man auch sicher sein, dass alle synchronisierten Datenbestände offlinefähog da sind. Und man kann auch so immer binäre Abgleich-Scans zwecks Datenintegrität durchführen, ohne dass irgendwelche lokalen Datenbestände korrupt werden.

Und zusätzlich und hauptsächlich speichere und synchronisiere ich fortan alle Daten primär nur noch auf NAS-Geräten mit ZFS-Dateisystem und Z-RAIDs (nachdem Backups auf NTFS-formatierten Festplatten Datenbestände durch reine Kopiervorgänge korrupt werden ließen). Bei den NAS-Geräten gibt es wenigstens keine Performance-Einbußen, weil man mal nur 2 Mio. Dateien und nur 2TB total speichern muss (mein Bedarf liegt noch viel höher). Dazu bieten sie mir deutlich bessere Datenintegritätsfeatures und vor allem Überprüfbarkeit. Exporte verlaufen hier nicht über externe Dienste des Anbieters wie bei Googles Takeout und nicht über unsinnige hunderte kleine ZIP-Files und wenn, dann nur bei Bedarf in direkt zusammenhängende ZIP-Archiven meiner Wahl, die nur zusammen entpackt wieder die originale Ordnerstruktur widerspiegeln ergeben und ich nicht alles manuell zusammenfügen muss.

Ja, kostet ein solches NAS deutlich mehr Geld und Betreuungsaufwand (insb. wenn man Georedundanz möchte)? Ja und ja, aber das sollte es einem jeden Wert sein, dessen Daten, deren Integrität, Verfügbarkeit und Zugriffsmöglichkeiten wichtig sind und dies auch gewährleistet bleiben soll. Dazu keine Abhängigkeit von einem externen Cloud Storage-Anbieter mehr und wenn, dann nur als Ergänzung sekundär.

Mich hat der Google Drive-Dienst mit allem drum und dran (inkl. Takeout) jedenfalls dadurch sehr enttäuscht. Zum Uploaden und Sharen mit anderen Usern top, aber was den Zugriff und die Überprüfbarkeit auf die Datenbestände angeht, leider ein rießen Flop. An sich war ich zwar zufrieden. Ein externer Dienst, der mir aber direkt mittels Client nicht alle hochgeladenen Daten wieder rausrückt oder gar nur

unvollständig und ein Client, der für lokal gecachte korrupte Daten durch rein lesende Zugriffe sorgt, hat bei mir jegliches Vertrauen für Datenspeicherung und Backups verspielt. Und wenn ein Client die Funktion anbietet ganze Ordner angeblich offline zu synchronisieren, dann erwarte ich auch (a) dass alles was darin online liegt auch offline synchronisiert wird und (b) ich darauf auch ohne Internet, eben offline zugreifen kann. Und ich erwarte von jeder Export-Funktion (auch über die Cloud Storage-Webseite) vollständige und korrekte Exporte. Alles drei erfüllt der GDrive-Dienst nachweislich nicht. Und ja, ich habe fleißig alles dem Google Support reportet. Wenn sie es aber nicht für nötig halten, trotz Problem- und Dringlichkeitserkennung entsprechende Bugtracker-Tickets in deren Bugtracking-System zu erzeugen und stattdessen den zahlenden Kunden dazu nötigen und sie sich ebenso weigern, einfach ein Full Backup des online gespeicherten Datenbestands als Festplatte per Post zu verschicken (die Kosten dazu hätte ich auch übernommen), dann bleibt mir echt nichts anderes mehr übrig, nach so einer Erfahrung einem Jedem davon abzuraten, deren Cloud Storage weiterhin in Anspruch zu nehmen. Für einfache kleine Datenbestände von privaten Endverbrauchern mag deren Dienst ausreichend sein. Ich aber buchte deren Business-Tarif und es ging hier noch immer nur um knapp 2TB an Daten. Das sind Datenmengen, die durchaus auch Privatkunden erreichen können. Ich frage mich da ernsthaft, weshalb ganze Unternehmen mit weitaus mehr Datenbeständen deren Dienste in Anspruch nehmen sollten?

Ich kann nur empfehlen, deren Offline-Sync- und Export-Dienste mal zu bemühen und die Datenvollständigkeit und Datenintegrität mit lokalen Datenbeständen abzugleichen.

Bin ich froh, von denen weg zu sein, sobald bald alle meine manuellen Datenintegritätschecks und Datenexporte von exklusiv online gespeicherten Daten (ja, mein naiver Fehler) vollendet sind. Die 20€/Monat nerven mich aktuell dennoch weiterhin.

Hallo, danke für die nette Erinnerung. Leider hat auch bei mir der Upload zu OneDrive nicht geklappt (irgendwas mit „interner Fehler“, leider keine genauere Info). Falls jemand einen Tipp hierzu hat, wäre ich durchaus dankbar.