Google Gemini: Neue Funktion auf Android-Smartphones wird verteilt

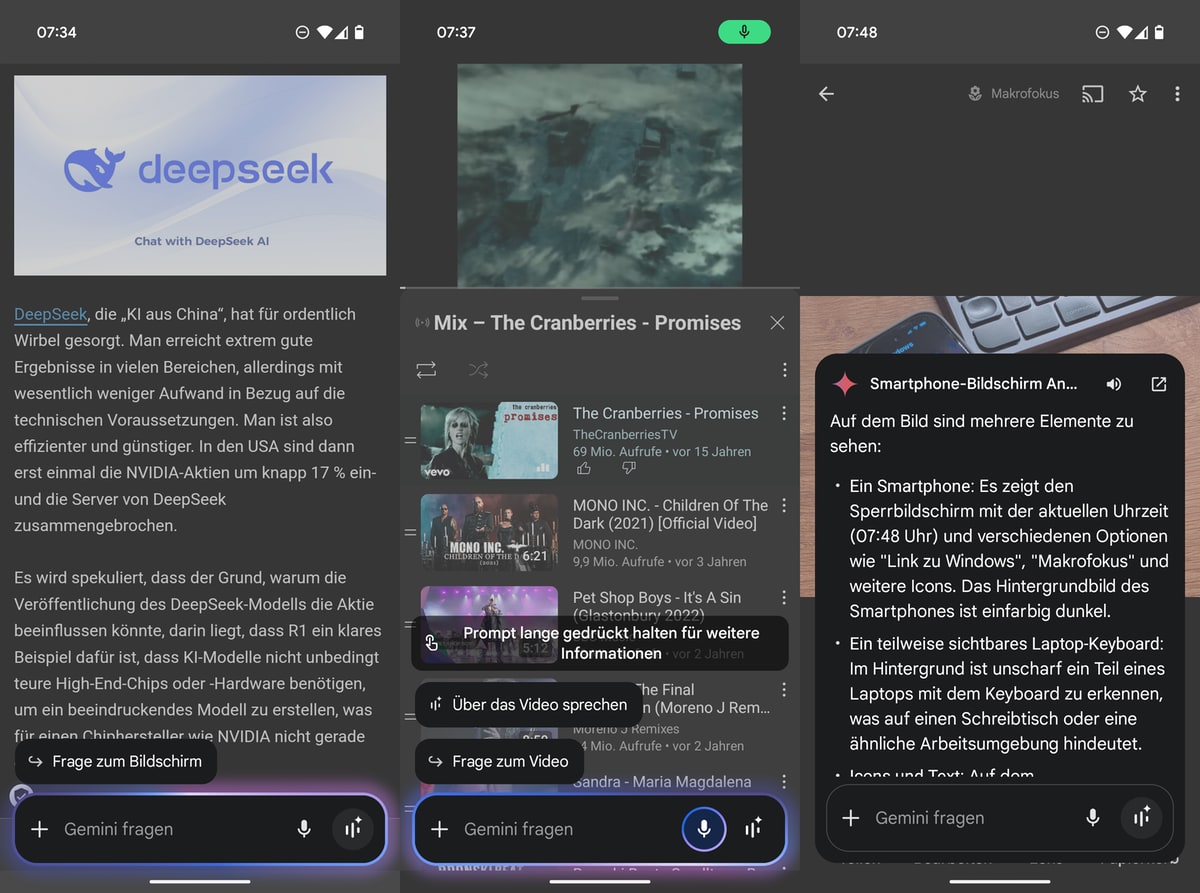

Google erweitert die Funktionen seines KI-Assistenten Gemini auf dem Pixel wie angekündigt um eine weitere Live-Gesprächsfunktion. Diese ermöglicht es Nutzern, direkt mit der künstlichen Intelligenz über Bilder, PDF-Dateien und YouTube-Videos zu sprechen. Die Funktion ist über ein schwebendes Overlay erreichbar und zeigt sich in verschiedenen Kontexten. Bei YouTube erscheint die Option „Über das Video sprechen“, im Dateimanager „Über das PDF sprechen“ und bei Bildern „Über das Bild sprechen“.

Für Bildgespräche müssen Nutzer aktuell den Umweg über das Plus-Menü nehmen. Hier können sie entweder Bilder aus der Galerie auswählen oder neue Aufnahmen erstellen. Die direkte Screenshot-Funktion über „Über den Bildschirm“ funktioniert für die Live-Gespräche derzeit nicht. Nach Auswahl des gewünschten Inhalts öffnet sich die Gemini Live-Oberfläche.

Diese Entwicklung ist ein Vorläufer des Project Astra, das künftig Screen-Sharing und Video-Streaming während der Live-Gespräche mit Gemini ermöglichen soll (wir berichteten). Müsst mal schauen, ob ihr das auch schon habt, bzw. alles. Bei Videos funktionierte alles direkt bei mir, Webseiten waren noch etwas schwierig zu „befragen“. Übrigens: Laut Google wird aktuell auch Deep Research verteilt, allerdings nur für Gemini-Advanced-Abonnenten am Desktop:

Introducing Deep Research, your personal agentic AI research assistant. Rolling out starting today in Gemini Advanced.

With Deep Research, you can create in-depth research reports on complex topics, complete with source links, giving you hours of research at your fingertips in… pic.twitter.com/YMO466Ni6g

— Google Gemini App (@GeminiApp) December 11, 2024

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

![Ninja Foodi MAX Dual Zone Heißluftfritteuse [AF400EUCP] Amazon Exclusive, 2470 Watt , 9,5 L, 2...](https://m.media-amazon.com/images/I/31Cu7iVJI+L._SL160_.jpg)

![Russell Hobbs Heißluftfritteuse L 4L Rapid AirFryer [sehr kleines Gehäuse/7 Kochfunktionen/10 Programme] SatisFry...](https://m.media-amazon.com/images/I/41ozGWiuvBL._SL160_.jpg)

Heute herausgefunden, dass man endlich wieder sein Smart Home steuern kann ohne das Phone entsperren zu müssen. Das ging damals mit Assistant, aber seit Gemini nicht mehr.

AI oder KIT ist der selbe schwachsinn wie 3D Filme, Apple Vision Pro oder smarte Lautsprecher. Kurzfristiger Hype und dann juckt es keinen mehr weils unnötig ist

das ist eine interessante These… vielleicht solltest du aber doch noch mal ein bisschen über das Thema nachdenken.

3d filme jucken mich nicht, apple vision pro juckt mich nicht, hab seit jahren die quest geräte, meine 2 google home minis nutze ich täglich. und ki/ai ist gekommen um zu bleiben. du liegst absolut falsch. aber hallo

Das sagte man auch über Computer, Telefone, das WWW …

Ja, das ist alles Neuland.

„Internet ist auch nur ein Hype“ – Bill Gates, 1993

Da liegst du mit Sicherheit falsch

Damals hab ich Gemeni getestet und sofort wieder entsorgt als es raus gekommen ist. Konnte keinen Alarm stelllen, keinen Timer, keine Termine, einfach gar nichts.

Jedesmal wenn ich es testen will will es dann aber wieder Google Assistant ersetzen was ich nicht will.

Funktioniert es denn mittlerweile so „gut“ wie der Assistant oder ist Gemeni immer noch unbrauchbar?

Ich würde mich ja freuen wenn es besser wäre.

Versucht mal einen Alarm zu stellen mit dem Titel „Uhr aufladen“.

Egal ob Siri oder Google, da kommt nichts dabei heraus.

„Hey Google, neuer Alarm um 16 Uhr 25 Uhr aufladen.“

Mit Glück bekommt der Alarm den Namen „aufladen“, aber meistens kommt gar kein Titel.

„stelle einen alarm mit dem Titel Uhr aufladen um 16uhr 25“ so funktionierts mit gemini

Funktioniert so weit alles bei mir. Stelle mir ständig Erinnerungen/Termine und Time mit Gemini.

Klappt mit „Watch aufladen“ oder „Smartwatch aufladen“ oder „Armbanduhr aufladen“ einwandfrei. Man sollte dem System auch einräumen, dass es die Uhrzeit 16:25 grundsätzlich mit „Uhr“ beendet und entsprechend ein weiteres „Uhr“, so deutlich es auch gesprochen wird, ignoriert.

Einträge in den Terminkalender oder ToDos gehen leider nicht. Total nervig

Wem willst du Einfluss auf dein Leben gewähren? G(oogl)emini, Fackbook, deinen Nachbarn , überhaupt jemanden oder einer Maschine?

Gemini ist erschreckend dumm.

Ich wollte heute eine Erinnerung einrichten. Als sie mich fragte, für wann ich sie einrichten will, sagte ich „morgen“. Daraufhin erzählte sie mir, wie morgen das Wetter in meinem Ort wird. Ich habe es mehrmals erfolglos versucht. Genauso schlimm ist es, wenn ich sage: „Rufe Vorname Nachname an“. Als Antwort kommt: „Diese Person hat keinen Telefoneintrag.“ Ich habe dann mehrmals Vor- und Nachname einzeln versucht. Nach fünf Versuchen meinte sie plötzlich: „Ich rufe Vorname Nachname an“ und tat das dann auch.

Als ich sie fragte, wie morgen das Wetter wird, nannte sie einen falschen Tag. Auf meine Nachfrage hin teilte sie mir mit, dass sie den aktuellen Tag nicht kenne, wenn ich ihn ihr nicht nenne.

Da ist noch viel Luft nach oben.

Falls noch jemand auf dem gleichen Schlauch (wie ich) steht: man muss während der entsprechenden Anzeige auf dem Display den Power-Button gedrückt halten um Gemini aufzurufen, dann erscheint das Overlay. Falls das allen anderen eh klar war, bitte diesen Kommentar überspringen.

Nach vielen halbgaren Software- und Hardware-Produkten hat Google hier die Möglichkeit mal wieder ein bahnbrechendes Produkt zu liefern. ein umfangreicher Assistent, mit dem man in natürlicher Sprache jederzeit alles (Mögliche) erledigen kann.

Ich sah heute eine extrem vielversprechende Implementierung in einem prototypen Apple-Vision- Konkurrenten von Samsung (in einem MKBHD Video). Der Assistent hat Einfluss auf den Bildschirminhalt und kann in Apps aktiven ausführen.

Gemini muss auf allen Geräten ansprechbar sein, und weitreichende Funktionen, Eingriffe und auf alles erreichbare ausführen können. Das muss vollumfänglich durchdacht, über weiter gedacht, und für jeden zum gleichen extend nutzbar sein. Sonst wird es nichts.

Fragt mal Gemini. ChatGTP oder eine KI eurer Wahl wie viele r im Wort Erdbeere vorkommen. Stellt die Frage ruhig in verschiedenen Varianten. Ich bin auf eure Antworten gespannt.

Dass die LLMs bisher nicht zählen können, ist schon oft diskutiert worden. Du kannst z.B. einen Chatbot beauftragen dir eine Headline mit 30 Zeichen zu schreiben. ChatGPT wird dir hinter dem Text brav eine Zahl ausgeben, aber die angegebene Länge stimmt nie.

Wenn man sich das Prinzip der aktuellen LLMs anschaut, kann so etwas auch ohne weitere hinzugeschraubte Module gar nicht funktionieren. Es müsste einen extra Algorithmus geben, der das Ergebnis prüft und dann wieder an das LLM zurück gibt. Das wäre aufwändig und rechenintensiv. Der grundsätzliche Fehler der aktuellen Modelle: es reicht nicht Millionen Texte zu lesen, man muss den Inhalt auch wirklich verstehen. Das kennt jeder aus der Schule: Es gab einige, die konnten sehr gut auswendig lernen. Das funktioniert bei lieblosen Abfrage-Arbeiten. Sobald aber Wissenstransfer gefragt war, sind sie gescheitert. Und genau dieses Problem haben die LLMs. Daher gehen viele KI-Forscher auch davon aus, dass der derzeitige Ansatz eine Sackgasse ist und neue Methoden gefunden werden müssen.