Google erklärt HDR-Fotobearbeitung mit maschinellem Lernen

Google erklärt in einem Beitrag (technisch, aber lesenswert), wie man in Google Fotos nun auch aufwendige Bildbearbeitungen durchführen kann, ohne dass die Ultra-HDR-Qualität der Fotos (aufgenommen mit dem Pixel 8 oder höher) darunter leidet (Android 14 unterstützt die Anzeige von Ultra HDR).

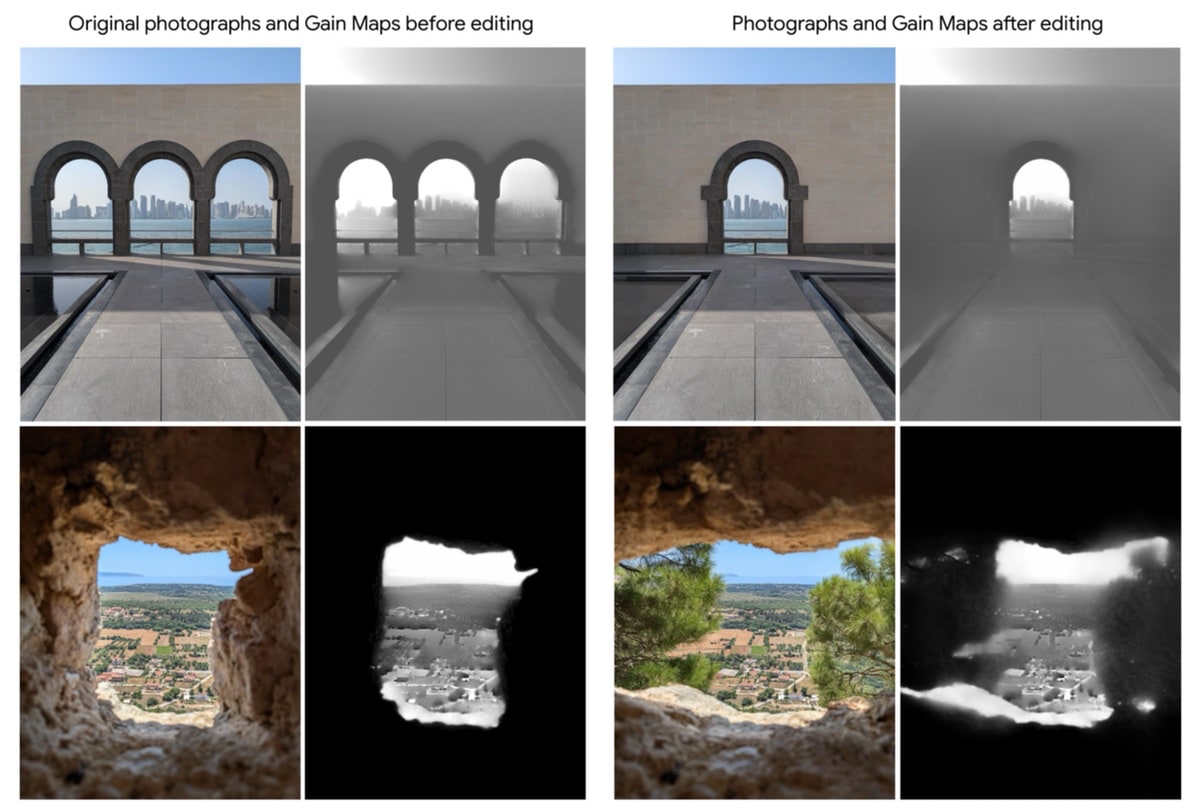

Dank maschinellem Lernen (ML) kann Google Fotos jetzt auch komplexe Bearbeitungen an HDR-Bildern vornehmen, ohne die HDR-Qualität zu verlieren. Auf dem Pixel 8 und neueren Geräten sorgt ein ML-Modell im Hintergrund dafür, dass eure bearbeiteten Bilder HDR bleiben. Dieses Modell wurde mit vielen HDR-Bildern trainiert und kann die fehlenden HDR-Metadaten nach der Bearbeitung vorhersagen, sodass Bilder weiterhin brillant aussehen. Wer ein paar Beispiele braucht, schaut sich die Galerie mit den Fotos aus dem Beitrag auf einem HDR-Gerät an.

Grundlegende HDR-Bildbearbeitungen wie „Zuschneiden“ und „Drehen“ haben einfache Gain-Map-Bearbeitungsimplementierungen, die bereits Teil von Google Fotos sind (Gain Maps werden von Adobe hier erklärt). Der Editor von Google Fotos enthält jedoch viele weitere Bearbeitungsfunktionen, die komplex sind und häufig auf ML und rechnergestützter Fotografie basieren, darunter Magic Eraser, Photo Unblur, Magic Editor, Portrait Blur und Motion Photos. Wie man die Gain Map bei Verwendung dieser Tools am besten bearbeitet, ist nicht eindeutig, da diese Funktionen für SDR-Bilder entwickelt wurden und die Modelle SDR-Bilder als Eingaben erwarten und SDR-Bilder als Ausgabe erzeugen.

Google Fotos hat dieses Problem mit einem neuen ML-Modell gelöst, das die fehlenden Bereiche der Gain Map rekonstruiert, indem es eine neue Map vorhersagt und mit der Originalen mischt.

„Wir haben viele Fotos mit der HDR+-Burst-Fotografie-Pipeline aufgenommen und die Algorithmen zur Dynamikumfangskompression der aktuellen Pixel-Kamera angewendet, um SDR- und HDR-Bildpaare zu erzeugen. Mit diesen Daten und einem Datensatz zufälliger Maskenformen haben wir ein leichtes Bild-zu-Bild-Übersetzungsmodell trainiert, das die Gain Map basierend auf dem bearbeiteten SDR-Bild und einer maskierten Version der ursprünglichen Gain Map vorhersagt. Es ist sogar flexibel genug, um eine Gain Map nur anhand eines SDR-Bildes als Eingabe zu erzeugen — optimiert für die Darstellung auf HDR-Displays.“

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen. Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte - gerne auch mit Humor. In jedes Thema Politik einbringen ist nicht erwünscht. Es besteht kein Recht auf die Veröffentlichung eines Kommentars.

Du willst nichts verpassen?

Du hast die Möglichkeit, den Kommentar-Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den Hauptfeed abonnieren.