Claude von Anthropic: Opt-out für Nutzung von Gesprächsdaten zum KI-Training

Wenn ihr den KI-Assistenten Claude von Anthropic nutzt, solltet ihr in den nächsten Tagen einen genauen Blick auf eure Einstellungen werfen. Das Unternehmen hinter dem Sprachmodell hat seine Nutzungsbedingungen angepasst und möchte künftig eure Gesprächs- und Codedaten für das Training der eigenen KI-Modelle nutzen. Das Ganze ist als Opt-out-System gestaltet – wenn ihr also nicht aktiv widersprecht, stimmt ihr automatisch zu.

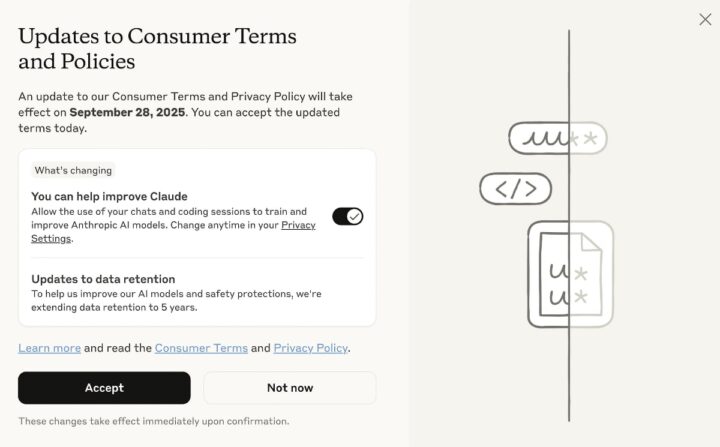

Die Änderung sieht vor, dass alle neuen Chats und Programmiersitzungen sowie fortgeführte ältere Konversationen von Anthropic analysiert und gespeichert werden dürfen, und das für einen Zeitraum von bis zu fünf Jahren. Umgesetzt wird dies durch eine Einblendung, die euch über die neuen Richtlinien informiert. Der Haken dabei: Während ein großer Button zur Zustimmung einlädt, ist die eigentliche Option zur Datennutzung ein kleinerer, standardmäßig aktivierter Schalter. Es ist also davon auszugehen, dass viele von euch der Datennutzung zustimmen, ohne es bewusst zu entscheiden. Ihr habt bis zum 28. September Zeit, eine Entscheidung zu treffen.

Wichtig für euch ist die Abgrenzung: Die Änderung betrifft euch, wenn ihr Claude in den Tarifen Free, Pro oder Max verwendet. Wenn ihr Claude hingegen im geschäftlichen Umfeld nutzt – etwa über die Tarife Claude for Work, Gov oder über API-Schnittstellen von Partnern wie Google Cloud – seid ihr von dieser neuen Regelung zur Datenerfassung für Trainingszwecke ausgenommen.

Wenn ihr nicht möchtet, dass eure Eingaben zum Training der KI beitragen, könnt ihr aktiv werden:

- Im Pop-up-Fenster: Deaktiviert den Schalter bei der Option zur Verbesserung von Claude, bevor ihr die neuen Bedingungen akzeptiert.

- Nachträglich in den Einstellungen: Falls ihr bereits zugestimmt habt, könnt ihr eure Entscheidung jederzeit korrigieren. Navigiert dazu in eurem Konto zu Settings > Privacy > Privacy Settings und schaltet die Option „Help improve Claude“ aus.

Diese Einstellung gilt allerdings nur für die Zukunft. Daten, die bis zu diesem Zeitpunkt bereits erfasst wurden, können nicht aus den Trainingsdatensätzen entfernt werden. Laut Anthropic werden zwar Maßnahmen ergriffen, um sensible Informationen zu filtern, und die Daten werden nicht an Dritte verkauft. Am Ende des Tages bleibt es aber eine Abwägung, die ihr für euch selbst treffen müsst.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen. Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte - gerne auch mit Humor. In jedes Thema Politik einbringen ist nicht erwünscht. Es besteht kein Recht auf die Veröffentlichung eines Kommentars.

Du willst nichts verpassen?

Du hast die Möglichkeit, den Kommentar-Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den Hauptfeed abonnieren.