ChatGPT entwickelt sich weiter, OpenAI setzt auf Nutzen statt Screentime

OpenAI hat heute neue Details zur Entwicklungsstrategie von ChatGPT veröffentlicht. Der KI-Spezialist verfolgt dabei einen interessanten Ansatz: Statt die Nutzer möglichst lange an den Bildschirm zu fesseln, steht der praktische Nutzen im Vordergrund. Die Entwickler messen den Erfolg angeblich nicht an der Verweildauer oder Klickzahlen. Vielmehr zählt, ob Nutzer ihre Aufgaben effizient erledigen können. Das zeigt sich auch an neuen Funktionen wie dem ChatGPT Agent, der Termine vereinbart oder E-Mails zusammenfasst, ohne dass man die App öffnen muss.

Nach einem Update Anfang des Jahres war ChatGPT zeitweise zu höflich und gab eher angenehme als hilfreiche Antworten. OpenAI hat darauf reagiert und misst nun verstärkt den langfristigen Nutzen statt kurzfristiger Zufriedenheit. Um die Qualität zu verbessern, arbeitet OpenAI mit 90 Medizinern aus 30 Ländern zusammen. Eine neue Expertengruppe aus den Bereichen psychische Gesundheit, Jugendentwicklung und KI-Forschung soll die Entwicklung begleiten.

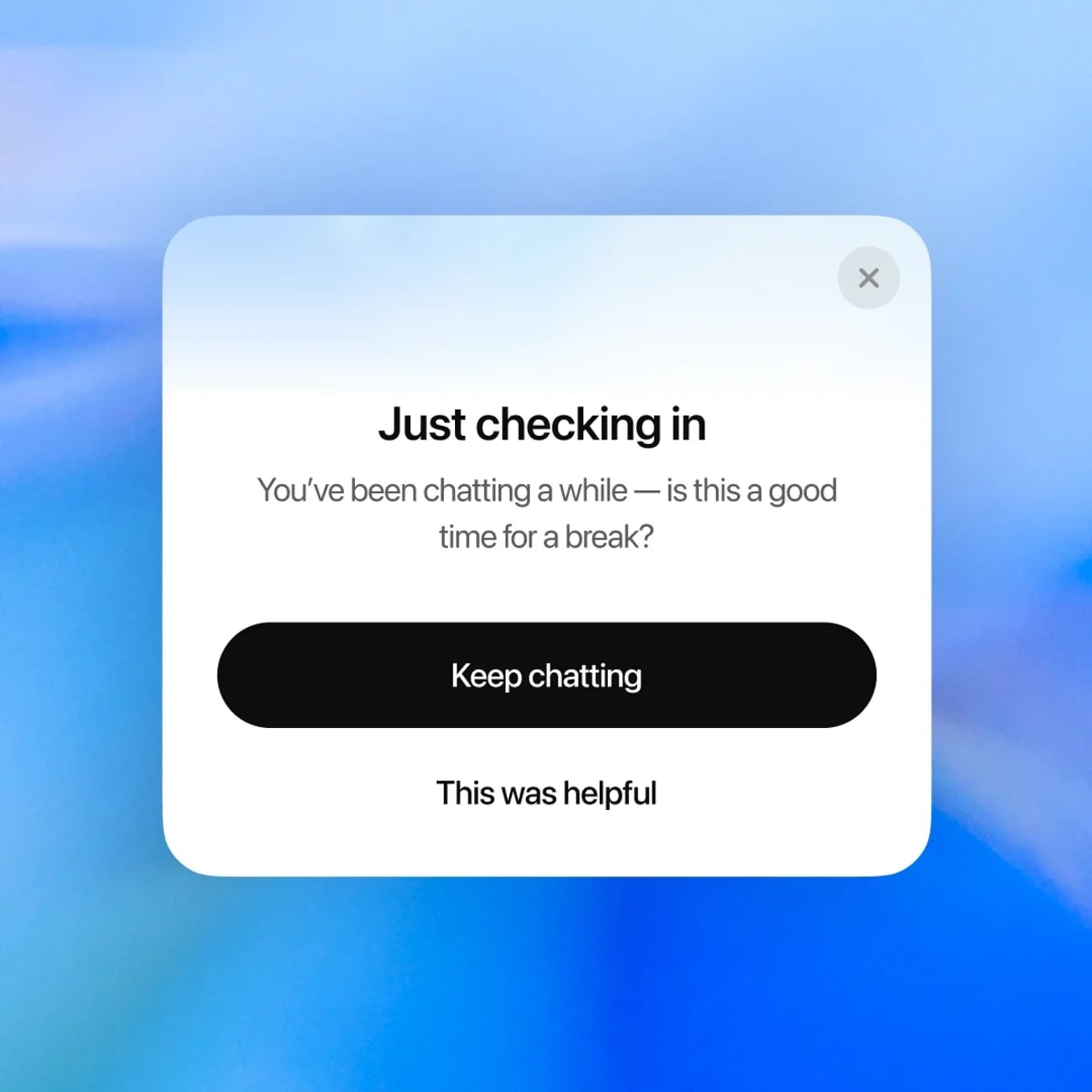

Konkret gibt es drei neue Funktionen: ChatGPT erkennt nun besser, wenn Nutzer psychisch belastet sind und verweist sie an Hilfsangebote. Bei langen Sitzungen erscheinen Hinweise für Pausen. Bei persönlichen Entscheidungen (Soll ich mich von meiner Frau scheiden lassen?) gibt das System keine direkten Ratschläge mehr, sondern unterstützt beim Abwägen.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Wer ChatGPT für persönliche Entscheidungen wie bspw. Trennung fragen muss, hat ganz andere Probleme als die Antworten von ChatGPT.

Generische KI ist heutzutage durchaus in der Lage, in diversen Lebenssituationen Ratschläge zu geben und Menschen durch schwierige Phasen zu helfen. Und das nicht nur, weil Menschen trotz oder wegen der Vernetzung immer weiter vereinsamen, sondern weil die Empathie der KI oftmals weit über der eines Menschen liegt – wie du gerade unfreiwillig aber nicht weniger eindrucksvoll unter Beweis gestellt hast.

Ich denke es ist eine Sache, wenn man andere Menschen nicht versteht und sich nicht in sie hineinversetzen kann. Diese Fähigkeit haben einfach nicht alle und manchmal muss man etwas auch selbst erlebt haben, um es wirklich zu begreifen.

Aber wenn man anfängt andere aus purer Arroganz heraus zu verurteilen, nur weil man selbst anders empfindet, es nicht versteht oder womöglich einfach ein gefühlskalter Soziopath ist, DANN stimme ich dir zu, dann hat man ganz andere Probleme als die Antworten von ChatGPT.

Schöne Antwort, +1.

Nur „generische KI“ müsste „generative KI“ heissen, da „allgemein, nicht spezifisch“ != „erzeugend“ 😉

Damit hast du natürlich vollkommen recht Da habe ich zur späten Stunde wohl etwas durcheinander gebracht.

Sehr gute Antwort, danke

Nur weil etwas aussieht wie Empathie ist es das nicht. Ansonsten hätte die KI auch eine psychische Störung und gehörte in Psychotherapie wegen ihres Realitätsverlustes und ihres wahnhaften Lügens.

Das wirkt unangemessen? Klar, das ist es – genauso wie das Wort Empathie für KI. Hier geht es um Empathie-Simulation.

Damit magst du nicht falsch liegen, aber wir müssen uns an dieser Stelle nicht um den Terminus kümmern, weil er nichts zur Sache tut.

Ob simuliert oder echt: wenn das gewünschte Ergebnis erzielt wird, spielt es keine Rolle mehr. Wenn dich dein Freund, der echte Mensch, seine Empathie nur vorspielt, du das aber nicht merkst oder dich vielleicht trotzdem besser fühlst, spielt es für dich auch keine entscheidende Rolle.

Der Zweck heiligt eben nicht die Mittel. Und es macht durchaus einen Unterschied, ob man Empathie simuliert oder tatsächlich jemanden versteht. Gerade in der Interaktion. Das weiß man z.B. gut aus der Forschung zu psychoaotialen Problemen

Wer eine Maschine zur intermenschlichen Kommunikation benötigt, der braucht definitiv Hilfe und das nicht von einer Maschine, sondern von Menschen! Wer das nicht erkennt und gar mit dem Vorwurf con Arroganz kommt, der braucht ebenfalls Hilfe (von Menschen!).

Wer andere pauschal abwertet, weil sie Hilfe bei einer KI suchen, stellt sich über sie. Genau das ist die Definition von Arroganz.

Vielleicht wäre es gerade für dich hilfreich, ChatGPT einmal zu fragen, warum deine Beiträge als herablassend oder arrogant wahrgenommen werden. Die Antwort könnte überraschend ehrlich ausfallen

Es gibt einen Teil der Menschheit, der zur Empathie nicht (mehr) fähig ist – in unterschiedlicher Ausprägung und mit unterschiedlichen Konsequenzen. Ca. 15-20% leiden unter einer stark eingeschränkten Empathie (und oft dauerhaften Verlust dieser). Weitere 30-40% sind je nach Situation (Stress, Gruppenzwang, ideologische Einschränkungen usw….) reduziert Empathiefähig. Die Chance, je nach Situation zur zwischenmenschlichen Kommunikation einen geeigneten Ansprechpartner zu finden liegt also bestenfalls bei 2:1, eher 1:1. Warum du daher immer einen realen Gesprächspartner einem Algorithmus, der eine deutlich bessere Trefferquote haben dürfte, vorziehst, würde mich mal interessieren. Und ja, Selbstüberschätzung ist ein Merkmal von Arroganz…

Super, dieses Umdenken ist wichtig. Assistant Ki muss anders bewertet werden.

Allein evtl höhere Betriebskosten durch zb unnötige Feedbackschleifen die nur dazu dienen irgendwelche Shareholder KPIs zu treiben. Das wird umso wichtiger wenn die KI lokal auf dem Handy läuft und am Akku nuckelt.

es geht dabei nur Ums Geld. Jede Anfrage, die ein Nutzer stellt, kostet ChatGPT Geld und da sie kann eine Gebühren nehmen. Zahlen Sie drauf. D.h. möglichst effizient zu sein ist in direkten wirtschaftlichen Interesse von Chat GPT. Noch.

Sind hier ernsthaft so krasse Techbros in den Kommentaren, die einer KI, einem statistischem Papagei, Empathie attestieren?

Geh mal raus an die frische Luft, fass mal Gras an und setze dich danach mal mit der technischen Grundlage von LLMs auseinander.. Meine Güte.

Ich empfehle Dir dringend Dich wenigstens mit den Grundlagen zu beschäftigen wie eine solche KI funktioniert bevor Du eine Meinung auf die Welt loslässt.