„Lookout“: App von Google soll Blinde unterstützen

Google hat mit „Lookout“ eine neue App vorgestellt, welche Blinden helfen soll sich in der Umgebung zurechtzufinden. Denn das wird speziell in vielen Büroumgebungen, die heute deutlich öfter regelmäßigen Veränderungen unterworfen sind als früher, immer schwieriger. „Lookout“ soll noch 2018 seinen Einstand im offiziellen Play Store geben. Leider ist die Anwendung bisher aber nur für die USA bestätigt.

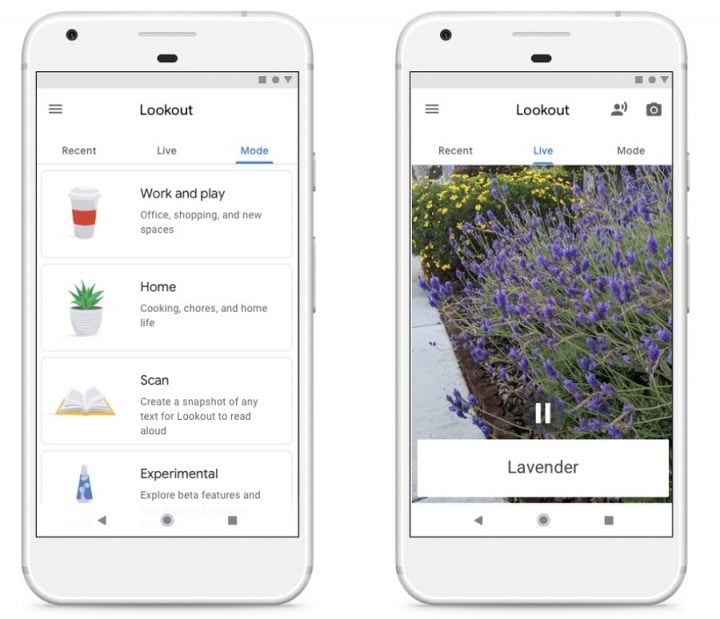

„Lookout“ funktioniert auf folgende Weise: Man trägt sein Pixel-Gerät z. B. um den Hals oder lässt es aus einer Brusttasche hervorlugen. Wichtig ist in jedem Fall, dass die Kamera vom Körper wegzeigt. Die geöffnete App kann über verschiedene Modi die Umgebung erfassen. Anschließend kann sie passende Audio-Informationen ausgeben. Etwa kann das ein Hinweis auf einen Wegweiser zum WC sein, das Vorlesen eines Kochrezepts oder auch Anmerkungen zu einem umgestellten Stuhl oder einer Person im Weg.

Vier Modi soll „Lookout“ Blinden anbieten: „Home“, „Work & Play“, „Scan“ und „Experimental“. Je nach aktiviertem Modus wählt „Lookout“ andere Informationen zur Übermittlung aus. Zuhause erfolgen etwa Hinweise auf die Couch, den Geschirrspüler oder auch den Wohnzimmertisch. Auf der Arbeit etwa achtet die App dann eher auf Dinge wie den Fahrstuhl oder eine Treppe. Dank Machine Learning will man die App fortwährend verbessern, um herauszufinden, zu welchen Objekten sich Blinde Hinweise wünschen bzw. in welcher Frequentierung sie angemessen sind.

Laut Google werde das Gros der Daten direkt auf dem jeweiligen Gerät verarbeitet. Eine Internetverbindung ist für „Lookout“ also nicht zwangsweise notwendig. Die Idee klingt auf jeden Fall gut, denn Apps für Blinde sind nicht unbedingt verbreitet wie Sand am Meer. Bleibt zu hoffen, dass Google „Lookout“ am Ende auch außerhalb der USA anbietet.

zum glück benötige ich eine solche app nicht, aber für alle betroffenen ist sie (mehr als) gold wert. die großen it firmen sollten in dem bereich ruhig noch mehr investieren. als chef von google oder apple würde ich das schon aus purem eigennutz vorantreiben. wer weiß denn schon, ob man nicht irgendwann auch auf derartige software angewiesen ist? wenn der tag tatsächlich kommt, dann will man ja sofort hilfe haben und nicht erst jahre auf eine brauchbare lösung warten. und vieles aus der entwicklung derartiger lösungen wird man ja auch für andere bereiche furchtbar machen können.

man kann nur hoffen, dass google nicht wie schon bei unzähligen anderen (großartigen) projekten nach kurzer zeit die lust verliert und die app im betastadium vermodern lässt oder gleich das ganze projekt wieder einstellt.

Das war für mich als jemanden der selbst blind ist mit Abstand die interessanteste Neuigkeit von der IO bis jetzt. Vor allem freut mich, daß darauf hingewiesen wird, daß Daten soweit möglich lokal verarbeitet werden, üblicherweise pumpt Google ja eher alle Daten deren sie habhaft werden au fihre Server, unabhängig davon, ob das für die jeweilige Funktion technisch notwendig ist oder nicht.

Von Microsoft gibt es mit SeeingAI eine ähnliche App, bislang leider nur für IOS, eine Version für Android ist scheinbar zumindest angedacht, mit Informationen dazu hält man sich allerdings bedeckt. Ich bin mal gespannt, wer von beiden schneller mit einer Android-Version ist, die vor allem auch in Deutschland verfügbar ist.