KI-Agenten für Windows: Microsoft will für mehr Sicherheit sorgen

Je mehr künstliche Intelligenz in Unternehmen und privaten Haushalten eine Rolle spielt, desto wichtiger wird auch die Sicherheit. Schließlich wird das Missbrauchsrisiko immer höher, je mehr Daten ihr mit der KI teilt. Laut Microsoft arbeite man deswegen auf Hochtouren an entsprechenden Verbesserungen. Beispielsweise erklärt der Hersteller, wie man seine Copilot Actions absichert.

Copilot Actions ist eine noch experimentelle Funktion, die es Copilot erlaubt, nicht nur als Chatbot zu dienen, sondern eben auch in eurem Namen Handlungen (Actions) im Web auszuführen – beispielsweise einen Tisch in einem Restaurant zu reservieren. Und im experimentellen Modus kann Copilot nicht nur das, sondern auch mit lokalen Dateien und anderen Apps interagieren. Copilot soll dadurch noch produktiver werden und für euch z. B. E-Mails beantworten, Dokumente aktualisieren, Dateien ordnen und mehr.

So eine mächtige Funktionalität birgt natürlich erhöhte Sicherheitsrisiken, etwa durch Techniken wie „Cross-Prompt-Injection“. Dabei werden schädliche Inhalte in UI-Elemente oder Dokumente eingeschleust, um der KI neue Befehle zu geben, Daten abzusaugen und / oder Malware zu installieren. Microsoft will dem z. B. dadurch vorbauen, dass man in Windows den KI-Agenten quasi eigene Konten zuweist, die im Hintergrund von eurem Nutzerkonto getrennt laufen. Auf diese Weise kann man zudem auch die Rechte eines KI-Agenten einschränken und euch erlauben je nach Situation Freigaben zu erteilen oder zu entziehen.

Copilot Actions soll für alle Nutzer sicher sein

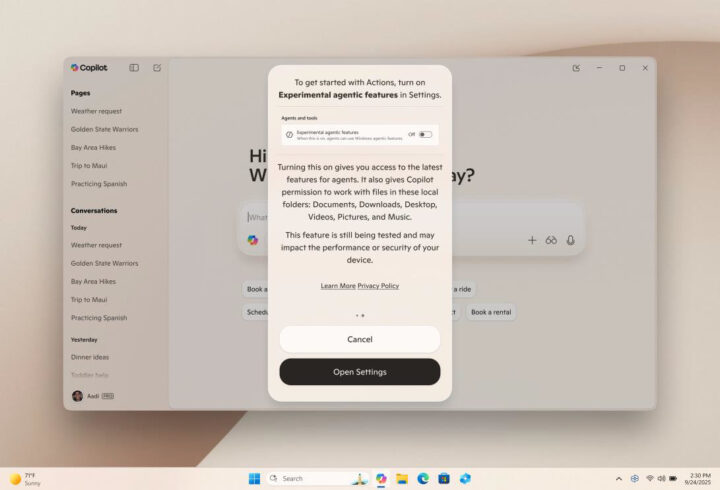

Zusätzlich müssen KI-Agenten von einer vertrauenswürdigen Quelle signiert sein, sonst können sie automatisch blockiert werden. Laut Microsoft werde man aber z. B. in der Preview-Phase der Copilot Actions unter Windows 11 nach und nach mehr granulare Sicherheitsmechanismen einarbeiten. Zum breiteren Start sollen dann also bereits viele Konfigurationsoptionen vorhanden sein. Obendrein sind die Copilot Actions aus Sicherheitsgründen als Standard deaktiviert und müssen erst vom Nutzer angeknipst werden.

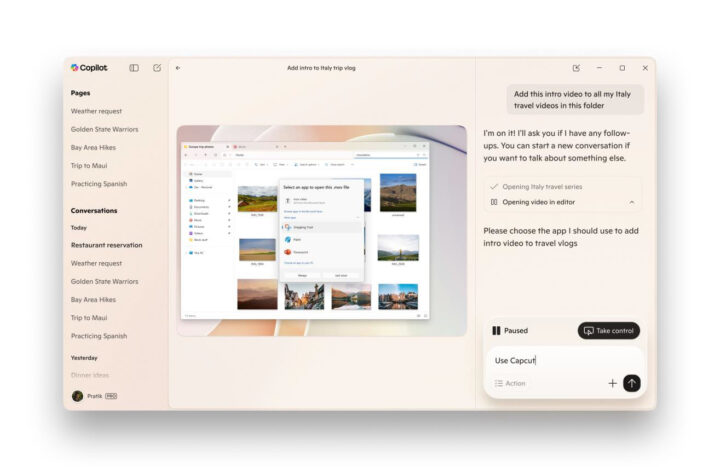

Microsoft spricht auch von abgegrenzten Agent-Workspaces. Das solltet ihr euch so vorstellen, dass eure KI-Agenten quasi einen eigenen Desktop mit speziellen Freigaben und Beschränkungen erhalten, sodass sie auch nicht auf all eure Daten und Apps Zugriff haben bzw. eure Aktivitäten nicht permanent überwachen können. Apps und Aktionen, die Copilot Actions dann ausführt, laufen nicht unter eurem Benutzerkonto, sondern dem spezifischen Konto des KI-Agenten.

In der experimentellen Vorschau / Preview der Copilot Actions wird die KI aus Sicherheitsgründen nur auf wenige, lokale Standardordner Zugriff erhalten – wie die Dokumente, Downloads, Bilder und den Desktop. Weitere Freigaben müsst ihr gezielt manuell erteilen. Ihr könnt zudem laut Microsoft jederzeit die Fortschritte der Copilot Actions überwachen, Schritte nachvollziehen und jederzeit einschreiten. Sollen sensible Aktionen vollführt werden, kann es zudem sein, dass Copilot kurz bei euch nachfragt, ob Schritt XY wirklich ausgeführt werden soll.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

„Sollen sensible Aktionen vollführt werden, kann es zudem sein, dass Copilot kurz bei euch nachfragt, ob Schritt XY wirklich ausgeführt werden soll.“

auch wenn es dann vielleicht nervt jedes mal das zu bestätigen sollte das meiner Meinung nach immer so sein. Evtl. kann sowas „Cross-Prompt-Injection“ vorbeugen. (sorry wenn das verkehrt ist)