Jan: KI-App für mehr Privatsphäre auf dem eigenen Rechner

Wer KI-Chatbots nutzen möchte, aber Bedenken beim Datenschutz hat, findet mit Jan eine interessante Alternative. Die kostenlose Open-Source-Software ermöglicht es, große Sprachmodelle direkt auf dem eigenen Computer laufen zu lassen, ganz ohne Internetverbindung.

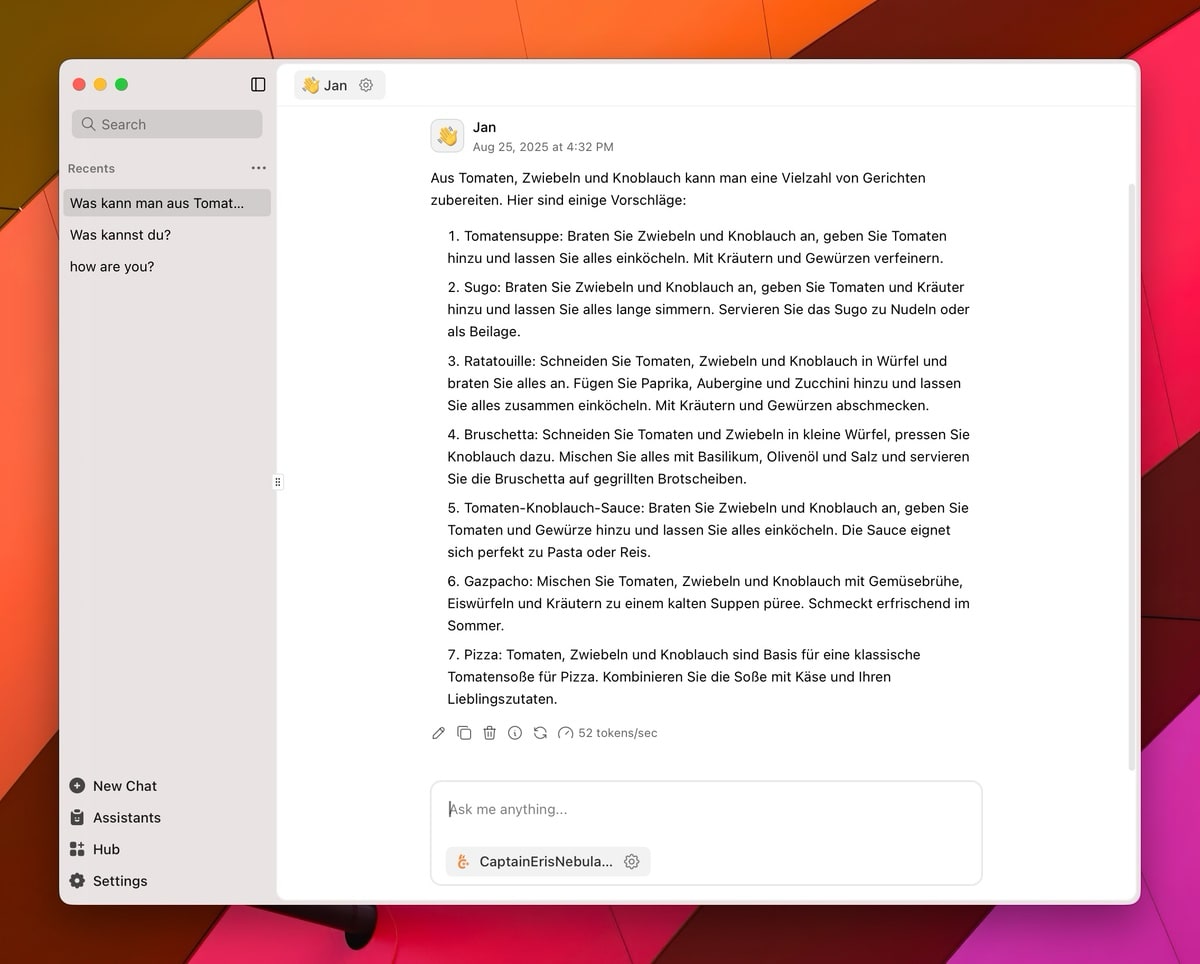

Nach der Installation von Jan für Windows, macOS oder Linux steht zunächst die Auswahl eines Sprachmodells an. Für den Einstieg bietet sich vielleicht eines der Mistral-Modelle an, die sich über den integrierten Modell-Store herunterladen lässt. Die Nutzung gestaltet sich dann ähnlich wie bei ChatGPT oder Google Gemini.

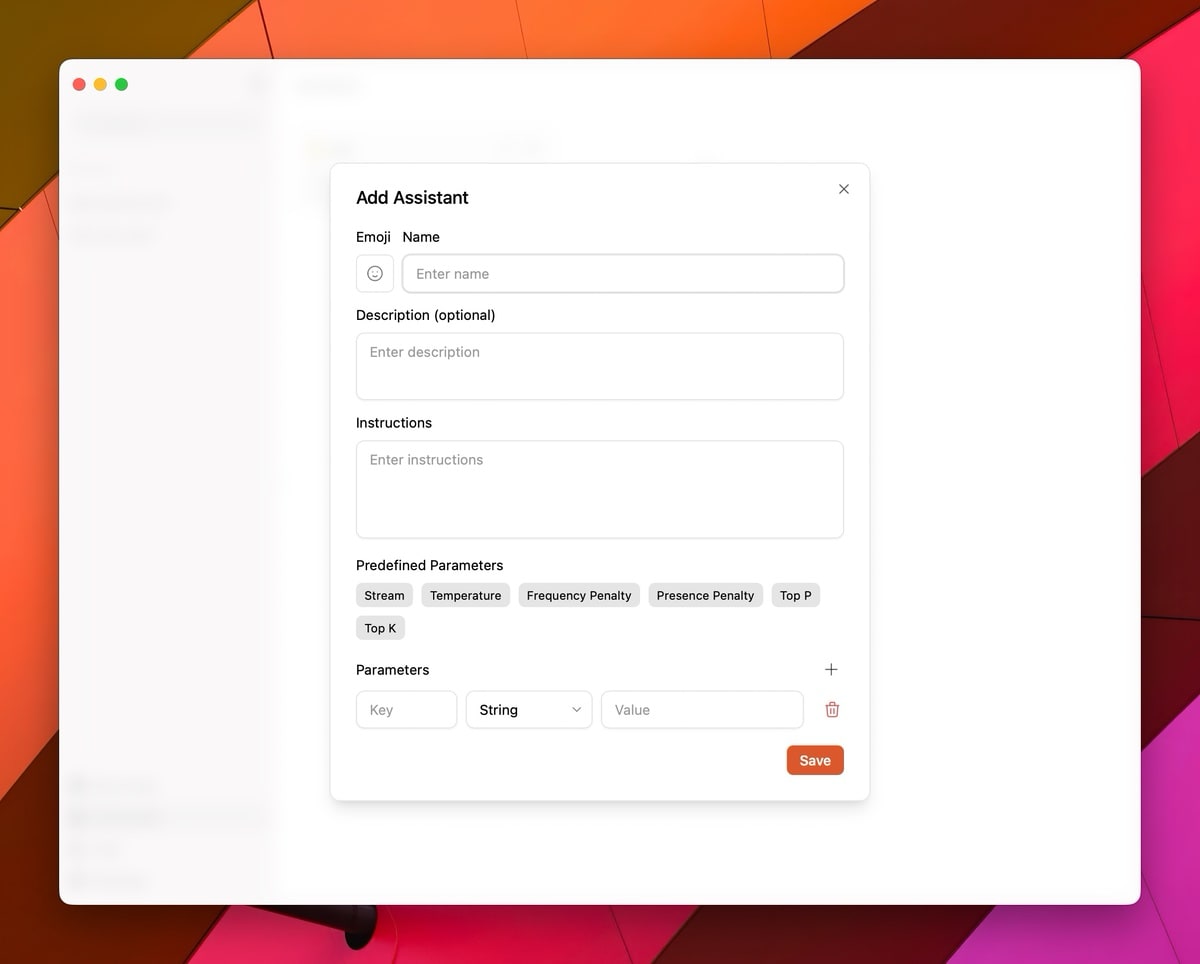

Im rechten Bereich der Benutzeroberfläche lassen sich grundlegende Anweisungen für den Chatbot festlegen. Die Standard-Einstellung „you are a helpful assistant“ kann dabei nach Belieben angepasst werden. Die Qualität der Antworten hängt vom gewählten Modell und der Rechenleistung des Computers ab. Zwar erreichen die lokalen Modelle nicht das Niveau der neuesten Online-Dienste, dafür bleiben die Daten aber auf dem eigenen Rechner.

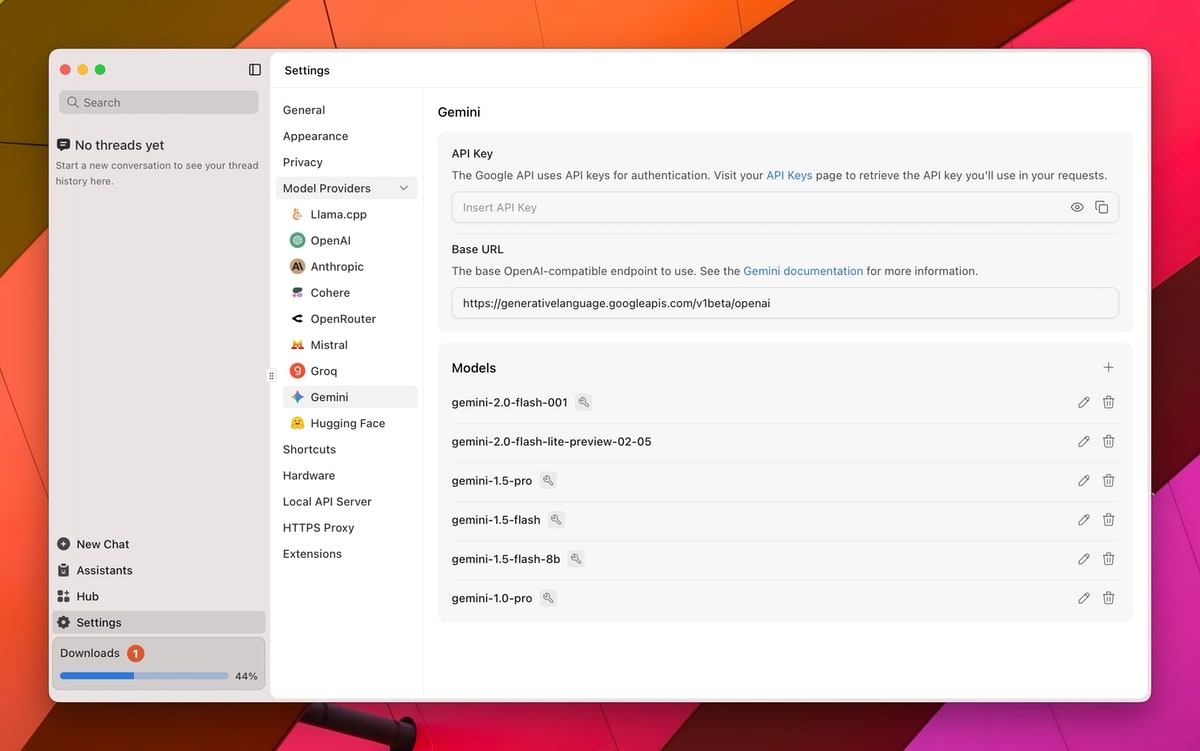

Ein zusätzlicher Pluspunkt: Jan stellt eine API-Schnittstelle bereit, die u. a. mit der OpenAI-API kompatibel ist. Das ermöglicht die Nutzung von Jan in Anwendungen, die Schnittstellen zu den jeweiligen Diensten unterstützen. Die verschiedenen Sprachmodelle sind für unterschiedliche Anwendungsfälle optimiert. Einige eignen sich für Programmier-Fragen, andere wurden für Computer mit weniger Rechenleistung angepasst.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

sieht schick aus, aber sind da auch gute Tools dabei? Auf den Screenshots sieht man keine Websuche Funktion, in den Docs 2 Provider, bei denen man einen Account hinzufügen muss. Bei Witsy (ziemlich das gleiche, wie Jan) kann man die on device Suche machen + Deep Research lokal und bei Open-Webui z.B. eine SearxNG Instanz nutzen.

Soweit ich mich erinnere konnte man bei Jan die Modelle aus einer art Marktplatz auswählen und dann komplett lokal installieren. Witsy sieht eher nach einer UI für AI aus, die allerdings für jeden Service einen API-Key benötigt – ähnlich wie LibreChat.

Witsy kann auch lokal ollama und lm studio bzw. jede OpenAI kompatible Lösung. LM Studio & Ollama haben auch Downloader. Ich hab jetzt nicht nachgelesen, aber Jan sollte ja dann wahrscheinlich llama.cpp shippen und eben anstatt Ollama, den eigenen Service nutzt. Also Witsy für Desktop braucht an sich keine API-Keys, man kann die aber, wie auch bei Jan, einpflegen, um deren Modelle nutzen zu können.

Jetzt bin ich die erste Person, die offiziell von einer KI ersetzt wurde ☹️

War das nicht Claude?

Der war nur geclaude

Fragt mich mal. Ich bin nicht so stolz auf meinen Schöpfer.

Was ist hier der Vorteil gegen bspw. LM-Studio oder Ollama?

Würde mich mal interessieren: wie viele Leute haben einen Rechner daheim, auf dem man neben dem ganzen anderen Kram noch sinnvoll ein brauchbares LLM laufen lassen kann?

Ich hab mal ein paar Versuche mit Ollama gemacht und da tritt auf meinem Rechner ganz schnell Ernüchterung ein. Weit komme ich mit meinem Rechner nicht.

also mit meiner 4080 Super und der 3090 komme ich ganz gut zurecht. Geht halt nur 20B, 120B sollte man nicht probieren. Es gibt etliche Modellvarianten, die nur 4GB VRAM benötigen, mehr ist aber besser. Sollte eine Nvidia Karte sein, da fast alles auf Cuda optimiert ist.

Ich nutze lokale KI sogar auf meinem Laptop mit integrierter Grafik (Radeon 780M) und 32 GB RAM. Sowas wie Qwen 30B A3B 2507 läuft da mit Anfangs 30 T/s ziemlich flott, da nur 3B aktiv sind und die Qualität der Antworten ist auch ziemlich gut.

Natürlich belegt das dann aber einen Großteil des Arbeitsspeichers, also ich könnte da nicht nebenbei z. B. groß Programmieren oder VMs laufen lassen.

Aber auch die kleinere Modelle wie z. B. Qwen 3 4B 2507 sind mittlerweile ganz gut geworden und belegen nur einen kleinen Teil des Arbeitsspeichers.

Also auf aktuellen Macs mit 16GB RAM oder mehr lässt sich das bei mir schon brauchbar nutzen. Nur hab ich noch nicht so gute Modelle gefunden die ich lokal laufen lassen kann welche die Qualität von chatgpt erreicht.

naja, man kann chatten. brauchbar ist es nicht. dafür ist die kontextlänge einfach zu kurz. eine pdf einlesen und das modell kann sich drei zitatsfetzen merken. das ist quatsch. angeblich haben leute qwen coder 30b mit 32gb ram (?) sinnvoll am laufen. vielleicht mache ich also was falsch.

„große Sprachmodelle direkt auf dem eigenen Computer …, ganz ohne Internetverbindung.“

Aber das ist dann nur die „Maschine“, ganz ohne Daten, oder? Die werden dann online über Google o. ä. abgefragt?

Hiermit hostest du die KI selbst. Fürs Training war die jeweilige Firma natürlich involviert, aber fürs ausführen („Inferenz“) brauchst du nur einen Rechner der mächtig genug ist. Entweder deinen eigenen (z.B. mit Jan) oder du greifst auf ein Angebot im Internet / der Cloud zurück.

Läuft auf dem lokalen Rechner aber verlangt die Datenkrake Edge Webview! Weg mit dem Dreck.