HDMI 2.2: Neue Spezifikation bringt Ultra96 und massive Bandbreitensteigerung

Das HDMI Forum hat heute die neue HDMI-Spezifikation 2.2 final vorgestellt. Grundsätzlich hat sich nichts zur Vorstellung im Januar verändert. Die wichtigste Neuerung ist die deutlich gesteigerte Bandbreite von nun 96 GBit/s, die durch die neue HDMI Fixed Rate Link-Technologie ermöglicht wird. Diese Entwicklung ist besonders interessant für Enthusiasten, die auf höchste Auflösungen und Bildwiederholraten setzen.

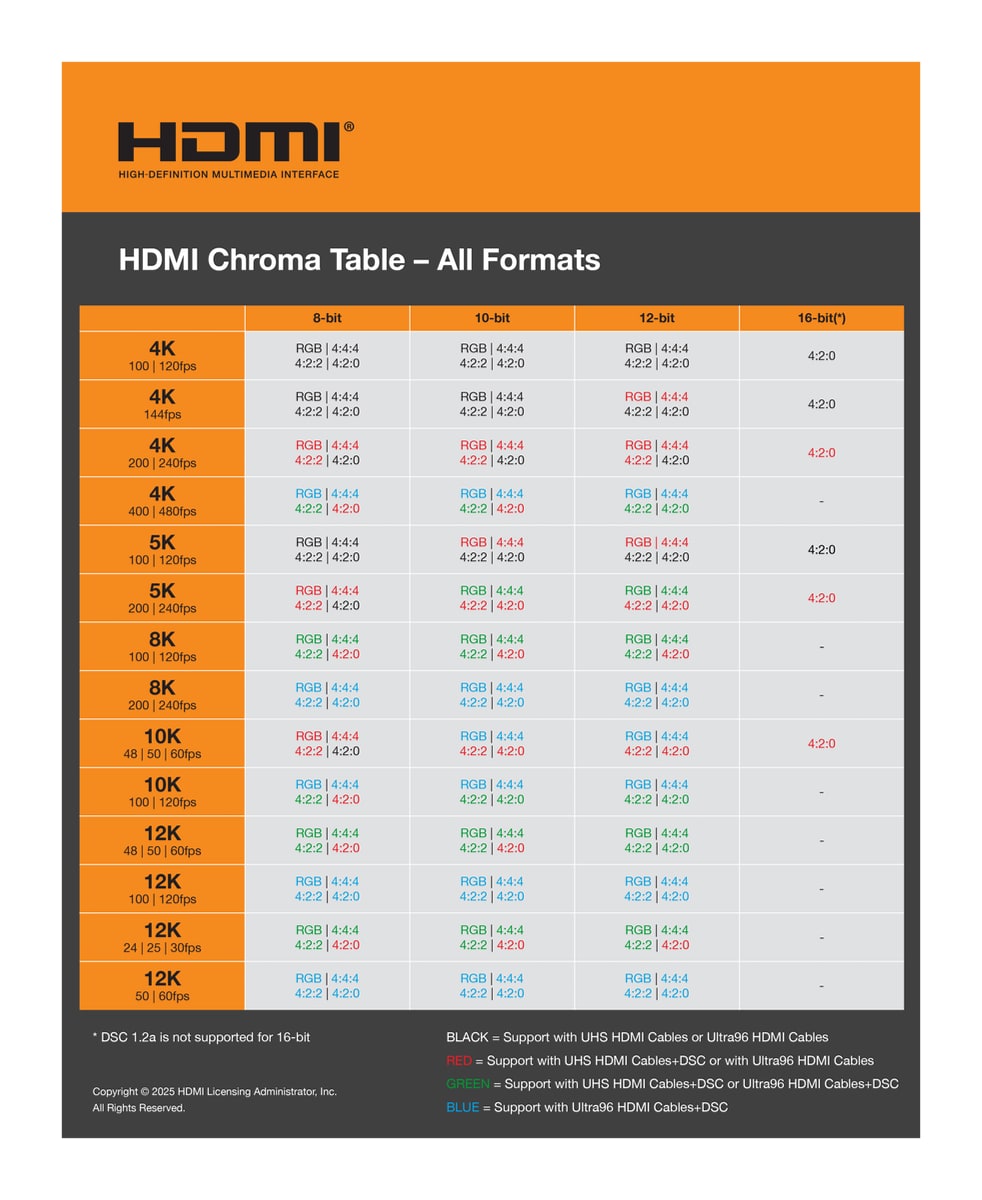

Mit der neuen Spezifikation werden Auflösungen bis zu 12K bei 120 Hz und sogar 16K bei 60 Hz möglich. Auch unkomprimierte Formate profitieren von der höheren Bandbreite: 8K-Inhalte können nun mit 60 Hz im 4:4:4-Format dargestellt werden, während 4K-Material mit beeindruckenden 240 Hz läuft – jeweils mit 10-Bit- oder 12-Bit-Farbtiefe.

Eine wichtige Neuerung für Verbraucher ist die Einführung der Ultra96-Bezeichnung. Dieser Funktionsname kennzeichnet Produkte, die Bandbreiten von 64 GBit/s, 80 GBit/s oder 96 GBit/s unterstützen. Für diese Geräte wird zwingend ein spezielles Ultra96 HDMI-Kabel benötigt. Die bisherigen Ultra High Speed HDMI-Kabel bleiben weiterhin für Systeme mit bis zu 48 GBit/s Bandbreite geeignet.

Wie auch die Vorgänger unterliegen die neuen Ultra96-Kabel einem Zertifizierungsprozess. Jede Kabellänge muss einzeln getestet und zertifiziert werden und erhält ein entsprechendes Zertifizierungslabel. Zusätzlich führt das HDMI Forum mit Version 2.2 das Latency Indication Protocol (LIP) ein. Dieses verbessert die Synchronisation zwischen Bild und Ton, was besonders bei komplexeren Setups mit AVR oder Soundbar von Vorteil ist.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Es ist Wahnsinn diese Datenmenge auf dem Stecker bzw dem Kabeltyp. Schon HDMI 2.1 ist wirklich sportlich. Ohne AOC (Umwandlungs auf Glasfaser) wird man da nicht weit kommen.

Wie lang sind denn die HDMI 2.2 Kabel für den Anfang? Auch nur 1m?

Wir sollen bis zu 3m als Kupfer Kabel bekommen. Hab aber noch keine Verbindlichen Daten gesehen und auch irgendwie keine Testoption im Büro oder zuhause.

Was mir wirklich fehlt ist eine Umsetzung von HDMI Cable Power, um Geräte wie bspw. einen Fire TV Stick dann tatsächlich ohne weitere Kabel betreiben direkt zu können, wie es auf den Werbebildern schon lange den Anschein hat.

Naja es ist doch Absicht, dass du an die Funzel Sticks eine extra Stromversorgung anschließen musst.

Schon heute schaffen es die gerate nicht mehr als zwei hdmi 2.1 Anschlüsse. Bleibt spannend wie die sich das mit 2.2 vorstellen

Ich frage mich ernsthaft, für wen das sein soll. Schon bei UHD ist der empfohlene Mindestabstand bei der 1,5-fachen Displayhöhe (gegenüber 3-fach bei Full HD). Bei einem Sitzabstand von 3 m, der in deutschen Wohnzimmern keine Seltenheit ist, wäre das ein Display mit 160 Zoll Diagonale, mit einem Fernseher unter 80 Zoll reicht Full HD, um keine einzelnen Pixel zu sehen. Oder andersrum: Bei einem weitaus üblicheren 65″-Fernseher ist dieser Sitzabstand bei 1,2 m; ab 2,4 m sieht man keinen Unterschied mehr im Vergleich zu Full HD, eine feinere Winkelauflösung gibt das menschliche Auge nicht her. Ich möchte die Leute sehen, die sich 1,2 m vor ihren Fernseher setzen, und dann kann man sich das Ganze ja nochmal für PC-Monitore, Notebook-Displays und Smartphones ausrechnen.

Mit UHD2 („8K“) halbiert sich dieser Sitzabstand nochmal. Ich weiß ja nicht, mit was für Ultraweitwinkellinsen in ihren Augen andere Menschen durch die Welt laufen, aber 60 cm vor einem 65″-Display sehe ich nur noch einen kleinen Bildausschnitt; schon 1,2 m ist grenzwertig, und weiter weg brauch ich wieder kein „8K“. Und dann fantasieren die Hersteller was von „12K“. Ich lach mich tot.

Noch lustiger ist, dass in der Tabelle selbst bei „12K“ immer noch 8-Bit-Unterstützung eingetragen ist, obwohl schon bei UHD alles unter 10 Bit nach Banding geradezu schreit, aber bizarrerweise gibt es ja auch Gaming-Monitore mit UHD-Auflösung, die nur 8 Bit können. Und dann noch diese Frameraten – wo sollen die herkommen? Es gibt kaum Videomaterial mit 100 Hz oder mehr; Grafikkarten sind gerade so weit, dass sie aktuelle Spiele in UHD stabil in spielbaren Frameraten (ab 60 fps) wiedergeben können, und mit Raytracing ist auch da ohne „KI“-Schummelei schon wieder Schicht im Schacht, selbiges gilt für Spielkonsolen. Sony hat nicht ohne Grund still und heimlich den „8K“-Aufdruck auf der Verpackung neuerer PS5-Lieferungen entfernt, das war von Anfang an eine Luftnummer.

Selbst 4:4:4 ist rein optisch für den Endverbraucher völlig irrelevant, soweit man von fertigem Videomaterial spricht. Ob Streaming oder Discs, der Verbrauchermarkt bekommt hier grundsätzlich nur 4:2:0, eben weil das menschliche Auge für Farbunterschiede unempfindlich genug ist, um nicht zu bemerken, dass nur jeder 2. bzw. jeder 4. Pixel eine Farbinformation hat. Relevant ist das nur für Computer, die unsere Sehschwäche nicht haben – nicht ohne Grund geht sauberes Keying und Compositing nur ohne Subsampling, aber das sind Baustellen, mit denen sich der typische Endverbraucher nicht beschäftigt. Echtes 4:4:4 gibt es nur bei dem, was der Computer generiert, zumal hier ohnehin durchweg mit RGB gearbeitet wird, aber wieder: Welche Games sollen denn in UHD mit 240 fps laufen? Pong? Tetris?

Das Ganze wird noch zweifelhafter, wenn man berücksichtigt, dass man für die Übertragung nochmal eine Kompression draufhauen muss, die zwar „visuell verlustfrei“ sein soll, aber die ohnehin schon de facto nicht vorhandenen Gewinne für das Seherlebnis nochmal runterdrückt, weil es wieder ein Energiefresser mehr ist, wo schon der Strombedarf aller Komponenten an sich mit steigender Auflösung exponentiell ansteigt.

Im Profibereich, wo es theoretisch durchaus Anwendungsfälle für derart hohe Auflösungen gibt (Spoiler: Kino ist es nicht, wieder wegen der Sitzabstände zur Leinwand), arbeitet niemand, der bei Verstand ist, mit HDMI, wenn es sich irgendwie vermeiden lässt, dafür ist diese Schnittstelle viel zu unzuverlässig und auch nicht geschaffen. Dort heißt der Standard (noch) HD-SDI, aber da man beim Koaxialkabel bereits ob solch hoher Datenraten an die Grenzen der Physik stößt, wird zunehmend mit Glasfaser gearbeitet. Wenn man da mit HDMI ankommt, wird man vom Hof gelacht. Und im PC-Bereich weiß man auch schon, warum man da auf den DisplayPort setzt.

Wir fassen zusammen: Die Endverbraucher brauchen den neuen HDMI-Standard nicht, die Profis sowieso nicht, das bringt mich zur Eingangsfrage zurück: Für wen ist er gedacht?

Für die Kasse der HDMI.ORG 🙂