Google macht „Gemini 2.5“-Familie komplett

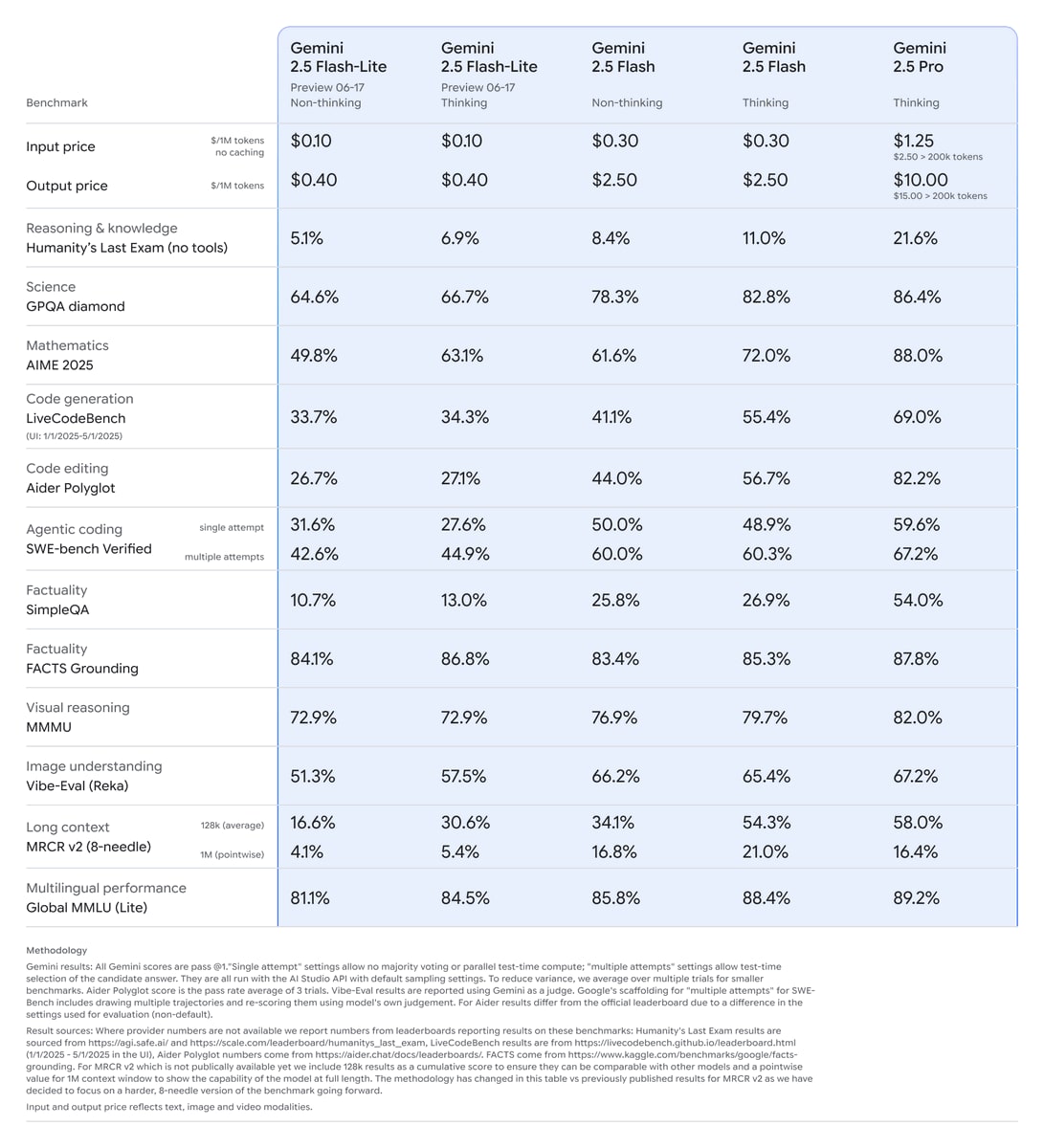

Google erweitert heute sein KI-Angebot und macht die „Gemini 2.5“-Familie komplett. Die bereits bekannten Modelle Gemini 2.5 Flash und Pro verlassen die Betaphase und sind ab sofort allgemein verfügbar. Das bedeutet für Entwickler grünes Licht für den Produktiveinsatz. Interessant ist aber vor allem die Neuvorstellung des Gemini 2.5 Flash-Lite, das als kostengünstigste und schnellste Variante der 2.5-Familie positioniert wird.

Die neue Flash-Lite-Variante befindet sich zunächst in der Preview-Phase, kann aber bereits jetzt von Entwicklern getestet werden. Google verspricht dabei deutliche Verbesserungen gegenüber dem Vorgänger 2.0 Flash-Lite, besonders in den Bereichen Programmierung, Mathematik, Wissenschaft und Multimodal-Aufgaben. Bemerkenswert ist die geringere Latenz im Vergleich zu den 2.0-Modellen, was sich besonders bei Übersetzungen und Klassifizierungen bemerkbar macht.

Technisch interessant ist die Beibehaltung aller wichtigen „Gemini 2.5“-Funktionen auch in der Lite-Variante. Dazu gehören die variable Steuerung der Denkprozesse, die Integration von Google Search, Code-Ausführung und die Verarbeitung verschiedener Eingabeformate. Der Kontextumfang bleibt mit einer Million Token beeindruckend groß.

Die praktische Verfügbarkeit ist bereits gegeben: Entwickler finden das neue Flash-Lite in Google AI Studio und Vertex AI, während die stabilen Versionen von Flash und Pro auch in der Gemini-App zur Verfügung stehen. Auch die Google Suche profitiert bereits von angepassten Versionen des Flash-Lite und Flash-Modells.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Laie hier! Ich nutze Gemini als Ersatz für die Google Suche, z. B. lasse ich mir den Zusammenbruch der UDSSR erklären. Ich nutze ChatGTP um Texte zu pimpen und Sora für Grußkarten und witzige Illustrationen, die meinem verwirrten Verstand entspringen.

Aber offensichtlich überblicke ich das Thema nicht in Gänze, „variable Steuerung der Denkprozesse“, was bitte?

Kann mir jemand ein anschauliches Beispiel für die unterschiedlichen Modelle oben geben und kurz die Prozentangaben erläutern. Mir ist klar, dass man (Programm-) Code erstellen, optimieren und prüfen lassen kann, dass man Daten in Tabellen oder längeren Texten analysieren lassen kann oder große Mathematische Terme lösen lassen kann. Aber ich bin neulich schon daran gescheitert, mir ein sechsminütiges Video transkribieren zu lassen…

Du kennst doch bestimmt Reasoning, wie OpenAIs O3 Modelle, oder? Da tut das Modell vor der Antwort Schlussfolgern und es dauert etwas länger bis eine Antwort vom Modell kommt. Wie viel Text das Modell zum Schlussfolgern verwendet (in einfach erklärt „wie lange das Modell vor der Antwort „nachdenkt“) können die Entwickler dabei frei entscheiden und variabel einstellen (so können die Entwickler auch Geld sparen, da langes nachdenken deutlich teuerer ist). Entwickler können dadurch auch das Modell komplett ohne Reasoning verwenden, was etwas günstiger, als das mit Reasoning für die Entwickler, die das Modell nutzen ist. Das geniale ist, dass das das gleiche Modell ist, dass Hybrid zwischen Reasoning und ohne Reasoning wechseln kann. Bei OpenAI gibt es dafür im Moment noch verschiedene Modelle, bei Google geht das mit dem gleichen Modell.

Du kennst doch bestimmt Reasoning, wie OpenAIs O3 Modelle, oder? Da tut das Modell vor der Antwort Schlussfolgern und es dauert etwas länger bis eine Antwort vom Modell kommt. Wie viel Text das Modell zum Schlussfolgern verwendet (in einfach erklärt „wie lange das Modell vor der Antwort „nachdenkt“) können die Entwickler dabei frei entscheiden und variabel einstellen (so können die Entwickler auch Geld sparen, da langes nachdenken deutlich teuerer ist). Entwickler können dadurch auch das Modell komplett ohne Reasoning verwenden, was etwas günstiger, als das mit Reasoning für die Entwickler, die das Modell nutzen ist. Das geniale ist, dass das das gleiche Modell ist, dass Hybrid zwischen Reasoning und ohne Reasoning wechseln kann. Bei OpenAI gibt es dafür im Moment noch verschiedene Modelle, bei Google geht das mit dem gleichen Modell.