OpenAI erweitert ChatGPT um o3-pro-Modell

OpenAI setzt seinen Erweiterungskurs im Bereich künstlicher Intelligenz konsequent fort. Nach der Einführung der Modelle o3 und o4-mini im April dieses Jahres folgt nun die Pro-Version des o3-Modells. Die neue Variante zeichnet sich laut des Unternehmens durch ihre besondere Arbeitsweise aus, bei der Präzision vor Geschwindigkeit steht.

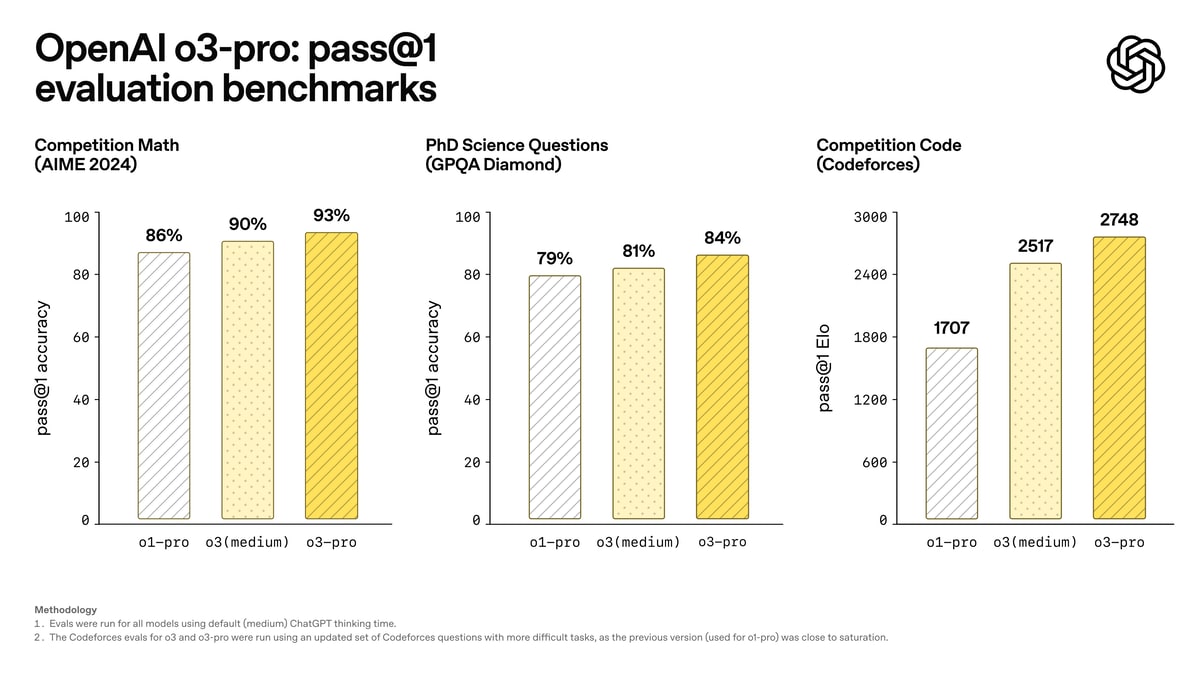

Das o3-pro-Modell wurde speziell für komplexe Aufgabenstellungen entwickelt, bei denen die Genauigkeit der Antworten im Vordergrund steht. OpenAI betont in den Veröffentlichungshinweisen, dass das Modell für anspruchsvolle Fragen konzipiert wurde, bei denen Zuverlässigkeit wichtiger ist als schnelle Antwortzeiten. Die längeren Verarbeitungszeiten von einigen Minuten werden dabei bewusst in Kauf genommen. Die Benchmarks zeigen, dass o3-pro sowohl das Basismodell o3 als auch das o1-pro-Modell in den Testbewertungen übertrifft.

Allerdings gibt es bei der Nutzung des o3-pro-Modells einige Einschränkungen. Funktionen wie Bildgenerierung und Canvas werden nicht unterstützt, weshalb Nutzer für diese Anwendungen auf andere Modelle ausweichen müssen. Die Verfügbarkeit des o3-pro-Modells ist zunächst auf Nutzer von ChatGPT Pro und Team beschränkt. Enterprise- und Bildungskunden erhalten in der kommenden Woche Zugriff auf die neue Funktion. Interessierte können gern hier reinschauen, da steht dann alles zum neuen Modell.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Ich blicke da aktuell nicht mehr durch. Bin selber Plus Nutzer und nehme so gut wie immer das Standardmodell (aktuell 4.1). Klar, Reasoning nutze ich auch, aber doch eher selten. Unverzichtbar im Alltag ist es, aber als Endanwender will ich doch nicht erst überlegen müssen, welches Modell ich nehme. Das soll ChatGPT gefälligst selbst auswählen.

ich hab durch die Telekom perplexity Pro für ein Jahr gratis bekommen und der wählt je nach Aufgabe das (vermutlich) beste Modell aus OpenAI, Anthropic, Google etc. Bei komplexeren Aufgaben schaltet er dann automatisch Reasoning ein. Damit fahr ich ganz gut.

wenn man allerdings NUR auf OpenAI setzt, weiss ich keine entsprechende Lösung dafür.

also mir kommt es selten auf Geschwindigkeit an. deswegen nutze ich fast ausschließlich das O3 Modell.

das gibt mir meiner Erfahrung nach die besten Antworten und guckt auch vorher im Netz nach, bevor es etwas einfach unüberlegt aus seinen Trainingsdaten ausspuckt. damit fahre ich für mich bisher am besten. das neue o3 Pro muss ich jetzt erst noch testen.

Wird noch irgendjemand schlau aus den ganzen Modellen? Ich jedenfalls nicht mehr. Wofür soll man welches benutzen?

Wird GPT 4.1 nicht schon mit „Präzission“ als Eigenschaft beschrieben?

Ist 3o Pro nun noch präziser aber eine Nummer kleiner? Ich werd immer mehr verwirrt…

Tatsächlich stehe ich auch regelmäßig vor der Frage welches Model. In der Familie wird das genommen was vorab eingeschaltet ist, da weiß glaube nicht einmal jemand das es andere gibt. Etwas übersichtlicher wäre wirklich schön.

Nur so kleiner Tip:

Ich nutze Monica.im, da hat man die Auswahl zwischen diverseren Modellen und Anbietern ( ChatGPT, Claude, DeepSeek, Perplexity plus diverser Bildgeneratoren usw.. ), zwar nicht immer die allerneusten MML’s , dafür mehr Auswahl und ich zahle im Jahr weniger als ChatGPT kostet.

Ganz im Gegenteil: solchen reinen Briefkastenfirmen, die viel Energie dafür aufwenden zu verstecken, wer sie sind und wer den Service betreibt, sollte man weder Geld noch Daten anvertrauen. Das Missbrauchspotentiel ist bei solchen Firmen und ein Vielfaches höher als woanders.

„Ich sage dir nicht, wer ich bin. Aber vertrau mir: ich mache schon nichts Schlimmes mit deinen Daten“.

Wie schaffst du es weniger im Jahr zu zahlen als GPT im Monat kostet? Laut deren Seite kostet der unlimitierte Plan 199€ im Jahr und der limitierte 99€ im Jahr.

Vielleicht gibt es ja mal ein Modell welches entscheiden kann was der Nutzer für ein Modell braucht.

Quasi als Concierge der Gäste da hin leitet wo sie hingehören

Gute Idee. Ich habe nämlich auch den Überblick verloren und teste immer wieder mehrere Modelle für eine Aufgabe, wenn diese nicht gut gelöst wurde. Das ist Zeit und Energieverschwendung.

Gestern habe ich übrigens meine MRT-Aufnamen meiner Schulter (als AVI von der CD exportiert) in ChatGPT gekippt. Und zu meiner Überraschung erhielt ich eine gut gemachte ausführliche und plausible Diagnose. Bin gespannt, ob diese sich von der des Radiologen unterscheidet. Diese habe ich nämlich noch nicht. Aber wenn schon frei zugängliche LLMs solche Auswertungen manchen können – wie gut sind dann darauf spezialisierte Modelle? Hat ChatGPT seine Modelle bereits mit medizinischen Daten trainiert oder wieso können die das schon? Fragen über Fragen.

Auffällig dabei war, dass die meisten ChatGPT LLMs die AVIs nicht akzeptierten und medizinische Diagnosen ohnehin verweigerten. Und auch ChatGPT 4o, welches anfangs die AVIs ausgewertet hatte, verweigerte später hier seinen Dienst. LLMs anderer Anbieter erlaubten gar keinen Videoupload, akzeptierten nur ein Bild pro Anfrage und verweigerten meistens Diagnosen.

Ich verstehe die Bedenken, aber wenn du bedenkst, wieviele Leute hierzulande zu Heilpraktikern rennen oder sonst so einen homöopathischen Quatsch veranstalten, kann ein LLM die Situation eigentlich nur verbessern. – ich würde es freigeben ^^

Welches Modell hat dir denn eine die Antwort geliefert, wenn 4o verweigert hat?

An all diejenigen, die sich über die Modell-Versionierungen wundern, hier ein Tip von Karpathy:

– GPT-4o für leichte Alltagsaufgaben / -fragen

– o3 für schwierige Aufgaben inkl. Reasoning

– GPT-4.1 für Vibe Coding

– GPT-4.5 für kreatives Schreiben

– Deep Research bei Bedarf aktivieren

Und den Rest kann der Normalanwender vergessen. o3 Pro wird da natürlich nochmal was ändern und halt das „noch bessere“ o3 werden (muss man ja erst einmal abwarten).

Info von Karpathy inkl. Infographic: https://x.com/karpathy/status/1929597620969951434