KI-gestützte Bildoptimierung: HiPixel bringt native Upscaling-Technologie auf den Mac

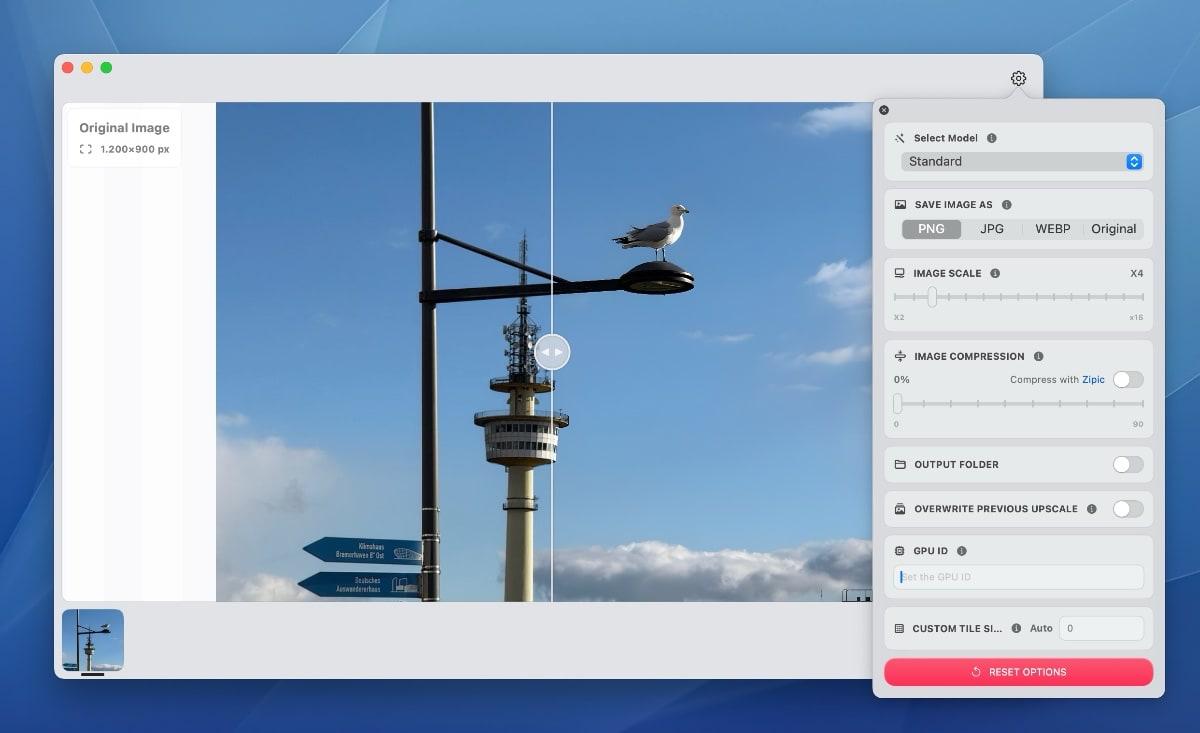

Eine neue Anwendung für die Verbesserung von Bildauflösungen wurde neulich für macOS veröffentlicht. HiPixel setzt auf die bewährten KI-Modelle der Open-Source-Software Upscayl (hier unser Bericht der Software für Windows, Linux und macOS), präsentiert sich jedoch als native macOS-Anwendung mit optimierter Benutzeroberfläche.

Die in SwiftUI entwickelte Software nutzt verschiedene KI-Modelle zur Bildverbesserung, darunter Standard, Lite, High Fidelity und Digital Art. Diese basieren auf Algorithmen wie Real-ESRGAN und Remacri, die ursprünglich in Upscayl implementiert wurden.

Ein besonderer Vorteil von HiPixel liegt in der nativen Implementierung für macOS. Im Vergleich zur Electron-basierten Upscayl-Anwendung benötigt HiPixel weniger Systemressourcen. Die Software integriert sich nahtlos in das Betriebssystem und unterstützt systemspezifische Funktionen wie den automatischen Wechsel zwischen Hell- und Dunkelmodus sowie native Benachrichtigungen.

Die Benutzerfreundlichkeit stand bei der Entwicklung im Fokus. Bilder können per Drag-and-Drop in die Anwendung gezogen werden, woraufhin der KI-gestützte Upscaling-Prozess automatisch startet. Für umfangreichere Projekte steht eine Stapelverarbeitung zur Verfügung, die mehrere Bilder gleichzeitig optimieren kann. Die Integration von URL-Schemata ermöglicht zudem die Verbindung mit anderen Anwendungen.

Technisch interessierte Nutzer finden den Quellcode der Software unter der AGPLv3-Lizenz auf GitHub. Die Systemvoraussetzungen beschränken sich auf einen Mac mit Intel- oder Apple-Silicon-Prozessor und macOS 13.5 Ventura oder neuer. Die GPU-Beschleunigung sorgt für effiziente Verarbeitungsgeschwindigkeit bei der Bildoptimierung.

Aktuell unterstützt HiPixel noch nicht alle KI-Modelle, die in Upscayl verfügbar sind. Die Entwickler haben sich zunächst auf die wichtigsten Funktionen konzentriert und diese für die Apple-Plattform optimiert. Die Anwendung ermöglicht Einstellungen für die Zielgröße der hochskalierten Bilder sowie die Kompressionsrate.

Ist vielleicht etwas für Menschen, die kleine / alte Bilder etwas aufpeppen wollen. Kann natürlich nicht aus Pixelbildern feinste Bildkost machen, aber man kann es ja mal versuchen. Alternativ gibt es tolle Apps wie Pixelmator (von Apple übernommen), die einen solchen Enhancer an Bord haben.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Vor kurzen mal wieder von einem Kunden „super“ aufgelöste Bilder bekommen. Da kam mir Upscayl ganz gelegen. Das Tool werde ich mir aber mal für den nächsten Einsatz vormerken.

Echt wunderbar, was alles möglich ist! Da ist KI mal gut aufgehoben. Habe alte Bilder in 100cm und gerahmt drucken lassen. Das ging nur, weil die alten Digicam Auflösungen hochskalieren konnte, dank solcher Tools. Photomator hätte da fast schon gereicht mit der Super Resolution. Und so konnten eher schlecht aufgelößte und kleine Bilder dann in Postergröße gedruckt werden. Bei gleichbleibender Qualität. Tolle Sache.

In meinen Augen genauso unbrauchbar wie Upscayl oder Topaz Gigapixel. Das Einzige was dort passiert ist, dass die Ursprungsdateien aufgeblasen werden ohne jegliche Details. Der „Vorteil“ ist, dass es auf jedem Rechner läuft und nur 15 Sekunden dauert, auch wenn es kaum einen Unterschied zum Ursprungsbild gibt.

Wenn man gute Ergebnisse will geht nichts über Supir.

Hier zwei Beispiele von mir. die Ursprungsdatei war 4xx x 5xx px (0,15mp) und das Ergebnis ca. 23mp.

FP 16, Tiled VAE, 50 steps, GPU auf 250W begrenzt, 20min hat’s gedauert mit einer RTX 4090.

Reinzoomen nicht vergessen

https://imgsli.com/MzU3MDU2

https://imgsli.com/MzU3MDUw

Mit welcher Software ist das denn umgesetzt worden? Pinokio oder ComfyUI? Beschäftige mich gerade auch mit UltimateSDUpscale und SuPir. Die anderen RealESRGAN (Upscayl) Lösungen sind ja schon ok, aber nicht das was ich mir so unter modernen KI Upscale vorstelle 😉

Was mich noch stört, oder noch nicht ganz raus habe, ist das verbessern von bereits relativ hoch aufgelösten Bildern. Mein Ziel ist jetzt nicht 160×128 Pixel Bilder hochzuskalieren 😉

Ich habs aktuell in Gradio laufen. Es gibt zig fertige Workflows für ComfyUI aber damit stehe ich auf Kriegsfuß.

Full Precision kannst du direkt vergessen aber FP16 ist völlig ausreichend. bei unter 12GB VRAM solltest du FP8 nutzen.

In jedem Fall funktioniert das alles nur mit Tiled Diffusion (Multidiffusion/Tiled VAE) da selbst schon bei einer Auflösung von 4K eine 4090 mit 24GB VRAM die Grätsche macht und du CUDA Errors ausgespuckt bekommst weil es gerne 44+GB VRAM hätte.

Mit UltimateSDUpscale kam ich auch nie sonderlich weit, ist aber auch schon eine Weile her dass ich das probierte.

Bereits relativ hoch aufgelöste Bilder funktionieren selbstverständlich auch sehr gut (noch besser). Ich wollte nur ein extremes Beispiel zeigen. Wichtig sind ein realistischer Checkpoint (für Fotos nehme ich hier aktuell meist RealVisXL) und ordentliche Prompts. Wenn du dir das manuelle Prompten sparen möchtest eignet sich LLaVA ganz gut: https://github.com/haotian-liu/LLaVA

Wenn du doch ein gering aufgelöstes (z.B. 1,5MP) Ausgangsfoto mit vielen Details hast solltest du in jedem Fall in 2 – 3 Schritten hochskalieren. Beispiel 1,5MP auf 6MP und das Ergebnis dann auf 24MP.

Dadurch vermeidest du Halluzinationen und Details/Strukturen an Stellen die dort nicht hingehören.

Bei einem hoch aufgelösten Foto reicht schon ein kleiner Faktor wenn du das Foto nicht riesengroß haben möchtest und du erhältst dabei deutlich Details + Schärfe.

Es ist egal ob das Ausgangsfoto mit KI erstellt wurde oder mit einer echten Kamera

Echt jetzt? Die Ergebnisse findest du gut und animierst auch noch zum zoomen? Das eine Model hat jetzt auf der rechten Wange Haare bekommen, das andere hat welche, die aus der Jacke wachsen. Und beide Bilder haben ein grundsätzliches, riesiges Problem, dass beide eigentlich unbrauchbar macht. So ziemlich jeder Bereich der Bilder haben unterschiedliche Tiefenebenen. Heißt die Spitze vom Kragen einer Bluse ist scharf, kurz dahinter ist der Kragen selbst unscharf. Obwohl dieser auf der Schärfeebene des Gesichts liegt.

Genau solche Ungenauigkeiten nimmt man immer wahr, unterbewusst und ohne zoomen. Aber eben das lässt solche Bilder NIE richtig aussehen. Dann lieber ein unscharfes Original, aber das ist dann stimmig und wirkt natürlich.

Oder kurz: 250 Watt für 20 Minuten waren Stromverschwendung…

Siehe oben. Das war ein Extrembeispiel (und in nur einem Abwasch von 0,15 auf 23MP) um zu zeigen was möglich ist.

Mit höher aufgelösten Ausgangsfotos und in 2 Schritten gibt es diese Probleme (Halluzinationen, unterschiedliche Schärfebereiche) selbstverständlich nicht.

Sollte man mit dem Ergebnis unzufrieden sein kann man es mit anderen Parametern neu versuchen.

Gerne kannst du bei deinem unscharfen Original bleiben oder mit dem im Artikel vorgestellten Tool, sowie mit Upscayle, Topaz Gigapixel und Co und in kurzer Rechenzeit von unscharf auf unscharf in groß hochskalieren.

Oder kurz: keine Ahnung wie viel Watt und keine Ahnung wieviele Minuten Stromverschwendung für deinen Kommentar 🙂