Sora: Menschen können KI-Videos in Studie kaum von echten Clips unterscheiden

OpenAI hat Mitte Februar seine neue Video-KI Sora vorgestellt. Es handelt sich hier um ein Text-zu-Video-Modell, das recht beeindruckende Ergebnisse liefern kann. Viele Fragen sind allerdings noch offen. Beispielsweise rechne ich damit, dass es sehr lange dauern dürfte, so einen Clip zu rendern. Eine Studie zeigt inzwischen jedoch auf, dass es für die Betrachter schwierig ist, die KI-Videos von tatsächlich von Menschen gedrehtem Material zu unterscheiden (via Variety).

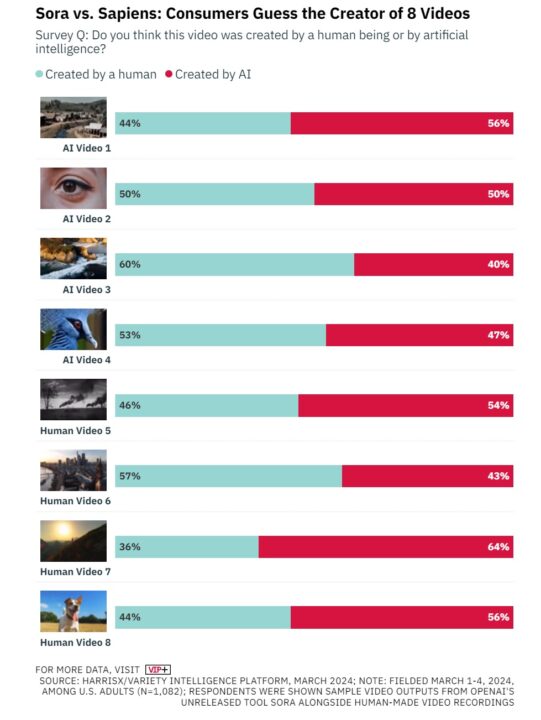

Dies haben die Marktforscher von HarrisX in einem Test mit Probanden ermittelt. So konnten die meisten Befragten nicht mit Sicherheit sagen, ob ein Ihnen gezeigtes Sora-Video von KI oder einem Menschen erstellt worden war. Viele tippten fälschlicherweise auf ein menschengemachtes Video.

Die Tests hat HarrisX in den USA durchgeführt. Letzten Endes verdeutlicht man hier, dass es in Zukunft immer schwieriger werden dürfte, KI-Fakes von echtem Videomaterial zu unterscheiden. Das Missbrauchspotenzial ist also enorm. Aber auch in Hollywood hat man schon aufgehorcht und überdenkt teilweise langfristig angesetzte Studio-Erweiterungen, sollte man etwa statt aufwändiger Kulissen in Zukunft einfach Sora verwenden können.

Ich selbst bin sehr auf die Zukunft gespannt. Es wird sicherlich sowohl positive als auch negative Auswirkungen von KI-Modellen wie Sora geben.

- Update 2025 / A-Version: Der Akku kann ausschließlich mit dem im Lieferumfang enthaltenen Ladegerät...

- Update 2025 / A-Version: Der Akku kann ausschließlich mit dem im Lieferumfang enthaltenen Ladegerät...

- SCHNELLER AUTOFOKUS: Verlassen Sie sich auf kontinuierliches Tracking und den Augen-AF (Mensch/Tier), um...

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Die Filmindustrie arbeitet seit ihrer Gründung mit billigen Tricks. Da ist KI lediglich eine moderne Weiterentwicklung.

Tyler Perry hat die 800 Mio $ Erweiterung seines Studios bereits gestoppt.

Ist doch super, zukünftig braucht man kein Netflix & Co Abo, keine teuren Filmstudios und keine überteuerten Schauspieler mehr, man generiert seine eigenen Serien und Filme einfach nach Wunsch. Jetzt muss die KI nur noch die eigenen Vorlieben lernen und so einen Müll vermeiden wie Googles Bildgenerator neulich hervorgebracht hat.

Tolle Idee: Statt sich durch die Kreativität Dritter inspirieren zu lassen und so aus der eigenen Blase auszubrechen, verstärkt man den Blasenkäfig noch mit Stacheldraht.

Blasenkäfig klingt irgendwie schmerzhaft…

Weil die Leute beim Medienkonsum derzeit auch schon so heftig aus ihrer Blase ausbrechen und sich kreativ beeinflussen lassen.

Dagegen hilft Blasentee und ein Aluhut …

In der Unterhaltungsindustrie mag das ein nettes Spielzeug sein, in der Presse und Berichterstattung wird die Macht der Darstellung damit noch größer…

Für Disney der absolute Traum, wenn demnächst jeder Fan via Foto-Upload seine eigene Rolle im Film spendiert bekommt.

Also noch kann man sie unterscheiden.

Speziell bei Videos mit Menschen braucht man einfach nur auf bestimmte kleine Details(z.B. Augen, oder die Bewegung)

zu achten, die bei echten Videos niemals so perfekt sind, weil echte Menschen eben nicht perfekt sind.

Jeder echte Mensch hat auch biologisch bedingte Asymetrien in seinem physischen Erscheinungsbild, die künstlichen

KI-Figuren sind aber absolut perfekt und wirken daher schon in ihrer gesamten Erscheiung unnatürlich.

Das wird wahrscheinlich auch irgendwann berücksichtigt, aber derzeit kann man genau daran noch sehr oft KI-Videos

von echten Videos unterscheiden.