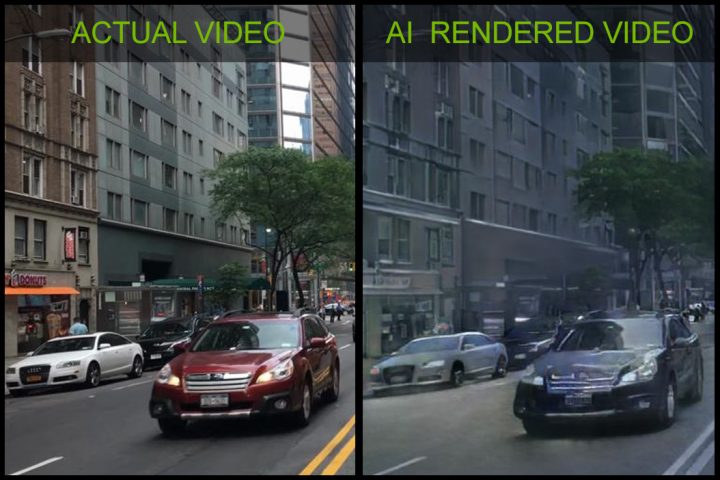

Nvidia: KI rendert 3D-Umgebungen auf Basis von Videos

Nvidia ist nicht nur für seine Grafikkarten bekannt, das Unternehmen setzt auch viel auf die Forschung und Entwicklung und auf das Thema autonomes Fahren. Unter anderem hat man bereits diverse Partnerschaften am Start. In der Forschungsabteilung des Konzerns hat man nun eine künstliche Intelligenz entwickelt, die in der Lage ist, 3D-Umgebungen zu rendern, welche echten Videoaufnahmen nachempfunden sind. Zum Training des neuronalen Netzes benutzte man beispielsweise Aufnahmen von Fahrten durch diverse Städte.

“Nvidia has been creating new ways to generate interactive graphics for 25 years – and this is the first time we can do this with a neural network,” Catanzaro said. “Neural networks – specifically – generative models are going to change the way graphics are created.”

…

“One of the main obstacles developers face when creating virtual worlds, whether for game development, telepresence, or other applications is that creating the content is expensive. This method allows artists and developers to create at a much lower cost, by using AI that learns from the real world,” Catanzaro said.

Das Ergebnis ist schon ziemlich beeindruckend und wird vor allem Entwicklern von Apps, Spielen oder VR-Anwendungen helfen, Zeit beim Rendering einzusparen und nicht Model für Model einzeln zusammenzusetzen. Nvidia hat auf Basis der KI eine kleine Fahr-Anwendung programmiert, die auf der Tenso Core GPU läuft und aktuell auf der NeurIPS-Messe in Montreal gezeigt wird.

Die KI analysiert die Struktur des Bildes und zerlegt diese in die sichtbaren Objekte wie beispielsweise Autos, Menschen, Gebäude etc. Erst dann werden die Objekte mit den entsprechenden Texturen gefüllt, welche die KI aus den gelernten Bildern entnimmt. Das Ergebnis ist eine virtuelle Landschaft, die schnell bearbeitet werden kann.

Da die Technologie noch in den Kinderschuhen steckt, kann man zum jetzigen Zeitpunkt noch nicht sagen, wann die breite Masse Zugriff auf die Funktionen bekommt.

Wenn ich das richtig verstehe, wird das Video zunächst segmentiert (dafür wird ja schon länger ML eingesetzt – „AI“ hat damit nichts zu tun), die Segmente werden als Objekte interpretiert, aus dem Original-Video re-texturiert (sodass sie begrenzt perspektivisch verzerrt werden können) und auf eine „freigestellte“ Hintergrund-Animation gesetzt (Original-Video minus segmentierte Objekte, mit interpolierter Texture in den Lücken).

So richtig „neu“ ist das nicht, aber durchaus nett anzusehen. Nochmal, „Intelligenz“ ist da nicht involviert, denn nach wie vor wird nur mit trainierten und daher bestimmbaren Datenmodellen gearbeitet, NICHT mit unbekannten Daten (was Intelligenz indizieren würde). *1

Im Video behauptet NVidia, dass das finale Ergebnis nicht in einer „Graphic-Engine“ gerendert wurde, nur um dann zu sagen, dass es in einer „Graphic-Engine“ erzeugt wurde (nämlich zusammengesetzt von der AI, die natürlich eine „Graphic-Engine“ verwendet, um Ausgaben zu erzeugen). Klar, das ist „Nit-Picking“, weiß ich, aber es zeigt, dass da immer noch mit Wasser gekocht und mehr PR um „Behauptungen“ als um belegbare Fakten gemacht wird.

—-

*1: Und da wundert sich noch jemand, dass Google-Captcha immerzu Busse und Autos identifiziert haben möchte? Wir alle arbeiten „freiwillig“ am Trainieren von solchen Datenmodellen mit: Die Captcha-Bilder sind ganz banal immer mal um ein paar Pixel versetzt, sodass in der Masse ganz bequem komplette Trainings-Datensätze für „Autos“ und „Busse“ erzeugt werden.

Hmm, entweder habe ich es falsch verstanden oder du… Der tiefere Sinn hinter dieser AI Geschichte ist, dass man anschließend die digitale Welt komplett anders (virtuell) befahren kann, als das Video aufgenommen wurde. Daher hat es durchaus mit AI zu tun, da Blickwinkel und Verkehrsinteraktion berechnet werden, die gar nicht im Video aufgenommen wurden.

Die „AI“ (nee … die ML-basierte Segmentierung) ist, wenn ich das richtig sehe, nichts anderes als das, was seit Jahren in der Movie-Industrie zum „Gesichter-Austauschen“ verwendet wird:

Das System „erkennt“ bekannte Muster (Gesichter – oder eben sich bewegende Einheiten wie Busse, Autos, Fahrräder), segmentiert diese aus dem Hintergrund heraus (sodass der Hintergrund in den Lücken interpoliert werden kann) und kann dann 3d-Modelle (oder auch nur perspektivisch verzerrte Versionen) der erkannten Elemente „beliebig“ in den „interpretierten“ Hintergrund setzen.

Ob man also ein Gesicht mit neuer Animation versieht und auf einen „fremden“ Körper propft oder – etwas komplexer, weil mit mehreren Schichten gebaut – eine Verkehrsszene neu zusammensetzt, ist nicht grundsätzlich verschieden. Wie gesagt: „Intelligenz“ sähe ich da erst dann, wenn UNBEKANNTE Objekte verwendet würden (was passiert, wenn da ein ELEFANT durch die Straße läuft? Antwort: SEGMENTIERT werden kann der immer noch, aber seine 3d-Interpretation wäre gegebenenfalls ziemlich begrenzt, ohne Basis-Objekt, auf das die Texture projeziert werden kann).

Der von mir oben beschriebene Ansatz (ich verwende den zum Teil in meiner Arbeit in der Filmindustrie) erlaubt genau das, was im Video zu sehen ist: Neu-Zusammensetzen von Szenarien. Was damit eben NICHT geht, ist eine BELIEBIGE Neudarstellung (dazu fehlt die Texturinformation – oder man muss mit extremen Verzerrungen leben – schon in dem Video sind deutliche Interpolations- und Verzerrungsartefakte zu sehen!) ODER der Umgang mit nicht in den Erkennungsmodell enthaltenen Objekten.

Wie erwähnt: Nicht SCHLECHT. Aber inhaltlich/technisch nicht neu, sondern eben nur ein Snapshot von dem, was heute mit schnellen GPUs/CPUs machbar ist.

Hä, habe ich doch geschrieben und sieht man auch in dem Video, genau dein letzter Absatz wird mit dieser AI verwirklicht. Die Texturen fehlen nicht, da ein Bus nach ein paar Stunden Videoaufnahmen mal von allen Seiten gesehen wurde und daher alle zukünftigen Busse damit digital versehen werden. Außerdem geht es selbstverständlich darum, dass du in dieser digitalen Welt einen Stau provozieren kannst, indem du dich beispielsweise quer auf die Straße stellst. Die AI hat gelernt, dass vermutlich 5 gelbe Taxis, ein Bus etc. hinter dir fahren werden und diese mit ihrem fahrzeugspezifischen Abstand und -verhalten hinter dir warten. Genau, darum geht es, nicht um Videos neu zu renden, sondern als Beispiel ein minimalistisches GTA (Spiel) in Handumdrehen zu ermöglichen.

> Die Texturen fehlen nicht, da ein Bus nach ein paar Stunden Videoaufnahmen mal von allen Seiten gesehen wurde und daher alle zukünftigen Busse damit digital versehen werden.

Richtig. Da der Bus heraussegmentiert wurde („erkannt“), kann die Textur für das Modell korrekt angebracht werden – mit unbekannten Objekten geht das NICHT.

> Außerdem geht es selbstverständlich darum, dass du in dieser digitalen Welt einen Stau provozieren kannst, indem du dich beispielsweise quer auf die Straße stellst.

Auch richtig, hat aber nichts mit der Technik an sich zu tun: Die dreht sich um die Darstellung, nicht um die Simulation von Verkehrsströmen (es wird im Video NICHT behauptet, dass Verkehrssimulationen damit möglich werden, sondern, dass die DARSTELLUNG von Verkehrssituationen erleichtert wird, weil eben NICHT immerzu ein 3d-Modell errechnet werden muss – s.u. Es geht hier einfach darum, dass 2d-basierte Szenendarstellungen VIEL schneller arbeiten als 3d-Modelle. Die 3d-Modelle werden nur für die Datenaufbereitung a priori benötigt).

> Die AI hat gelernt, dass vermutlich 5 gelbe Taxis, ein Bus etc. hinter die fahren werden

Das wird im Video weder behauptet noch angedeutet. Es geht nur und ausschließlich um die Darstellung.

Das alleine ist beeindruckend genug, denn es bedeutet, dass man auf simplifizierten Modellen basierend sehr schnell glaubwürdige Umgebungen MIT INHALTEN (bewegten Objekten) darstellen kann OHNE alles in 3d zu berechnen. Das wird mit der Ansage „nicht in einer Grafik-Engine berechnet“ gemeint sein: Es ist eben keine 3d-Engine (Unreal Engine wird da nur für die Perspektiven-Interpretation der simplifizerten Objekte – Autos, Busse – verwendet, NICHT für das Applizieren der Texturen), aber es ist eine „Grafik-Engine“ in dem Sinne, dass das System Bilder ausgibt 🙂

Nochmal: Nein, da wird keine Verkehrssimulation betrieben, nein, da werden nicht automatisch Autos hinter Busse geklebt. Das System erlaubt nur die SCHNELLE und vereinfachte „gut-genug“-Darstellung (in 2d nämlich) von (im Original eigentlich) 3d-Szenen.

Dann glaub du, was du möchtest und ich glaube, was ich möchte 😉

Im Video sieht man eindeutig, wie ein Mitarbeiter im Nachhinein mit Lenkrad beliebig durch die „Welt“ fährt. So was wäre nicht möglich, wenn es ausschließlich um eine 2D Video -> 3D-Szenen Darstellung geht. Aber lassen wir das, wir kommen da nicht auf einen Nenner.

Hmm … klar, wir können auch Sonntag-Machen.

Aber Du belegst nicht, dass behauptet wird, dass Verkehrssimulationen durch das Video gezeigt werden (wie in Deinem Kommentar „die AI lernt, dass … Autos hinter Bus …“). Darum geht es nicht, das interpretierst Du nur da rein.

Es geht um die vereinfachte Darstellung (2d statt 3d) von Objekten, die aus vorhandenem (Video-)Material extrahiert und interpretiert werden. Es geht nicht um Simulationen von Verkehrssituationen (Stau-Erzeugung: Die kannst Du DARSTELLEN, aber nicht „AI-basiert erzeugen“, das passiert da nicht automatisch).

Es geht nicht um „Glauben“, sondern darum, was im Video gezeigt und behauptet wird: Du musst schon ein Objekt platzieren, damit es dargestellt wird. Die Verkehrssituation hat NICHTS mit der Machine-Learning-Systematik zu tun, die dreht sich einzig und allein um das Segmentieren und perspektivische Verzerren („Darstellen“) von Objekten, die Du an anderer Stelle in die Szene einfügst. *1

Du darfst GLAUBEN, was Du willst, aber meine tägliche Arbeit basiert auf dem, was machbar ist: Alles das, was im Video gezeigt wird, können wir in den Studios schon seit längerer Zeit machen – nicht so schnell, aber technisch völlig problemlos. Verkehrssimulationen (falls Du nicht weißt, was das ist: Da geht es um die SIMULATION, also das ERRECHNEN von – wahrscheinlichen – Verkehrsflüssen, NICHT um das gescriptete Darstellen von vorhandenem Datenmaterial – das ist das, was Du mit „da fährt einer per Lenkrad durch die Szene“ meinst, ja klar, das ist doch der SINN von DARSTELLUNG von Daten: Dass Du DATEN DARSTELLST!) sind etwas anderes und haben nichts mit der hier gezeigten Technik zu tun.

—-

*1 Schau Dir einfach den Schluss vom Video nochmal an – die Tanzszene dreht sich genau darum, dass erkanntes Material anders dargestellt wird. Da wird keine „Verkehrssimulation“ gemacht, sondern die BEWEGUNG anhand üblicher Body-Pose-Parameter erkannt (das geht in Echtzeit) und auf die zweite Person übertragen. Das NEUE hier ist, dass die zweite Person zwar auf einem 3d-Modell basiert, für die DARSTELLUNG diese aber nicht benötigt wird, sondern 2d-interpoliert wird. DAS ist das „Geniale“ in diesem Video. Die Qualität muss halt noch besser werden, damit das für Money-Shots funktioniert.

Warum missionierst du hier eigentlich so rum? Sonntags nix zu tun? I’m Übrigen: Was DU als AI bezeichnest interessiert wohl die wenigsten. Fakt ist dass ML üblicherweise als Teilbereich des Forschungsbereichs AI angesehen wird. Mehr wurde hier auch nicht behauptet.

> Warum missionierst du hier eigentlich so rum? Sonntags nix zu tun?

Ist das nicht meine Sache? Wo missioniere ich denn? Weil ich mich auf die Inhalte des Videos, statt auf Reininterpretieren von Wunschdenken beziehe?

> I’m Übrigen: Was DU als AI bezeichnest interessiert wohl die wenigsten.

Schon möglich, ich gehe da aber konform mit nahezu allen Kollegen, die in dem Bereich arbeiten 🙂

Ich stimme Dir völlig zu: ML ist ein Teilbereich von AI als Forschungsgebiet. Das heißt eben nicht, dass jede Anwendung von ML (Erzeugung von Datenmodellen, die zur „Interpretation“ von Daten genutzt werden können) automatisch „AI“ ist. Das Durcheinandermischen von AI („Forschungsgebiet“) und ML („Anwendung“) ist ja gerade, was die Diskussion oft in die falsche Richtung führt.

Beispiel: Du brauchst eine AI, um „autonomes Fahren“ gesellschaftstauglich zu machen. Die Diskussion um „eine Entscheidung, ob die alte Oma oder eine Gruppe Schülerinnen überfahren wird“ ist sinnlos, wenn Du nur von ML sprichst, aber wichtig, wenn Du von AI sprichst. Wir sind noch nicht soweit, dass wir eine AI haben, die eine solche ENTSCHEIDUNG selbstständig fällen kann, bislang haben wir „nur“ ML-basierte Modelle, die datenbasiert ein „programmiertes“ Verhalten zeigen.

Solange wir ML verwenden, sind die Programmierer für die Gewichtung der „Entscheidung“ verantwortlich. Wenn wir eine AI haben, müssen wir überlegen, ob das Auto verantwortlich ist (die AI). Das ist ein grundsätzlicher und sehr wichtiger Unterschied.

Im hier gezeigten Video wäre eine AI das, was der andere Kommentator in das Video hineininterpretiert: Eine Verkehrssimulation (mag ja eingeschränkte AI sein, aber eben doch mehr, als was gezeigt wird). Demonstriert wird aber „nur“ ML, nämlich das Segmentieren und Interpretieren bekannter Objekte, NICHT das Vorhersagen UNBEKANNTER Situationen (Verkehr). Autos und Busse basierend auf vorhandenen Daten darzustellen ist nicht AI.

Hier: https://en.wikipedia.org/wiki/AI_effect

Seufz.

In den meisten wissenschaftlichen Feldern ist noch nicht einmal der Begriff „Intelligenz“ kritikfrei definiert – und da wollen ein paar Hipster mit Hilfe der Wikipedia (die nun wirklich nicht für Verlässlichkeit steht) einfach definieren, was KÜNSTLICHE Intelligenz ist?

Ich habe oben doch nun schon erklärt, warum die Unterscheidung zwischen AI – als Forschungsgebiet, selbstredend, und als Diskussionsthema – und z.B. ML WICHTIG ist. Wenn man allem und jedem einfach AI zuschreibt, was aussieht, wie ein denkender Computer, dann drückt man sich vor ganz grundlegend wichtigen Diskussionen.

Und das ist (ganz und gar unkünstlich) NICHT intelligent.

Noch einmal: Es ist WICHTIG, zwischen „Künstlicher Intelligenz“ und „Maschinen-Lernen basierten Programmen“ zu unterscheiden. AUCH, aber nicht NUR, weil damit die Frage nach Verantwortung erst einmal aufgeschoben werden kann. In dem Augenblick, in dem irgendjemand (nicht nur Wikipedia, sondern jemand ernstzunehmendes) einem Computer/Programm INTELLIGENZ zuschreibt, muss dieser Jemand auch die Frage nach Verantwortung beantworten können.

Und damit bin ich dann raus. Ich beschäftige mich seit den 1980er Jahren mit „künstlicher Intelligenz“ und habe hier das Gefühl verarscht zu werden. Mein Angebot zu einem Bierchen steht – aber versteckt euch nicht hinter irgendwelchen Webseiten. Ich bin bereit, meine Erfahrung, mein Wissen und meine Lernbereitschaft LIFE und IN FARBE unter Beweis zu stellen. Ich bin zu jeder fundierten Diskussion bereit. Aber bitte mit Sachverstand, Hintergrundwissen und Argumenten.

Nicht mit Wikipedia.

Du hättest den Artikel lesen sollen statt nochmal dasselbe runterzubeten.

Alles sehr interessant, aber bitte brüll nicht so rum, das liest sich schlimm und wird allgemein als unhöflich empfunden.

Nit Picking? Rosinen picken oder wenn schon die deutsche Redewendung nicht genommen werden soll, dann nut picking.

Was den Rest betrifft, volle Zustimmung, auch zu Deiner Antwort weiter unten 🙂

Ich lade euch im Übrigen gerne auf ein Bierchen ein, wenn ich wieder in Deutschland bin, dann können wir das ohne dumme Angriffe persönlich diskutieren. Lust habe ich dazu allemal, ich treffe zu selten Menschen, die in der Materie bewandert sind (und ihr seid ja offenbar Profis, sonst müsstet ihr mich ja nicht zurechtweisen).

Das meine ich ernst: Wann, wo? Ich zahle die erste Runde.

„Alles das, was im Video gezeigt wird, können wir in den Studios schon seit längerer Zeit machen – nicht so schnell, aber technisch völlig problemlos.“

Ja dann. Wo kann ich mir euer Video anschauen?

Also ich bin nun kein „Hipster“ auch möchte ich nichts definieren woran einige Wissenschaftler seit Jahren scheitern. Aber ich möchte mal festhalten das die Personen die sich damit beschäftigen (hier gehts nur um die im Video) es KI nennen. Ob diese KI vollständig ist oder nur einen Teil abdeckt sei dahingestellt.

Lassen wir denen doch den Erfolg OHNE uns hier noch die Köpfe einzuschlagen 😉