Google Lens wird um neue Möglichkeiten reicher

Highlight der Google I/O ist wohl unbestritten Googles neue Hardware-Palette. Man fasst vielleicht wieder auf dem Tablet-Markt Fuß und bringt auch erstmals eine Smartwatch mit Wear OS an den Start sowie TWS-Kopfhörer mit ANC. Dennoch plauderte man da auch fleißig über die eigenen und vielzähligen Dienste, die man sonst so anbietet. Und zu den wichtigen Diensten gehört ganz klar auch die Suchfunktion.

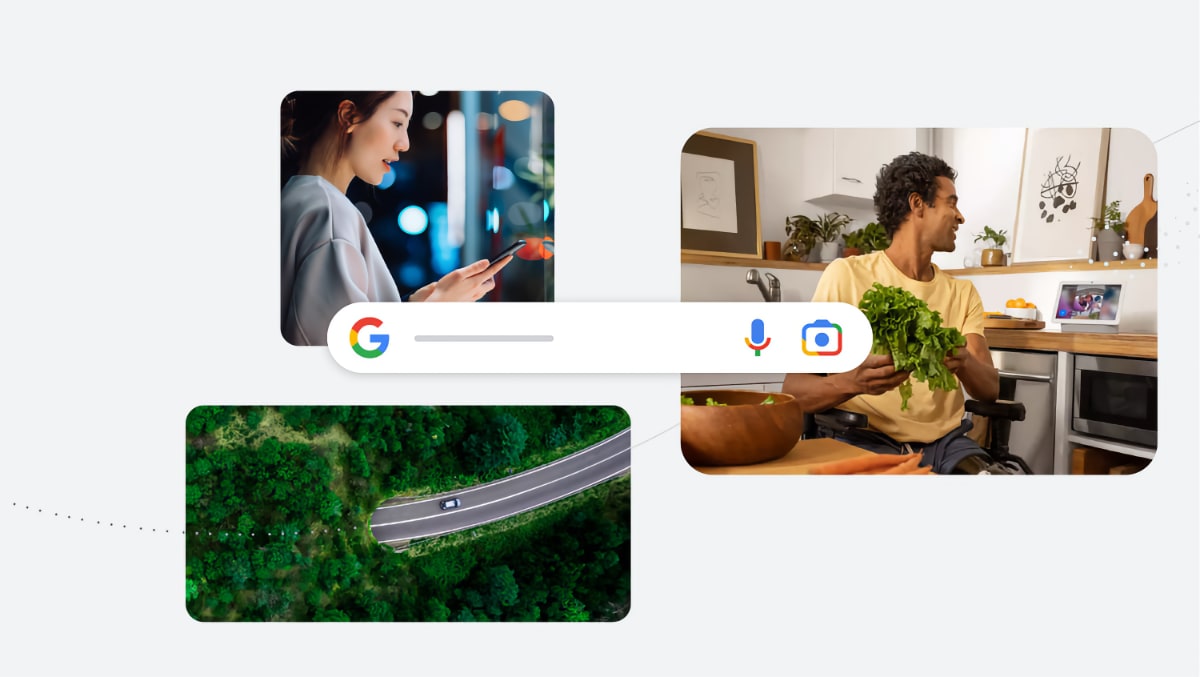

In den vergangenen Jahren wurde die Google-Suche mittels Google Lens auch um eine visuelle Suchfunktion erweitert. Google ist zudem auch in der Lage, Lieder zu erkennen. Da liegt wohl nichts ferner, als dass man künftig sämtliche Arten von Informationen für einen Kontext kombiniert: Text, Sprache, Bild und mehr.

Google hat kürzlich Multisearch angekündigt, um gleichzeitig mit Bildern und Text zu suchen. Hier erweitert man künftig noch um die Möglichkeit, lokale Informationen zu finden. Ihr sucht also nach Kleidung oder Lebensmitteln – Google soll da dann passende Ergebnisse „in der Nähe“ hinsichtlich Restaurants oder auch Einzelhandel abliefern. Muss man mal schauen, inwieweit das dann auch für hierzulande ein Thema ist.

Als Beispiel führt Google ein leckeres Gericht an, zudem ihr aber keine Kenntnis über den Namen habt. Multisearch durchsucht diverse Bilder und Rezensionen auf Webseiten sowie Maps-Community-Mitgliedern und soll das passende Restaurant vor Ort vorschlagen. Lokale Informationen in Multisearch starten im Laufe des Jahres – allerdings erstmal nur auf Englisch, da will man aber im Laufe der Zeit weitere Sprachen anbieten.

Multisearch bietet aber auch die Möglichkeit zur Szenenerkennung. Bewegt ihr eure Kamera hin und her erhaltet ihr Informationen über mehrere Objekte – in einem einzigen Frame. So beispielsweise beim Durchstreifen des Angebots im Lebensmitteleinzelhandel.

Google ist in der Lage sämtliche Produkte, hier die Schokolade, zu scannen und „hilfreiche Informationen“ dazu einzublenden. Sieht recht komfortabel zu handhaben aus – praktisch.

Google greift da bei den Weiterentwicklungen nach eigenen Angaben wieder auf Fortschritte im KI-Bereich zurück. Davon profitiert beispielsweise auch Google Maps mit einer neuen, immersiveren Ansicht oder auch der Google Assistant, der künftig auch ohne Aufwachwort tätig werden soll.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Zufällig habe ich google Lens gerade gestern deinstalliert. Das ist bei mir so eine App mit der man mal rumspielt, die ich dann aber nie wieder praktisch benutzt habe.

Im Studium haben wir mit den Ideen herum gespielt, wie man z.B. Nahrungsunverträglichkeit mit Augmented Reality im Alltag unterstützend begleiten kann. Es ist schön zu sehen, wie die „großen“ das angehen. Wenn denn dann Google Lens auch so ausgebaut wird, dass es vor schädlichen Inhaltsstoffen in Kosmetik warnen kann oder eine Lebensmittelampel nach eigenen gewählten Faktoren ausgeben kann, dann wird es für Lebensmittelhersteller schon etwas schwerer, als beim Nutriscore zu schummeln oder auf der Kosmetik etwas von Selbstfindung und Urwald zu etikettieren. Allein das Problem in der Schwangerschaft, dass Produkte mit Alkoholgehalt nicht ausreichend gekennzeichnet sind oder dass man als Veganer erstmal ein Chipstütenexperte werden muss, um eine Sorte ohne Molkenpulver auf der Zutatenliste zu finden. Da ist noch super viel Ausbaupotential! Ich hoffe, dass Google da ordentlich Arbeit reinstecken wird, und es freut mich zu sehen, wie sie das verständlich umsetzen, damit es auch genutzt wird.

Ich wünschte die Google Lens App würde auf meinem One Plus 9 Pro unterstützt……

Ich weiß ja nicht wie das beim 9 Pro ist, aber mein 8 Pro unterstützte (bevor ich das System gelöscht habe) die google Lens Funktion in der OnePlus eigenen Kamera App.

Ich würde mich aber tatsächlich freuen, wenn diese Funktion im 9 Pro nicht vorhanden wäre, würde viel Arbeit ersparen, diese Funktion wieder zu löschen, ich will diesen google Kram nämlich nicht, das ist auch der Grund, warum ich bei jedem Gerät alle google Dienste und Apps deinstalliere und oder sogar gleich ein ganz anders OS drauf mache.