Apple: CSAM-Erkennung für iCloud-Fotos wird nicht mehr erscheinen

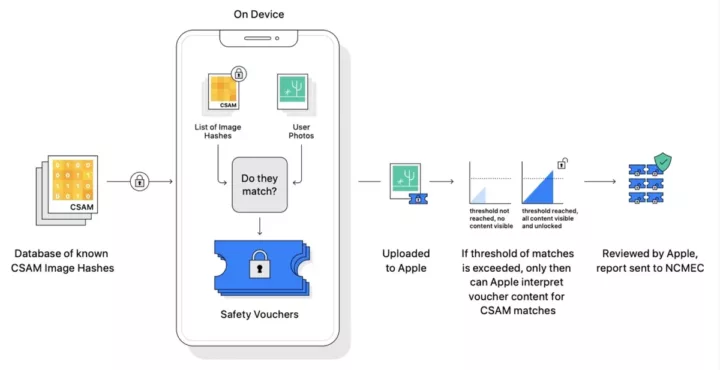

Mit Sicherheit ist vielen von euch noch in Erinnerung geblieben, dass Apple ein Feature in iOS implementieren wollte, das Fotos, die für den iCloud-Upload vorgesehen sind, nach sogenannten CSAM-Aufnahmen (Child Sexual Abuse Material) scannen sollte? Nachdem das Unternehmen nun aber angekündigt hatte, dass man eine Ende-zu-Ende-Verschlüsselung für iCloud Fotos, aber auch Notizen, Backups und mehr einführen werden, heißt es parallel auch, dass die Pläne für die CSAM-Erkennung nun aufgegeben worden sind.

Nach einer ausführlichen Konsultation mit Experten, um Feedback zu den von uns im letzten Jahr vorgeschlagenen Initiativen zum Schutz von Kindern einzuholen, investieren wir verstärkt in die Funktion für Kommunikationssicherheit, die wir erstmals im Dezember 2021 zur Verfügung gestellt haben. Wir haben außerdem beschlossen, unser zuvor vorgeschlagenes CSAM-Erkennungstool für iCloud-Fotos nicht weiterzuverfolgen. Kinder können geschützt werden, ohne dass Unternehmen persönliche Daten durchkämmen. Wir werden weiterhin mit Regierungen, Kinderschützern und anderen Unternehmen zusammenarbeiten, um junge Menschen zu schützen, ihr Recht auf Privatsphäre zu wahren und das Internet für Kinder und uns alle sicherer zu machen. – Apple

Einige Kritiker des Systems hatten argumentiert, dass die Funktion eine »Hintertür« in die Endgeräte geschaffen hätte, mit der Regierungen oder Strafverfolgungsbehörden Nutzer überwachen könnten. Eine weitere Sorge war die Überlegung, dass jemand absichtlich CSAM-Bilder zum iCloud-Konto einer anderen Person hinzufügen, um deren Konto entsprechend zu markieren.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

Apple iPhone 14 (128 GB) - Mitternachtsblau |

699,00 EUR |

Bei Amazon ansehen |

| 2 |

|

Apple iPhone 14 128GB, Mitternachtsblau (Generalüberholt) | 619,99 EUR | Bei Amazon ansehen |

| 3 |

|

Apple iPhone 13 (128 GB) - Grün |

602,00 EUR |

Bei Amazon ansehen |

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Das finde ich super!

Leider sieht es derzeit so aus, als würde es aber auf dem Messenger-Umweg kommen.

Dieses Mal von der EU.

Die Debatte darum wird leider von Befürwortern des Vorschlags nicht sachlich geführt.

Für Infos:

chat-kontrolle.eu

Die EU und deutsche Innenminister mit ihrem Überwachungswahn…dass CSAM nur eine billige Ausrede ist, um auf alles mögliche hin zu überprüfen, ist auch nichts neues. Das Tool, das Apple umrissen hatte, war schon deutlich mächtiger als einfacher Abgleich von Hashes. Das hätte man auf alle möglichen Inhalte trainieren können. Und wo es Möglichkeiten gibt, entstehen Begehrlichkeiten.

Das sind halt PR-Profis. Sie haben das böse CSAM-Wort an iCloud gekoppelt und das gute Sicherheits-Wort an Kommunikation.

Soweit ich den EU-Vorschlag noch in Erinnerung habe, können auch Cloud-Hoster zum Scannen verpflichtet werden, wenn ihnen nix Besseres einfällt als den freiwilligen Scans der Konkurrenz. Aber die Umsetzung dauert Jahre, da sind PR-Meldungen vom Dezember 2022 längst vergessen.

Naja, wenn in einem Rechtsraum die Speicherung von Nachrichtenverläufen in der Cloud nicht mehr sicher möglich ist, muss man das halt irgendwie mitigieren. Also z.B. indem man die Verläufe nicht in der Cloud speichert, oder indem man sie vor dem Upload verschlüsselt.

Es tendiert immer hin zur Überwachen. Da gibt es keine langfristigen Siege oder so.

Ich bin mir nicht sicher, ob ich deinen Kommentar richtig verstehe.

Aber mit dem EU-Vorschlag wird auch die „Ende zu Ende Verschlüsselung“ ausgehoben – indem die Nachrichten und Fotos vom Gerät selbst vor der Verschlüsselung gescannt werden MÜSSEN.

Ja. Da hab ich doch gar nicht widersprochen?

Gesamtgesellschaftlich gibt es da keine Lösung; das wird früher oder später auf jeden Fall ein autoritärer Überwachungsstaat. Im Grunde wollen sie es doch alle. 😀

Familiär oder im privaten Umfeld kann man trotz aller dieser Gesetze natürlich nach wie vor machen, was man will. Faeser wird dir nicht auflauern, wenn du deinen eigenen Matrix Server nutzt. … oder Jabber, z.B. 🙂

Ich weiß nicht, ob wir nicht doch aneinander vorbeireden. Du redest von privaten Matrix-Servern. Oder Jabber-Servern.

Der aktuelle Entwurf zielt NICHT auf Server ab. Dabei ist es egal ob selbst gehosteter Server oder öffentlicher Server.

Der aktuelle Entwurf zwingt die lokale Software, die Inhalte zu scannen, bevor sie an die Server gesendet wird.

In der logischen Konsequenz dürften Messenger-Applikationen, die diese Funktion nicht bieten, nicht in die Stores. Es wäre ja illegal, diese Funktion nicht zu implementieren.

Und seien wir mal ehrlich – ohne die Stores ist jede Software de facto tot.

Es gibt bestimmt Wege. Sei es über Browser, selbst kompilierte Software oder sonstwas. Aber am Ende kann soetwas nur von den hardcore nerds genutzt werden.

Und eben von den verbrechern, die man damit ja eigentlich erwischen wollte.

Private Kommunikation wird also unter generalverdacht gestellt, während Kriminelle Nutzung weiterhin möglich bleibt.

> Ich weiß nicht, ob wir nicht doch aneinander vorbeireden.

Ich bin mir auch nicht sicher. 😀

> Der aktuelle Entwurf zielt NICHT auf Server ab. Dabei ist es egal ob selbst gehosteter Server oder öffentlicher Server.

Wenn es dein Server ist, ist egal ob er scannt, oder?

> Und eben von den Verbrechern, die man damit ja eigentlich erwischen wollte.

Würden alle Verbrecher erwischt, gäbe es ja keine Rechtfertigung mehr für Überwachung. Der Law-and-Order Politiker lebt seit jeher in einer Symbiose mit Verbrechern. 😉

Jetzt bin ich mir aber sicher, dass wir aneinander vorbei reden;)

Es scannt _NICHT_ der Server. Der Scan wird laut Entwurf auf der Messenger-App durchgeführt. Noch BEVOR die Nachricht verschlüsselt und abgeschickt wird. Damit ist die EU der Meinung, die Ende-zu-Ende Verschlüsselung umgehen zu haben, ohne sie kaputt zu machen.

Es ist also egal, welchen Server du nutzt – deine Nachricht wird immer gescannt und analysiert, solange du eine Messenger-App nutzt, die das tut.

Und da der Scan verpflichtend ist, ist es im Umkehrschluss illegal, diese Funktion nicht einzubinden. Und damit würde eine App, die nicht scannt, nicht in den App Store der Anbieter kommen.

Sobald du also eine Messenger-App installierst, die aus dem Store kommt, wird dein Inhalt gescannt. Total unabhängig vom Server.

Und wo schickt der Scan diese Info dann hin?

An den Hersteller des Betriebssystems oder wie? Behörden können es ja nicht sein, weil da müssten sie je nach Land ja einen anderen Ansprechpartner haben..

Doch, genau das. Es wird direkt an eine Behörde gemeldet.

Ich hab den Gesetzesentwurf jetzt nicht mehr direkt im Kopf – aber es ist glaube ich eine zentrale europäische Behörde, die sich sogar schon im Aufbau befindet – obwohl der Entwurf noch nicht durch ist!

„Private Kommunikation wird also unter generalverdacht gestellt, während Kriminelle Nutzung weiterhin möglich bleibt.“ Eher WURDE statt wird. Laut https://www.theverge.com/2022/12/7/23498588/apple-csam-icloud-photos-scanning-encryption hat Apple seine Meinung geändert. Schlüsselwort ist „headed off“, also jetzt nicht mehr die Massen überwachen, sondern als Gegenleistung den Widerstand gegen das FBI aufgeben und mit den Ermittlern zusammenarbeiten um zu schauen, wo das CSAM Material denn her kam, und dann gezielt Trojaner auf den iPhones von Verdächtigen zu platzieren. Wenn Apple im Verdachtsfall kooperativ ist, dann hat das FBI auch nix mehr dagegen, dass die Masse verschlüsselt.

Ich stimme dir nur in Teilen zu. Zum einen wurde Apples Plan zum scannen nie eingesetzt.

WURDE passt also auch nicht ganz.

Zum anderen antwortest du auf einen Kommentar von mir, der sich auf die „Chatkontrolle“ der EU bezieht – nicht auf Apples Scan der Bilder.

Die Chatkontrolle soll – so der plan – komplett verdachtsunabhängig und damit anlasslos stattfinden.

Und das betrifft nach dem aktuellen Entwürfen alle Dienste, die Chats anbieten. Also auch der Chat in einem Spiel.

Dazu die Messenger Betreiber zu verpflichten wäre aber auch dämlich. Sollen sie es einfach auf OS-Ebene erzwingen. Als ob Apple, Google und Microsoft das nicht schon längst könnten.

Sie sollen es einfach gar nicht machen.

Dieser Vorschlag schreit aus allen Poren: „ich werde vom Europäischen Gerichtshof kassiert“.

Das ist anlasslose Massenüberwachung. Noch schlimmer als bei der Vorratsdatenspeicherung. Direkt auf deinem Gerät, mit direktem Draht zu Europol.

Selbstverständlich könnten Apple, Google und Microsoft soetwas technisch implementieren.

Der letzte Satz in deinem Kommentar klingt ein wenig wie „die machen das doch sowieso schon“.

Das ist aber zum jetztigen Zeitpunkt einfach nicht so.

kann man nur hoffen, dass du Recht hast

Hallo Fischkopf , „Private Kommunikation wird also unter generalverdacht gestellt, während Kriminelle Nutzung weiterhin möglich bleibt.“ ich hab leider nur zwei Daumen pro Hand , aber dennoch 10 Daumen hoch für diesen Beitrag. Schutz der Privatsphäre und das Recht auf unbeobachtete Kommunikation darf nicht eingeschränkt werden. Und wenn dann nur im _Einzelfall_ und nach vorherigem richterbeschluß, also mit ordentlichen Vorermittlungen. Zur not verschlüssele ich eben meine Texte bevor ich sie in den messenger Tippe mit einem externen Tool – copy und paste ins messengerffeld – und mein Gegenüber macht bei sich das gleiche. ausheblen kann man das sicher und auch für den „normalbürger“ sicher irgendwie anwenderfreundlich. gibt dann eben ne Zusatzapp „encode my text“ – den Schlüssel tauscht man dann über einen anderen Weg aus und gut ist. Sowas wie die Messengerüberwachung, wenn sie dann kommt , gehört ausgehebelt. Dann eben jeden Sch`verschlüsseln, damit die allein schon von der menge der notwendigen Entschlüsselungsarbeit für Bagatellmeldungen überfordert sind. So läßt sich das System dann gut aushebeln.

Hallo Andreas,

danke für den Kommentar.

Ich halte manuelle Verschlüsselung zwar für machbar – aber nicht für praktikabel.

Viele Leute verstehen die Mechanik hinter Verschlüsselung nicht. Sie verstehen auch nicht, wieso sie notwendig ist („ich hab doch nichts zu verbergen“). Viele Leute wissen auch nicht, dass es einfach pure Mathematik ist. Viele Leute denken auch „Die können doch sowieso alles mitlesen“.

Manuelle Verschlüsselung wäre also nur da praktikabel, wo man wirklich sensible Daten versendet. Dank asymmetrischer Verschlüsselung kannst du den Schlüssel übrigens auch gerne per Klartext durch die Welt senden – nicht umsonst heißt er „public Key“.

Verschlüsselung hat aber einfach der Standard zu sein – sonst ist bald jeder verdächtig, der verschlüsselt.

Leider ist das Thema „Chatkontrolle“ total unterpräsent. Es besteht die reelle Gefahr, dass dieses Thema einfach durchgewunken wird. Auch, weil auf Befürworter-Seite einfach nicht sachlich (und sogar falsch!) argumentiert wird. Für alle interessierten: https://chat-kontrolle.eu

Selbst, wenn man der aktuellen Regierung vertraut – eine zukünftige kann solche Dinge für sich auszunutzen wissen. Es gibt auf der Welt genug Unrechtsstaaten. Auch in der EU.

Klingt so als ob CSAM iCloud scanning ausgesetzt ist, was ja mit E2E nicht mehr geht. Aber von dem geplantem on Device scanning steht da nix.

Ja, dieses. Es waren immer zwei Sachen, 1. on device und 2. in der Cloud. Albern, dass das schon wieder untergegangen seien soll.

„Kinder können geschützt werden, ohne dass Unternehmen persönliche Daten durchkämmen.“

Genau das haben wir alle Apple gesagt. Google hat das nicht interessiert und ist in Amerika in den Modus „Polizei, Anklaeger und Richter in einer Firma“ gewechselt:

https://www.nytimes.com/2022/08/21/technology/google-surveillance-toddler-photo.html

Es ist genau das passiert, wovon man gewarnt hat. Unschuldiger Vater von Google angezeigt. Und es gibt sogar Leute, welche die Anmassung haben, dass man wissen muss, dass man die Google-Cloud fuer Arztfotos vorher abschalten muss und der Vater waere somit doch selbst schuld. Seit wann sind Opfer selbst schuld?

Sie haben genau gar nichts in unseren privaten Daten zu suchen.

Und wie „Fischkopf“ anmerkt, wir sind in Europa keineswegs sicher. Unsere Innenministern steht der frueheren SPD (Schily) wie erwartet in nichts nach. Die Aufgabe der Regierung ist der Schutz unserer Grundrechte.

Ich bin ein absoluter Google Fanboy, aber die Einführung der Ende-zu-Ende-Verschlüsselung für weitere Dateien in der iCloud finde ich sehr gut. Ich hoffe Google zieht da nach. Manche Dinge werden ja bereits verschlüsselt, wie Android-Backups etc.